Los modelos de fundación abiertos (FMs) están jugando un papel crucial en la evolución de la inteligencia artificial generativa, permitiendo a organizaciones crear aplicaciones de IA personalizadas mientras gestionan los costos y estrategias de implementación. Gracias a la disponibilidad de modelos de alta calidad, la comunidad de IA ha facilitado un intercambio rápido de conocimientos y soluciones asequibles. En este entorno, DeepSeek AI, una empresa de investigación, ha emergido como un importante contribuyente con sus modelos de lenguaje grande (LLMs) DeepSeek-R1, que abordan tareas desde la generación de código hasta el razonamiento general, manteniendo un desempeño competitivo.

Amazon Bedrock Custom Model Import es una herramienta innovadora en este campo, que permite la importación y uso de modelos personalizados junto con FMs existentes a través de una API unificada sin servidores. Esta funcionalidad otorga a las organizaciones acceso a modelos personalizados bajo demanda, eliminando la necesidad de gestionar una infraestructura compleja. Al combinar DeepSeek-R1 con Amazon Bedrock, las organizaciones pueden aprovechar al máximo las capacidades avanzadas de IA dentro de una infraestructura segura y escalable.

DeepSeek AI ha creado versiones destiladas de sus modelos DeepSeek-R1 basadas en arquitecturas de Meta, Llama y Qwen, que van desde 1.5 a 70 mil millones de parámetros. La destilación entrena modelos más pequeños y eficientes que replican el comportamiento de modelos más grandes, transfiriendo su conocimiento a estructuras más compactas. Estos modelos destilados, como DeepSeek-R1-Distill-Llama-8B y DeepSeek-R1-Distill-Llama-70B, ofrecen un equilibrio entre rendimiento y uso de recursos, posibilitando un procesamiento más rápido y reduciendo costos computacionales.

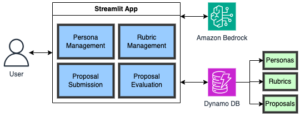

La implementación de estos modelos a través de Amazon Bedrock es directa. Los usuarios pueden importar los modelos desde Amazon Simple Storage Service (S3) o un repositorio de Amazon SageMaker y desplegarlos en un entorno administrado. Este enfoque sin servidores elimina la gestión de infraestructuras, mientras ofrece escalabilidad y seguridad.

Para implementar exitosamente, es crucial preparar el paquete del modelo, descargando y subiendo los artefactos al bucket de S3 en la región de AWS aplicable. Posteriormente, se importa el modelo a través de la consola de Amazon Bedrock. La prueba de estos modelos se facilita a través de Amazon Bedrock Playground, donde los usuarios pueden ajustar parámetros de inferencia y realizar pruebas.

DeepSeek ha publicado benchmarks que ilustran cómo sus modelos destilados conservan un 80-90% de las capacidades de razonamiento del modelo original DeepSeek-R1. Sin embargo, es esencial que las organizaciones evalúen los requisitos específicos de sus casos de uso, ya que modelos más grandes ofrecen un mejor rendimiento, mientras que los modelos más pequeños pueden ser adecuadamente eficientes para muchas aplicaciones a menor costo.

Finalmente, Amazon Bedrock Custom Model Import ofrece a las organizaciones la oportunidad de optar por modelos abiertos y personalizados, proporcionando flexibilidad clave para personalizar y optimizar implementaciones de IA, adaptándose a un entorno en constante cambio.