En un contexto donde los datos son fundamentales para el avance de aplicaciones, la necesidad de obtener información precisa y confiable ha alcanzado una magnitud sin precedentes. Los modelos de inteligencia artificial generativa, específicamente los grandes modelos de lenguaje (LLMs), emergen como una solución innovadora ante este reto. Estos modelos, basados en extensas bases de datos, tienen la capacidad de crear contenido nuevo que se despliega a través de diferentes formatos, desde texto hasta audio y video, abarcando múltiples dominios de negocio.

El sector financiero es uno de los principales beneficiados por esta tecnología. Instituciones como el ficticio Banco ABC están adoptando modelos de aprendizaje automático para evaluar el riesgo de contraparte en operaciones de derivados extrabursátiles (OTC). Estos productos financieros altamente personalizados, como los swaps y opciones, implican una gestión crítica de riesgos de contraparte, que conlleva la asignación de responsabilidades y riesgos financieros entre las partes implicadas.

La construcción de modelos de evaluación de riesgo precisos conlleva diversos desafíos. A pesar de la abundancia de datos, estos pueden estar sesgados o carecer de diversidad, comprometiendo la precisión del modelo. Para afrontar estos inconvenientes, se propone un enfoque innovador basado en inteligencia artificial generativa que incorpora la técnica de Generación Aumentada por Recuperación (RAG). Este método fortalece los LLMs mediante información adicional procedente de fuentes externas, no disponibles en su entrenamiento inicial.

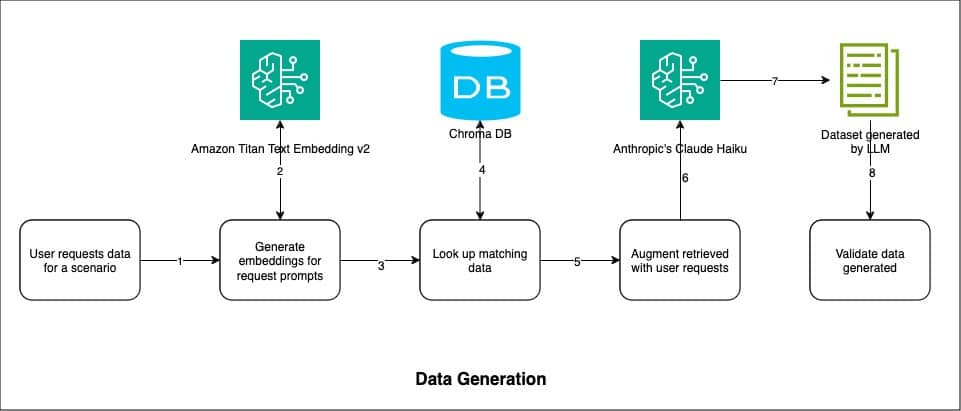

El proceso de implementación consta de tres etapas: indexación de datos, generación de datos y validación. En primer lugar, los datos de riesgo de contraparte son procesados y almacenados en una base de datos vectorial, permitiendo así búsquedas eficientes por similitud. Posteriormente, al generar nuevos datos, se busca coincidencias en la base de datos existentes y se alimenta a un modelo, como el conocido Claude Haiku de Anthropic, reconocido por su eficacia en el procesamiento y generación de datos de alta calidad.

La validación de los datos sintéticos generados es esencial para garantizar su calidad y confiabilidad. A tal fin, se emplean herramientas estadísticas como gráficos de cuantiles (Q-Q) y mapas de calor de correlación, que aseguran que los datos generados posean propiedades similares a los reales, previniendo patrones artificiales o sesgos que pudieran influir en las decisiones empresariales.

También es imperativo que las entidades financieras sigan prácticas de IA responsables, preservando la privacidad de los datos y asegurando el consentimiento adecuado para el uso de datos personales. La fusión de innovación tecnológica y consideraciones éticas permitirá que las organizaciones extraigan el máximo potencial de la inteligencia artificial, manteniendo al mismo tiempo la confianza de sus clientes.

En conclusión, la generación de datos sintéticos a través de modelos generativos proporciona una solución eficaz para la creación de conjuntos de datos en el ámbito financiero. Este enfoque no solo capacita a instituciones como el Banco ABC para evaluar con mayor precisión el riesgo de contraparte, sino que también facilita un entorno más seguro y fundamentado para la toma de decisiones en transacciones OTC.