Las universidades que lideran la investigación en inteligencia artificial (IA) y computación de alto rendimiento (HPC) enfrentan serios desafíos en su infraestructura tecnológica, ralentizando la innovación y complicando la obtención de resultados. Los clústeres tradicionales de HPC tienen dificultades para adaptarse a la demanda, debido a los largos ciclos de adquisición de GPU, límites estrictos de escalado y la complejidad del mantenimiento necesario. Esto afecta a los investigadores que trabajan en áreas clave como el procesamiento de lenguaje natural y la visión por computadora.

En respuesta a estos retos, Amazon SageMaker HyperPod ha emergido como una solución capaz de transformar el panorama de la investigación universitaria. Este sistema permite una escalabilidad rápida en las operaciones de desarrollo de modelos de IA, gestionando tareas como entrenamiento, optimización e inferencia en un clúster que puede abarcar cientos o miles de GPU avanzadas, como las NVIDIA H100 o A100.

Recientemente, una universidad líder en investigación adoptó SageMaker HyperPod para potenciar su trabajo en IA. Gracias a la integración de particiones dinámicas de SLURM, la gestión óptima de recursos de GPU, el control de gastos computacionales y un eficaz balanceo de carga en los nodos, esta tecnología permite a los investigadores acceder a herramientas avanzadas sin los problemas inherentes a la gestión de infraestructuras convencionales.

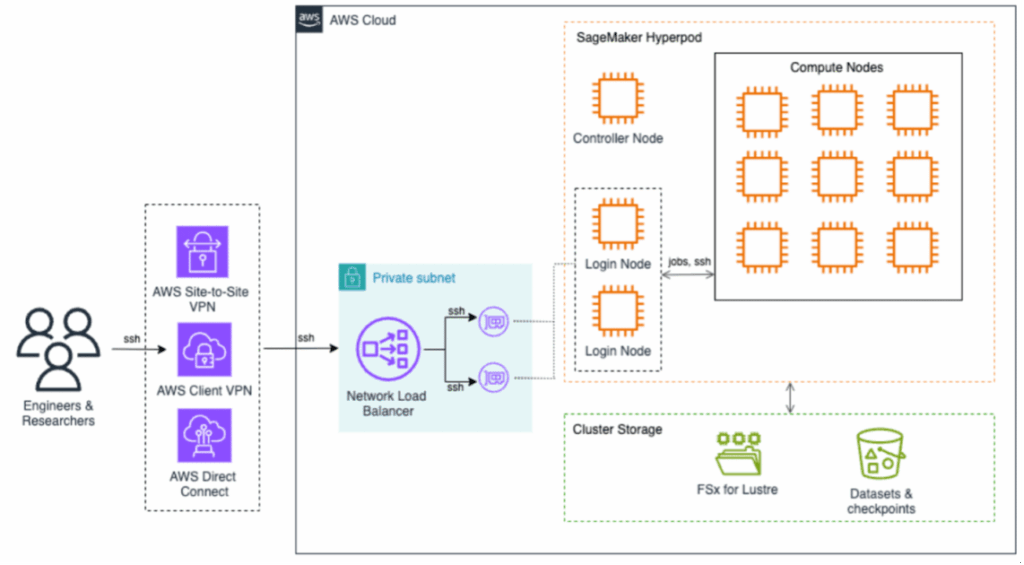

La arquitectura del sistema está completamente gestionada por AWS, lo que no solo reduce la carga operativa, sino que asegura altos niveles de seguridad y rendimiento. Los usuarios de SageMaker HyperPod pueden conectarse de forma segura, optimizando el tráfico de datos e incrementando la interacción con el clúster.

El almacenamiento se organiza mediante Amazon FSx para Lustre, que proporciona capacidades de archivos de alto rendimiento, y Amazon S3, asegurando un acceso eficiente y seguro a los datos cruciales para el entrenamiento de modelos de IA.

La implementación del sistema se realizó en varias fases, comenzando con la configuración de AWS y ajustando el clúster SLURM a las necesidades específicas de los investigadores. La habilitación de la configuración de recursos genéricos (GRES) permitió un uso más eficaz de los recursos de GPU por múltiples usuarios.

Para seguir los costos, cada recurso de SageMaker HyperPod se etiquetó individualmente, permitiendo un control detallado y mensual del gasto con herramientas como AWS Budgets y AWS Cost Explorer, garantizando así una utilización rentable de los recursos. Además, un sistema de balanceo de carga mejoró el acceso simultáneo de varios usuarios.

Finalmente, la integración con Active Directory facilitó un acceso seguro a los investigadores, permitiendo un control centralizado sobre las identidades y privilegios de usuario.

Este despliegue y personalización de SageMaker HyperPod está encaminado a revolucionar la investigación computacional en las universidades, permitiendo a las instituciones concentrarse en la innovación en IA y alcanzar sus objetivos científicos sin enfrentarse a los limitantes problemas de las infraestructuras tradicionales.