En plena avalancha de anuncios en AWS re:Invent 2025, Amazon ha dejado claro que no piensa quedarse atrás en la guerra del hardware para inteligencia artificial. La compañía ha presentado de forma oficial sus nuevos Amazon EC2 Trn3 UltraServers, sistemas basados en el chip Trainium3, y ha adelantado detalles de la próxima generación Trainium4, pensada para los modelos fundacionales más grandes de la próxima década.

Para un medio especializado en IA, el mensaje de fondo es claro: el cuello de botella ya no es solo el modelo, sino la infraestructura, y Amazon quiere que Trainium sea una alternativa real a las GPU tradicionales en entrenamiento e inferencia a gran escala.

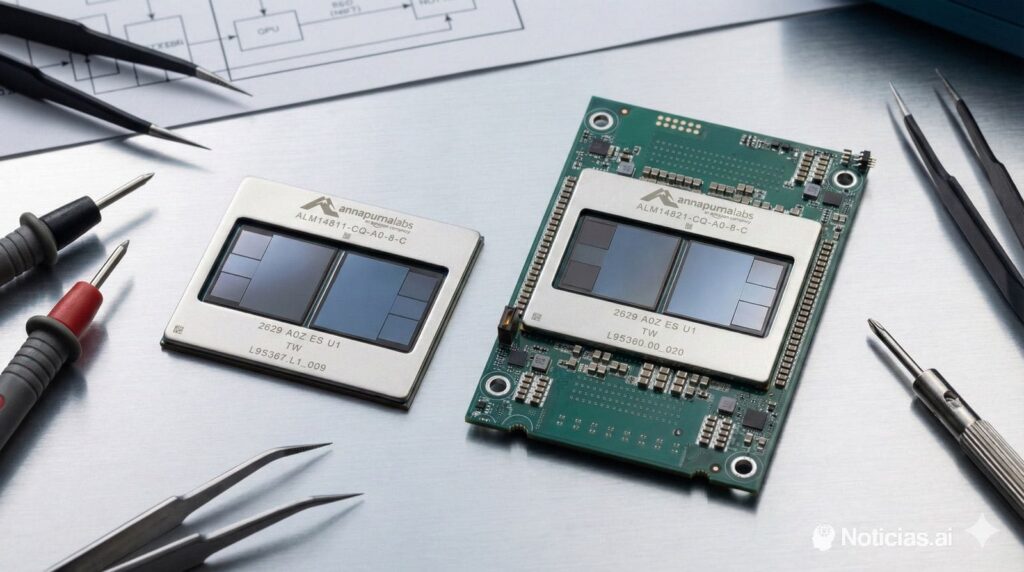

Qué es exactamente un Trainium3 UltraServer

Los nuevos Trn3 UltraServers son sistemas diseñados específicamente para cargas de trabajo de IA generativa y modelos de gran tamaño. Cada rack integrado puede agrupar hasta 144 chips Trainium3 en un mismo sistema, con:

- Hasta 4,4× más rendimiento de cómputo que la generación anterior de UltraServers basados en Trainium2.

- Hasta 4× más eficiencia energética.

- Casi 4× más ancho de banda de memoria, algo clave cuando se trabajan contextos largos y modelos multimodales.

En términos teóricos, un sistema completo alcanza hasta 362 PFLOPS en FP8 con una latencia interna mucho menor que la generación previa, gracias a mejoras tanto en el chip como en la interconexión.

El chip Trainium3 se fabrica en proceso de 3 nm, integra un subsistema de memoria optimizado para IA y está pensado para escalar horizontalmente. Todo ello apoyado por un stack de software verticalmente integrado (Neuron SDK, librerías, drivers y runtime) que intenta reducir el salto de un entorno GPU tradicional a este nuevo ecosistema.

Más chips, menos latencia: redes diseñadas para IA, no para “simple” cloud

Uno de los puntos que más llama la atención a nivel de arquitectura es la parte de red. Amazon no solo ha lanzado un nuevo chip: ha rediseñado el sistema como un todo para IA distribuida.

- El nuevo NeuronSwitch-v1 ofrece 2× más ancho de banda dentro del UltraServer.

- La Neuron Fabric reduce la latencia de comunicación entre chips a menos de 10 microsegundos, una cifra crítica cuando se reparte un mismo modelo entre decenas o cientos de aceleradores.

Sobre esta base, los EC2 UltraClusters 3.0 pueden conectar miles de UltraServers, con una escala teórica de hasta 1 millón de chips Trainium en un mismo clúster. Eso abre la puerta a:

- Entrenar modelos multimodales de trillones de tokens.

- Dar servicio de inferencia en tiempo real a millones de usuarios concurrentes.

Para el ecosistema de IA, esto no es solo un número espectacular: significa que la infraestructura necesaria para entrenar modelos de frontera deja de ser exclusiva de unos pocos laboratorios internos y pasa a estar disponible como servicio, aunque siga siendo un juego de “ligas mayores”.

Costes: reducir la factura de GPU sin perder rendimiento

El otro gran mensaje de Amazon va directo al CFO de cualquier compañía que esté apostando fuerte por IA generativa: Trainium3 promete recortar de forma notable la factura de cómputo.

Según los datos compartidos por la compañía, clientes como Anthropic, Karakuri, Metagenomi, NetoAI, Ricoh o Splash Music están logrando hasta un 50 % de reducción de costes de entrenamiento e inferencia frente a alternativas basadas en GPU de propósito general.

Un caso especialmente llamativo es el de Decart, un laboratorio centrado en modelos de vídeo generativo en tiempo real, que afirma conseguir:

- 4× más velocidad de inferencia (más frames por segundo).

- A la mitad de coste que con GPU tradicionales.

Además, Amazon Bedrock ya está sirviendo carga de producción sobre Trainium3, algo que envía un mensaje importante a todo el ecosistema: la propia casa lo está usando para sus servicios de IA gestionada, no solo como oferta para terceros.

A nivel de eficiencia, Amazon habla de un 40 % de mejora en consumo energético frente a la generación previa, una cifra especialmente relevante cuando se multiplican por miles o decenas de miles de chips en un clúster.

Casos de uso: de modelos fundacionales a vídeo generativo y agentes

Visto desde un medio especializado en IA, la propuesta de Trainium3 se cruza con varias tendencias claras:

- Modelos fundacionales cada vez más grandes, con contextos más largos, entradas multimodales (texto, imagen, audio, vídeo) y capacidades de razonamiento mejoradas.

- Agentes de IA y sistemas “agentic” que requieren inferencias frecuentes, de baja latencia y en muchas ocasiones con memoria a largo plazo.

- Mixture-of-Experts (MoE) y arquitecturas desagregadas, donde el modelo se compone de multitud de expertos especializados que se activan bajo demanda.

La combinación de alta densidad de cómputo, red optimizada y ancho de banda de memoria convierte a los UltraServers en una opción plausible para:

- Entrenar y servir modelos de frontera para chatbots avanzados, copilotos de código, asistentes de seguridad, etc.

- Ejecutar sistemas de vídeo generativo en tiempo real, como el caso de Decart.

- Desplegar agentes autónomos que puedan trabajar durante horas o días, integrados con servicios como los frontier agents y los modelos Nova que Amazon está impulsando desde Bedrock.

Trainium4: el siguiente salto… pensando en FP4 y racks compartidos con GPU

Si Trainium3 es el presente inmediato, Trainium4 representa el siguiente escalón en la estrategia de Amazon. Sin dar aún fechas concretas, la compañía ya ha adelantado algunos objetivos técnicos:

- ≥ 6× más rendimiento en FP4.

- 3× más rendimiento en FP8.

- 4× más ancho de banda de memoria que la generación actual.

La apuesta por FP4 confirma la dirección que está tomando el hardware de IA: bajar la precisión todo lo posible sin perder calidad de modelo, para exprimir cada vatio y cada milímetro cuadrado de silicio.

Quizá el dato más interesante para arquitecturas mixtas es que Trainium4 está siendo diseñado para integrarse con NVIDIA NVLink Fusion dentro de racks MGX comunes. En la práctica, esto significa:

- Poder mezclar servidores GPU de NVIDIA y servidores Trainium en el mismo rack.

- Integrar Trainium con procesadores Graviton y el adaptador de red Elastic Fabric Adapter (EFA) en una única arquitectura coherente.

Para muchos proveedores cloud, neoclouds y grandes empresas, esto apunta a un futuro donde no se elige “solo GPU” o “solo ASIC”, sino que se combinan ambos tipos de aceleradores según el tipo de carga: GPU donde importa la flexibilidad y el ecosistema, ASICs como Trainium donde manda la eficiencia y el coste por token.

Qué significa todo esto para el ecosistema de IA

Para un lector que siga de cerca el mercado, el movimiento de Amazon encaja en un patrón claro: todos los grandes quieren su propio stack de cómputo para IA.

- Google lleva años con sus TPU,

- Meta impulsa sus MTIA,

- Microsoft se apoya en chips propios y en la alianza con NVIDIA,

- y ahora AWS redobla su apuesta con Trainium3, Trainium4 y Graviton como piezas centrales de su estrategia.

La consecuencia directa es que el mercado de IA se está fragmentando a nivel de hardware y, a la vez, estandarizando a nivel de software: frameworks como PyTorch, JAX o herramientas de inferencia como vLLM permiten apuntar a distintas arquitecturas con cambios relativamente menores, siempre que el proveedor haga los deberes en drivers, SDK y librerías.

En ese contexto, Trainium3 UltraServers no son “un chip más”, sino un paso agresivo hacia una infraestructura de IA donde:

- La eficiencia energética y el coste por inferencia se convierten en KPI tan importantes como la calidad del modelo.

- La escala (clústeres de cientos de miles de chips) deja de ser un experimento de laboratorio y se convierte en producto comercial.

- La integración con servicios de alto nivel (Bedrock, agentes, Nova, etc.) hace que el cliente final no tenga que pensar en qué chip hay debajo… pero sí se beneficie en precio y rendimiento.

La batalla de los modelos continúa, pero la batalla del hardware de IA se está intensificando, y con Trainium3 y el futuro Trainium4, Amazon acaba de subir el listón para todos.