Las organizaciones que implementan agentes y sistemas basados en agentes se enfrentan a desafíos significativos al gestionar múltiples herramientas, invocar funciones y orquestar flujos de trabajo. Estos agentes requieren la integración de herramientas externas, como APIs o bases de datos, para realizar acciones o recuperar información que no poseen internamente. Esta integración puede complicar el escalado y la reutilización de herramientas en toda la empresa.

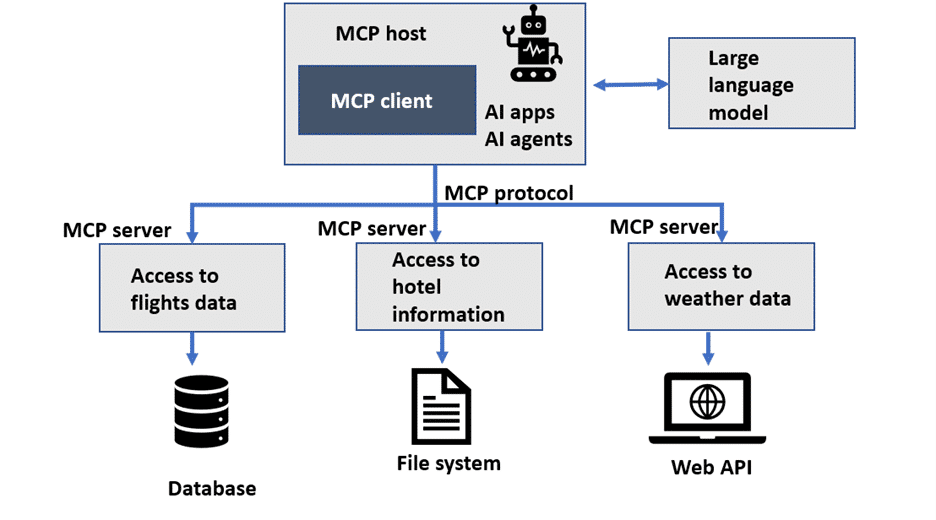

Para abordar estos desafíos, se ha presentado el Protocolo de Contexto del Modelo (MCP), que busca estandarizar el uso de canales, agentes, herramientas y datos de clientes. Esto promueve una experiencia fluida y eficiente para los usuarios, al eliminar la necesidad de tratar con sistemas fragmentados. MCP simplifica la integración de herramientas, permitiendo a los desarrolladores de agentes centrarse en la selección y el uso de estas, en lugar de en la creación de códigos de integración personalizados.

La implementación del MCP requiere una infraestructura escalable para servidores y para albergar modelos de lenguaje grande (LLM), que interactuarán con las herramientas del MCP. Amazon SageMaker AI es una solución que permite alojar LLMs sin preocuparse por el escalado, además de ser compatible con varias opciones de hospedaje de servidores MCP, como Amazon EC2, Amazon ECS, Amazon EKS y AWS Lambda.

El MCP representa un avance significativo respecto a las arquitecturas de microservicios tradicionales, proporcionando una interfaz de comunicación bidireccional en tiempo real. Esto facilita que los sistemas de IA se conecten a herramientas externas, servicios API y fuentes de datos, ideal para aplicaciones de IA que requieren acceso modular y fiable a múltiples recursos.

Existen diversas opciones para implementar servidores MCP, entre ellas FastAPI y FastMCP. FastMCP es adecuado para prototipos rápidos y situaciones donde la velocidad de desarrollo es crucial, mientras que FastAPI ofrece mayor flexibilidad y control para flujos de trabajo más complejos.

Esta arquitectura permite a las organizaciones optimizar sus procesos de integración de IA, reduciendo integraciones personalizadas y tareas de mantenimiento. Conectar modelos de manera segura a sistemas críticos se vuelve cada vez más valioso, permitiendo transformar el procesamiento de préstamos, agilizar operaciones y obtener perspectivas comerciales más profundas. A medida que la IA evoluciona, el MCP y el uso de SageMaker AI ofrecen una base flexible para futuras innovaciones.