Alibaba ha presentado Qwen3-Omni, un modelo de inteligencia artificial que nace con una ambición clara: trabajar de forma nativa y de extremo a extremo con texto, imágenes, audio y vídeo en un único sistema, sin intercambiar modelos por modalidad ni sacrificar prestaciones en el camino. El anuncio sitúa a la familia Qwen en el centro de la carrera por la omnimodalidad, una evolución natural de los multimodales que ya conocíamos —capaces, por ejemplo, de conversar y ver imágenes— pero que ahora aspiran a incorporar voz y vídeo como ciudadanos de primera clase dentro del mismo modelo.

La apuesta llega en un contexto en el que China empuja con fuerza el open source —con referencias recientes como DeepSeek R1— y donde la propia Alibaba Cloud ya había marcado terreno a comienzos de 2025 con Qwen 2.5. Qwen3-Omni es el siguiente salto: omnimodalidad nativa, baja latencia, soporte multilingüe amplio y un paquete “core” abierto que permite a la comunidad inspeccionar, adaptar y construir sobre él.

Qué significa “omnimodal nativo” (y por qué importa)

En la práctica, omnimodal nativo implica que el mismo modelo puede entender, razonar y generar en texto, imagen, audio y vídeo sin “puentes” o bridges externos que cambien de arquitectura entre modalidades. La promesa de Alibaba es no asumir “trade-offs” por modalidad: un único modelo end-to-end que integra percepción (ver/escuchar), razonamiento (pensar), fusión multimodal y generación (responder/hablar/crear) con latencias competitivas.

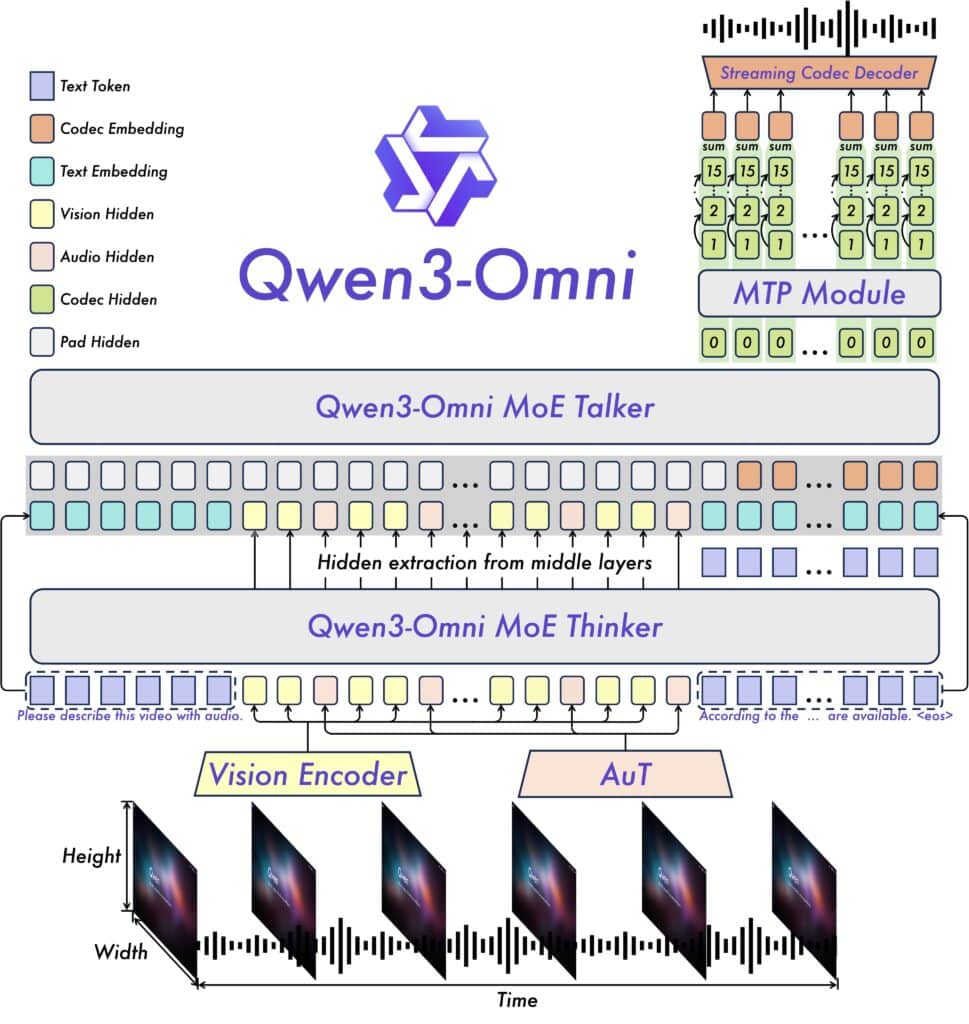

Qwen3-Omni introduce, además, una arquitectura de “Thinker-Talker”:

- Thinker es el módulo que genera el texto (el “pensamiento” que explica, resuelve y razona).

- Talker es el módulo que genera el audio (la “voz” que responde).

Este desacoplamiento interno permite conversación en tiempo real, lectura/entendimiento de audio de hasta 30 minutos y latencias bajas: ~211 ms para audio y ~507 ms cuando se combinan audio y vídeo, según los datos compartidos. La idea es responder rápido y de forma natural, evitando esperas largas típicas de pipelines encadenados.

Rendimiento y benchmarks: dónde gana (y dónde no)

Alibaba afirma que Qwen3-Omni alcanza SOTA (state of the art) en 22 de 36 benchmarks de audio, imagen y vídeo, superando a Gemini 2.5 Pro y GPT-4o en ese conjunto de pruebas. En WorldSense, Qwen3-Omni registra 54,1 %, por encima de 50,9 % de Gemini y 45,4 % de Qwen de la generación anterior, y en AIME25 y ZebraLogic —pruebas centradas en texto/lógica— “duplica” a Qwen anterior. En generación de imágenes vuelve a salir vencedor, mientras que en algunas pruebas de audio no siempre lidera frente a otros modelos punteros. El mensaje clave: un rendimiento globalmente superior frente a su predecesor (Qwen 2.5) y ventajas claras en varias áreas frente a GPT-4o y Gemini 2.5 dentro del set analizado.

Para escenarios de respuesta ultrarrápida, Alibaba presenta una variante Qwen3-Omni-Flash, situada por encima de Qwen 2.5-Omni-7B, GPT-4o y Gemini-2.5-Flash en las comparativas citadas por la compañía.

Cautela útil: los benchmarks reportados por el propio proveedor permiten tomar el pulso a la dirección técnica y comparar generaciones, pero conviene validar sobre tareas reales de cada organización antes de reemplazar flujos en producción.

Multilingüismo y latencia: del escritorio al mundo real

Cobertura por idioma:

- Texto: 119 lenguas.

- Entrada de voz: 19 lenguas.

- Salida de voz: 10 lenguas.

Latencia:

- Audio ~211 ms.

- Audio + vídeo ~507 ms.

Para aplicaciones en tiempo real —asistentes de atención al cliente, co-pilots de empresa, subtitulación y traducción simultánea— estas cifras permiten interacciones fluidas, uno de los grandes retos de la omnimodalidad a escala.

“Tool calling” y personalización por system prompts

Qwen3-Omni apuesta por el “tool calling” integrado: el modelo invoca herramientas externas (por ejemplo, un buscador, un intérprete o un “captioner” de baja alucinación) y devuelve la respuesta fusionada en modo texto/voz. Este patrón permite componer aplicaciones donde el modelo orquesta módulos especializados.

La personalización mediante system prompts —el “manual de estilo” o instrucciones de sistema que guían al modelo— aporta control fino: desde el tono de voz y el registro, hasta la política de seguridad o la preferencia por ciertos razonamientos intermedios.

Apertura (selectiva) del modelo: qué está disponible como open source

Alibaba ha publicado como código abierto varias piezas clave de la familia, con el foco en desarrolladores:

- Qwen3-Omni-30B-A3B-Instruct

- Qwen3-Omni-30B-A3B-Thinking

- Qwen3-Omni-30B-A3B-Captioner (este último, un captioner con baja alucinación)

La disponibilidad de estas variantes permite probar, auditar e integrar Qwen3-Omni en entornos locales o infraestructuras propias, y explorar casos de uso que van desde seguimiento de instrucciones hasta creatividad o captioning robusto.

Casos de uso que gana Qwen3-Omni (hoy)

- Asistentes conversacionales “todo en uno”

Capaces de ver (imágenes/vídeo), escuchar (voz), leer/escribir y responder tanto por texto como por voz en decenas de idiomas, con latencia baja. - Captioning de baja alucinación

El captioner abierto se orienta a describir lo que realmente hay en una imagen/vídeo, valioso para accesibilidad y indexación. - Traducción y subtitulado en tiempo real

Con 19 idiomas de entrada y 10 de salida en voz, y ~211 ms de latencia, habilita interpretación simultánea y subtítulos on the fly. - Edición y análisis de vídeo

Entender y responder con contexto sobre clips complejos, cronologías y eventos en vídeo, combinando preguntas y operaciones secuenciadas mediante tool calling. - Experiencias interactivas multimodales

Demostraciones, demos y aplicaciones creativas donde el usuario habla, muestra y pide resultados que vuelven en imagen/voz con respuestas casi instantáneas.

Comparación de alto nivel (sobre los datos aportados)

| Aspecto | Qwen3-Omni | GPT-4o / Gemini 2.5 |

|---|---|---|

| Omnimodalidad nativa | Sí (texto, imagen, audio, vídeo) | Multimodal avanzado; Qwen3-Omni subraya “end-to-end” |

| SOTA (22/36) | Sí, en audio/imagen/vídeo (conjunto citado) | Lideran en varias áreas; Qwen3-Omni reporta ventaja global en su set |

| WorldSense | 54,1 % | Gemini 50,9 %; Qwen previo 45,4 % |

| Latencia (audio / AV) | ~211 ms / ~507 ms | No indicado en el comunicado; comparables por clase |

| Idiomas (texto / voz in / voz out) | 119 / 19 / 10 | Soportes amplios; Qwen3-Omni publica cifras concretas |

| Open source | Sí (30B Instruct/Thinking/Captioner) | Abierto limitado (varía por proveedor) |

Nota: las cifras de Qwen3-Omni proceden del material de Alibaba; las comparativas deben validarse en entornos propios y con conjuntos independientes.

Limitaciones y puntos a vigilar

- Audio: el propio resumen de resultados reconoce que no siempre gana en todas las pruebas de audio. Según el caso de uso (reconocimiento ruidoso, acentos específicos, diarization), convendrá medir.

- Despliegue real: la latencia reportada en demos y benchmarks debe verificarse en infraestructura de cliente (redes móviles, navegadores, hardware heterogéneo).

- Privacidad y cumplimiento: al operar con voz y vídeo, la gestión de datos (almacenamiento, retención, consent) y las políticas de cada jurisdicción mandan.

- Evaluación abierta: aunque hay modelos liberados, Qwen3-Omni-Flash y otras variantes con mejores cifras pueden no estar abiertas; verificar licencias y pesos disponibles.

Para equipos técnicos: cómo empezar sin dolor

- Probar las variantes abiertas (30B) en Hugging Face / GitHub para validar fit con tareas internas (captioning, razonamiento, tool calling).

- Medir latencias reales de voz↔texto, visión y AV en navegador y móvil.

- Diseñar experiencias con system prompts (estilo, tono, seguridad) y tool calling (búsqueda, calculadoras, bases de datos).

- Plan B para audio: si su caso se apoya críticamente en ASR/TTS de un dominio específico, compare con alternativas donde Qwen3-Omni no encabece.

- Trazabilidad y seguridad: defina políticas de datos (voz/vídeo), consentimiento, redacción segura y registros de llamadas de herramienta.

Enlace con la estrategia open source de China

Qwen3-Omni encaja en una narrativa clara: modelos abiertos (al menos en parte) para generar adopción, acelerar investigación y competir en el plano internacional con opciones auditables que las empresas puedan autohospedar o ajustar. Junto con DeepSeek R1 y otros, contribuye a bajar barreras de entrada en omnimodalidad, un terreno donde hasta hace poco predominaban soluciones cerradas.

Conclusión

Qwen3-Omni no es “un multimodal más”: su planteamiento omnimodal nativo y su baja latencia apuntan a casos de uso en tiempo real donde hablar, ver y escuchar son igual de importantes que leer y escribir. Los resultados de SOTA en 22/36 benchmarks y los avances en WorldSense, AIME25 o ZebraLogic refuerzan la dirección técnica de la familia Qwen, mientras que la apertura de 30B Instruct/Thinking/Captioner crea puentes para que desarrolladores y equipos de producto experimenten sin coste de licencia.

¿Desplaza automáticamente a GPT-4o y Gemini 2.5? No necesariamente, y no en todos los dominios —el propio material matiza que en audio hay pruebas donde no lidera—, pero eleva el listón de manera tangible y, sobre todo, democratiza el acceso a un omnimodal end-to-end que se puede probar y adaptar desde hoy. Para quien diseñe asistentes reales, interpretación simultánea, captioning robusto o experiencias interactivas con voz e imagen en el navegador, Qwen3-Omni merece un hueco en la shortlist.

Preguntas frecuentes (SEO)

¿Qué diferencia a Qwen3-Omni de un multimodal “clásico”?

La omnimodalidad nativa end-to-end: un solo modelo que entiende y genera texto, imagen, audio y vídeo con baja latencia, sin “cambiar de red” según la modalidad.

¿En qué benchmarks destaca y a quién supera?

Reporta SOTA en 22/36 pruebas de audio, imagen y vídeo, con mejoras frente a Gemini 2.5 Pro y GPT-4o en ese conjunto. En WorldSense logra 54,1 % (vs. 50,9 % de Gemini y 45,4 % de Qwen previo). En AIME25 y ZebraLogic duplica a su predecesor. En audio no siempre lidera.

¿Qué latencias y cobertura de idioma ofrece?

~211 ms (audio) y ~507 ms (audio+vídeo). 119 idiomas en texto, 19 en voz de entrada y 10 en voz de salida.

¿Qué partes están disponibles como código abierto?

Se han liberado Qwen3-Omni-30B-A3B-Instruct, …-Thinking y …-Captioner. Se puede probar en Qwen Chat, GitHub, Hugging Face y ModelScope.

¿Para qué casos de uso es especialmente atractivo?

Asistentes en tiempo real (voz/imagen/vídeo), captioning de baja alucinación, traducción simultánea, análisis/edición de vídeo y experiencias interactivas con tool calling.

Enlaces de interés

- Qwen Chat (demo):

https://chat.qwen.ai/?models=qwen3-omni-flash - GitHub:

https://github.com/QwenLM/Qwen3-Omni - Hugging Face (colección):

https://huggingface.co/collections/Qwen/qwen3-omni-68d100a86cd0906843ceccbe - ModelScope:

https://modelscope.cn/collections/Qwen3-Omni-867aef131e7d4f - Demo (HF Spaces):

https://huggingface.co/spaces/Qwen/Qwen3-Omni-Demo