La fiebre por integrar modelos de Inteligencia Artificial en productos y procesos empresariales ha traído un problema silencioso: el desorden. OpenAI, Anthropic, Gemini y otros proveedores han acelerado sus catálogos y formatos de API, y muchas organizaciones han acabado con integraciones paralelas, claves repartidas, cambios de SDK que rompen pipelines y una observabilidad incompleta cuando algo falla en producción.

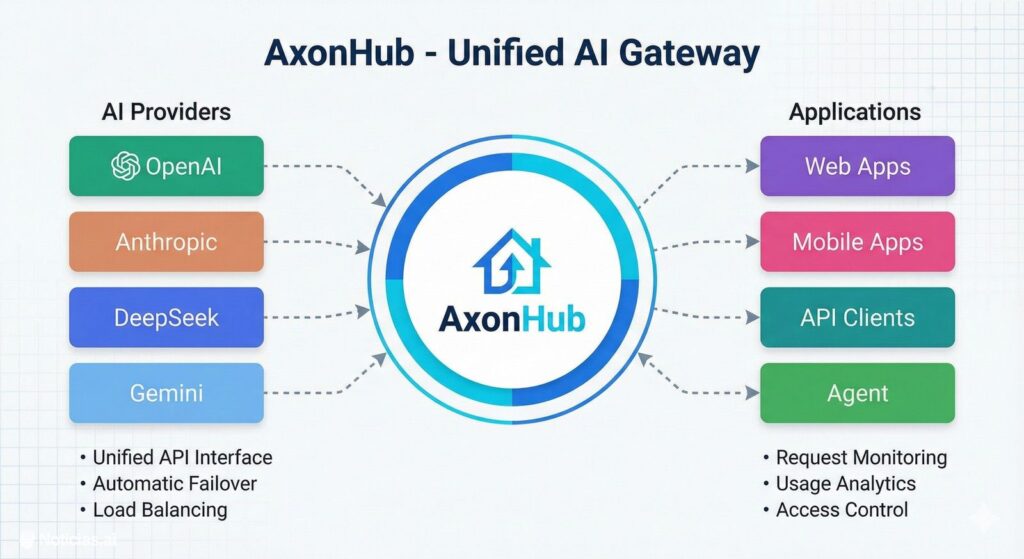

En ese contexto, el proyecto open source AxonHub se presenta como una propuesta ambiciosa: una plataforma “todo en uno” que combina gateway unificado, gestión por proyectos y herramientas de desarrollo, con el objetivo de que un mismo cliente —y el mismo estilo de llamada— pueda conectarse a distintos proveedores sin reescribir medio stack. Según su documentación pública, AxonHub actúa como una capa compatible con APIs al estilo OpenAI y Anthropic, y transforma las peticiones hacia diferentes proveedores mediante una arquitectura de “pipeline” de transformación.

Unificar sin perder control: traducción automática y menos fricción

La idea central es sencilla de explicar y difícil de ejecutar bien: usar un único “idioma” de API para hablar con múltiples modelos. AxonHub afirma ofrecer una interfaz compatible con OpenAI y Anthropic, con traducción automática, para acceder a cualquier proveedor soportado desde el mismo formato de solicitud.

Esta aproximación apunta directamente a uno de los miedos clásicos del sector: el vendor lock-in. En el propio repositorio se subraya ese valor de negocio: reducir el riesgo de migración y evitar atarse a un proveedor concreto.

Más allá del mensaje, el atractivo está en el día a día: equipos que prototipan con un proveedor, pasan a otro por coste o disponibilidad, y necesitan que el cambio no se traduzca en semanas de refactor. AxonHub intenta convertir esa transición en un cambio de canal, de configuración o de perfil, no en un nuevo proyecto.

Trazas y “threads”: cuando la depuración deja de ser una caza de fantasmas

Si el gateway es la promesa de simplicidad, la observabilidad es el argumento para producción. AxonHub integra tracing consciente de conversaciones (“threads”): registra cada solicitud y, si el cliente envía un encabezado AH-Trace-Id, puede “coser” varias peticiones dentro de una misma traza para seguir el viaje completo de una conversación. Si ese encabezado no llega, la petición queda registrada, pero sin vínculo automático con el resto de actividad.

En la práctica, esta filosofía se parece a un “cajón negro” para prompts, respuestas, tiempos y metadatos: no evita errores, pero promete acortar el diagnóstico cuando hay latencias extrañas, respuestas truncadas o caídas intermitentes.

Permisos finos y gobierno del acceso: el debate de la IA en equipos grandes

A medida que los departamentos adoptan IA, surge otra tensión: quién puede usar qué, con qué límites y con qué trazabilidad. El proyecto destaca políticas basadas en RBAC (control de acceso por roles) para gobernar acceso, uso y segregación de datos.

En entornos corporativos, donde conviven desarrolladores, analistas, producto y proveedores externos, esto suele ser decisivo: no es lo mismo habilitar un modelo “caro” para pruebas puntuales que permitirlo en una integración masiva sin control de llaves ni de cuotas.

Balanceo adaptativo y conmutación por error: alta disponibilidad “por diseño”

Otra pieza clave es el balanceo de carga adaptativo. La documentación del proyecto describe un sistema de selección inteligente de canal que tiene en cuenta salud, rendimiento y consistencia de sesión, con el objetivo de elegir automáticamente el canal “óptimo” para cada solicitud.

En su tabla de funcionalidades, AxonHub llega a cuantificar la ambición: conmutación por error con reintentos multicanal y balanceo, con “tiempo de interrupción” inferior a 100 ms (según el propio proyecto).

Ese tipo de cifra, habitual en documentación de producto, suele depender de condiciones reales de red y configuración; lo relevante aquí es el enfoque: diseñar para que un proveedor caído no obligue a tirar la toalla.

Qué cubre hoy: texto y embeddings maduros, imágenes en progreso

AxonHub enumera distintos tipos de API: generación de texto como “hecha”, rerank y embeddings también “hechos”, mientras que generación de imágenes aparece como “parcial” y las capacidades “realtime” figuran como pendientes.

Es un punto importante para quien busque una pieza central en su arquitectura: no todo el mundo necesita imágenes o tiempo real, pero cuando se necesitan, la “capa única” deja de ser única.

Despliegue: del portátil al servidor con bases de datos escalables

En cuanto a la puesta en marcha, el proyecto ofrece varias rutas: desde ejecución local hasta despliegues orientados a producción. En la documentación se muestran ejemplos con Docker Compose y una configuración basada en YAML y variables de entorno, con acceso típico en http://localhost:8090.

AxonHub también destaca una instancia de demostración en Render y publica credenciales de demo en su README, además de recomendar el despliegue propio para usos serios.

En lo relativo a licencias, el repositorio indica que el proyecto se distribuye bajo múltiples licencias (Apache-2.0 y LGPL-3.0), remitiendo al archivo LICENSE para el detalle.

Por último, el interés de la comunidad es visible en métricas públicas: el repositorio ronda 1.300 estrellas y supera el centenar de forks (cifras variables, consultadas en enero de 2026).

Preguntas frecuentes

¿Para qué sirve AxonHub en una empresa que ya usa OpenAI o Anthropic?

Para centralizar integraciones y operar con un gateway compatible, añadiendo trazabilidad por conversaciones, control de permisos y mecanismos de balanceo/conmutación por error sin obligar a cada equipo a adoptar SDKs distintos.

¿Cómo ayuda AxonHub a reducir el riesgo de dependencia de un proveedor de IA?

Porque propone unificar el formato de llamadas y traducirlas a diferentes proveedores, facilitando cambios de modelo o canal sin rehacer el cliente, lo que reduce el coste de migración cuando cambian precios, disponibilidad o requisitos.

¿Qué aporta el sistema de tracing con AH-Trace-Id en proyectos con chatbots o agentes?

Permite seguir una conversación de extremo a extremo, asociando múltiples peticiones a una misma traza. Es útil para depurar errores intermitentes, medir latencias por tramo y entender cómo evolucionan prompts y respuestas en producción.

¿Cuál es la forma más rápida de desplegar AxonHub para un equipo pequeño?

El proyecto describe despliegues directos y con Docker Compose, con una URL local típica en localhost:8090. Para pruebas rápidas también ofrece una demo pública, aunque para uso continuado suele ser preferible el despliegue propio.