Menos de medio año después de su debut, NVIDIA Blackwell Ultra ya ha dejado su huella en MLPerf Inference v5.1, el estándar de referencia más seguido para medir el rendimiento de inferencia en inteligencia artificial. La compañía presentó resultados que establecen nuevos récords en los ensayos incorporados este trimestre, con especial foco en razonamiento (DeepSeek-R1) y modelos de gran tamaño (Llama 3.1 405B y 8B), además del popular Whisper para reconocimiento de voz. En paralelo, NVIDIA enseñó músculo de plataforma con su rack GB300 NVL72, que ofrece una mejora de hasta el 45 % de rendimiento por GPU frente a los GB200 NVL72 basados en Blackwell, y con una visión de infraestructura que transformará los centros de datos en fábricas de IA.

El mensaje de fondo es nítido: la economía de la inferencia se decide en el throughput y en el coste por token. Cuantos más tokens por segundo pueda producir una instalación, mayor ingreso podrá generar al menor TCO posible. En ese tablero, Blackwell Ultra y el enfoque de serving desagregado de NVIDIA ponen distancia.

Qué ha cambiado con Blackwell Ultra

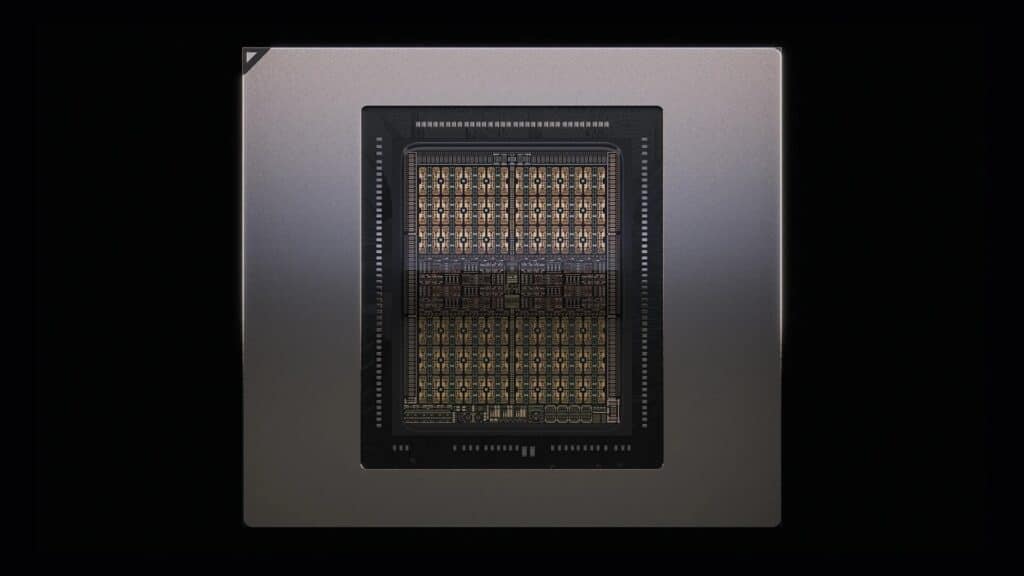

Sobre la base de Blackwell, la arquitectura Blackwell Ultra añade tres mejoras clave:

- 1,5× más cómputo NVFP4 para inferencia de baja precisión con exactitud comparable a formatos de mayor precisión.

- 2× aceleración en capas de atención, epicentro del coste de cómputo en LLM.

- Hasta 288 GB de HBM3e por GPU, lo que reduce presión de memoria y permite contextos más extensos y mayores lotes de servicio.

Ese salto se tradujo en hasta un 45 % más de rendimiento por GPU del rack GB300 NVL72 frente al GB200 NVL72 en la nueva prueba de razonamiento DeepSeek-R1, y en récords en todas las nuevas categorías de centro de datos de MLPerf v5.1: DeepSeek-R1, Llama 3.1 405B (Interactive), Llama 3.1 8B y Whisper. NVIDIA y sus socios también mantuvieron récords por GPU en el resto de pruebas del banco.

En cifras per-GPU reportadas por la plataforma de NVIDIA (métrica derivada a partir del throughput total):

- DeepSeek-R1: hasta 5 842 tokens/s (modo offline) y 2 907 tokens/s (server).

- Llama 3.1 405B: 224 tokens/s (offline), 170 tokens/s (server) y 138 tokens/s (interactive).

- Llama 3.1 8B: 18 370 tokens/s (offline), 16 099 tokens/s (server) y 15 284 tokens/s (interactive).

- Whisper: 5 667 tokens/s (offline).

Aun cuando MLPerf no toma la métrica “por acelerador” como principal, estos valores ofrecen una idea clara del techo de rendimiento que aporta Blackwell Ultra.

NVFP4 y optimización de pila: el binomio que sostiene los récords

Los resultados se apoyan en co-diseño de hardware y software. Blackwell y Blackwell Ultra incorporan aceleración nativa para NVFP4, un formato de coma flotante de 4 bits diseñado por NVIDIA. Con TensorRT Model Optimizer y TensorRT-LLM, la compañía cuantizó modelos como DeepSeek-R1 (pesos originalmente en FP8) a NVFP4 con objetivos de exactitud garantizados, reduciendo tamaño del modelo y maximizando el uso de los Tensor Cores.

Además, la KV-cache (clave para la fase de generación) se cuantizó a FP8 —desde BF16— para aliviar presión de memoria y elevar el throughput. En el caso de modelos MoE como DeepSeek-R1, se introdujeron paralelismos híbridos (expert parallel para MoE, data parallel para atención), nuevos kernels de comunicación gather/scatter y una técnica de balanceo, ADP Balance, que distribuye inteligentemente las consultas de contexto para mantener alto rendimiento sin degradar la latencia del primer token.

También hubo mejoras a bajo nivel con CUDA Graphs, que reducen la sobrecarga en CPU al “grabar y reproducir” secuencias del decode con una única invocación.

“Serving desagregado”: separar contexto y generación para ganar

La inferencia de LLM se compone de dos etapas con perfiles diferentes:

- Contexto (prefill): token-paralela y intensiva en cómputo; determina el TTFT (tiempo al primer token).

- Generación (decode): autoregresiva y sensitiva a latencia; condiciona el TPOT/ITL (tiempo por token de salida).

Correr ambas en la misma GPU malgasta recursos en entradas largas. El serving desagregado las separa en GPUs o nodos distintos, permitiendo paralelismos y asignación de GPUs a medida en cada fase. Con NVIDIA Dynamo como capa de orquestación, esta técnica fue decisiva para el nuevo escenario interactivo de Llama 3.1 405B, donde el GB200 NVL72 —gracias al desagregado— logró casi 1,5× más throughput por GPU que el serving tradicional con in-flight batching en un DGX B200; el salto agregado es >5× frente a un DGX H200.

El tejido de comunicación también es crítico: NVLink a 1 800 GB/s por GPU en dominios de 72 GPUs (hasta 130 TB/s agregados) mantiene las latencias de comunicación a raya en modelos de centenas de miles de millones de parámetros.

Ecosistema y disponibilidad: rendimiento “listo para producción”

NVIDIA y 15 socios —de Azure, Oracle y Google Cloud a Dell, HPE, Lenovo, Supermicro o Cisco— registraron resultados sobre plataformas Hopper, Blackwell y Blackwell Ultra, subrayando que el rendimiento de referencia ya está disponible en nube pública y servidores OEM a escala global. Para quien decide inversión, esto se traduce en menor TCO y mejor ROI en despliegues de inferencia en producción.

En paralelo, la compañía impulsa la visión de “AI factories”: centros concebidos como líneas de producción de inteligencia, con diseños de referencia y gemelos digitales en Omniverse (OpenUSD) que integran potencia, refrigeración, red y software desde el primer plano. El objetivo: optimizar cada vatio que entra al edificio para que genere tokens al menor coste posible.

Hopper no se queda atrás: más valor vía software

Aunque el foco mediático lo acapara Blackwell Ultra, Hopper sigue creciendo en valor vía optimización de software. En Llama 2 70B, el H100 elevó su throughput 1,5× frente al año pasado, y H200 lo llevó a 1,6×. Además, Hopper ejecutó todas las pruebas, incluidas Llama 3.1 405B, Llama 2 70B Interactive y GNN, reforzando su papel como caballo de batalla en inferencia y entrenamiento.

Rubin CPX asoma: la pieza para contextos millonarios

Como colofón técnico, NVIDIA enlazó estos resultados con el anuncio del acelerador Rubin CPX, una GPU especializada para la fase de contexto en cargas de >1 M de tokens (código y vídeo de larga duración). Si Blackwell/Ultra suben el listón del serving desagregado, Rubin CPX promete empujar el prefill aún más, y Vera Rubin NVL144 CPX llevaría la idea a 8 exaflops, 100 TB de memoria rápida y 1,7 PB/s de ancho de banda en un rack.

Claves que deja MLPerf v5.1

- Blackwell Ultra debuta con récords y hasta +45 % por GPU frente a GB200 en razonamiento.

- NVFP4 + TensorRT (Model Optimizer y LLM) consolidan la cuantización de alta precisión efectiva como palanca de rendimiento.

- El serving desagregado con Dynamo ya es mejor práctica para LLM interactivos de gran tamaño.

- La ventaja de plataforma (chips + red + software + ecosistema) se traduce en throughput y coste por token inferiores.

Preguntas frecuentes (FAQ)

¿Qué diferencia a Blackwell Ultra de Blackwell “a secas”?

Aporta 1,5× más cómputo NVFP4, 2× en atención y hasta 288 GB de HBM3e por GPU. En MLPerf v5.1, el rack GB300 NVL72 logró hasta un 45 % más de rendimiento por GPU que GB200 NVL72 en DeepSeek-R1.

¿Qué es NVFP4 y por qué importa para la inferencia?

Es un formato FP4 diseñado por NVIDIA y acelerado en Tensor Cores. Permite cuantizar modelos manteniendo exactitud objetivo y desbloquear más throughput con menos memoria y menor coste por token.

¿En qué consiste el “serving desagregado”?

Separa contexto (prefill) y generación (decode) en GPUs/nodos distintos. Cada fase usa paralelismos y recursos óptimos, mejorando TTFT, TPOT y aprovechamiento. Con Dynamo, fue clave para batir el nuevo Llama 3.1 405B Interactive.

¿Cómo encaja Rubin CPX en este panorama?

Rubin CPX es un acelerador dedicado al contexto largo (1 M+ tokens). En rack Vera Rubin NVL144 CPX suma 8 exaflops, 100 TB y 1,7 PB/s, pensado para codificación de vídeo larga y codebases completas con ROI elevado.

vía: blogs.nvidia y developer.nvidia