Anthropic ha presentado Claude Sonnet 4.5, su nuevo modelo de frontera orientado a programación, agentes y uso directo del ordenador. La compañía afirma que es su modelo más capaz y más alineado hasta la fecha, con mejoras de calado en razonamiento, matemáticas y orquestación de herramientas, y lo acompaña de un paquete de novedades en producto —desde un SDK para agentes hasta un plugin nativo para VS Code, pasando por ejecución de código y creación de archivos dentro de las apps de Claude—. El modelo ya está disponible en la Claude API y, de forma nativa, en Amazon Bedrock y Google Cloud Vertex AI, con el mismo precio que Sonnet 4 (3 $/15 $ por millón de tokens de entrada/salida).

La apuesta tiene dos mensajes claros: elevar el listón del “coding con IA” y dar a terceros los ladrillos con los que Anthropic ha construido sus propios productos agénticos.

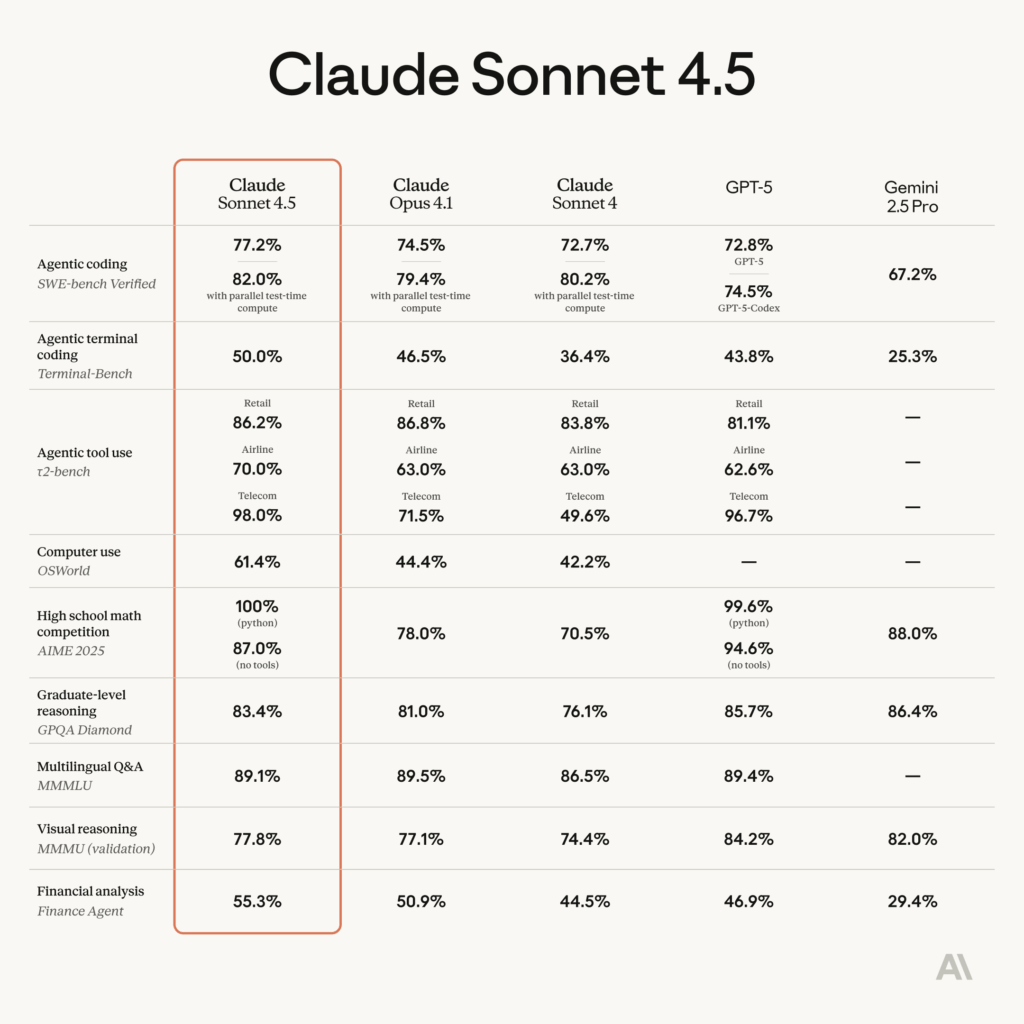

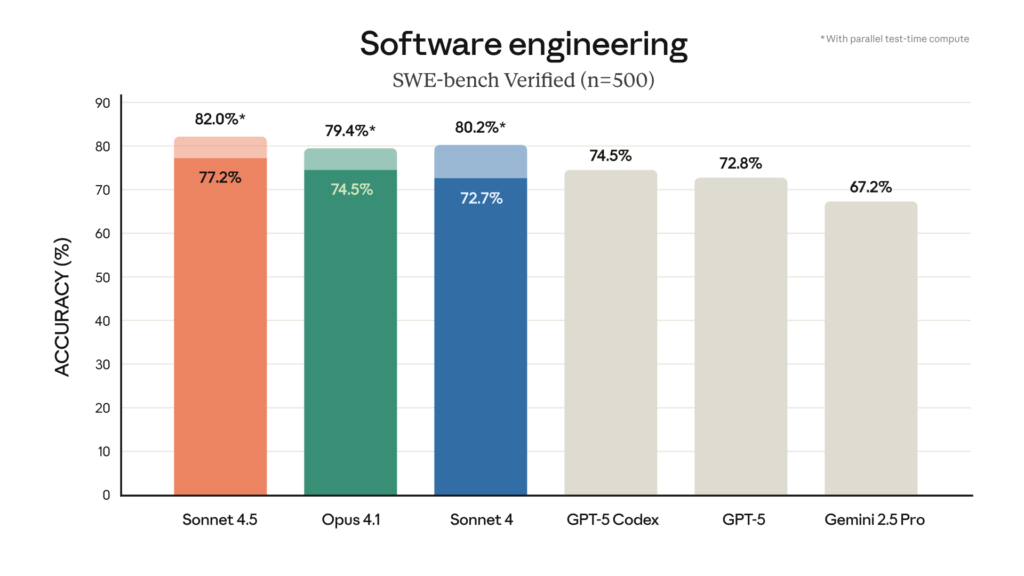

Resultados en benchmarks: salto en código, uso del ordenador y tareas agénticas

Según la ficha técnica publicada por Anthropic, Claude Sonnet 4.5 lidera varias pruebas públicas:

- SWE-bench Verified (resolución de incidencias reales en repositorios de software): 77,2 % de aciertos de media en 10 corridas con thinking de 200 K tokens y sin cómputo en test-time. Con estrategias de paralelización y selección de parches en inferencia, el modelo alcanza 82,0 %.

- OSWorld (uso de ordenador en tareas reales): 61,4 %; cuatro meses antes, Sonnet 4 marcaba 42,2 %.

- Terminal-Bench (agente en terminal): 50,0 %, por encima de Sonnet 4 (36,4 %) y de la cifra citada para GPT-5 (43,8 %).

- τ2-bench (uso agéntico de herramientas en dominios verticales): en el escenario Retail Sonnet 4.5 anota 86,2 % (Sonnet 4: 83,8 %); en Airline, 70,0 % (Sonnet 4: 63,0 %); en Telecom, 98,0 % (Sonnet 4: 49,6 %).

- AIME 2025 (matemáticas de secundaria): 100 % con Python y 87,0 % sin herramientas (Sonnet 4: 70,5 % y — respectivamente; para GPT-5 se citan 99,6 % con Python y 94,6 % sin herramientas; Gemini 2.5 Pro: 88,0 %).

- GPQA Diamond (razonamiento a nivel de posgrado): 83,4 % (Opus 4.1: 81,0 %; GPT-5: 85,7 %; Gemini 2.5 Pro: 86,4 %).

- MMLU multilingüe: 89,1 % (promedio en 14 idiomas, con extended thinking).

- MMMU (validación, razonamiento visual): 77,8 %.

- Finance Agent (tareas de análisis financiero, leaderboard de Vals AI): 55,3 % (GPT-5: 46,9 %; Gemini 2.5 Pro: 29,4 %).

Metodología. Anthropic detalla en la system card cómo ejecuta cada evaluación (número de corridas, límites de tokens de razonamiento, herramientas permitidas, selección de parches en test-time, etc.). Para SWE-bench Verified, por ejemplo, reporta como cifra principal el resultado con 200 K tokens de razonamiento (no el de 1 M), y aclara que el 82,0 % requiere cómputo paralelo y rechazo de parches que rompen tests visibles.

Más allá de las tablas, la compañía asegura que Sonnet 4.5 mantiene el foco durante más de 30 horas en tareas complejas y de múltiples pasos, un requisito clave para agentes de largo horizonte.

Producto: más capacidad… y herramientas de desarrollo para terceros

El anuncio no se limita al modelo. Anthropic ha actualizado Claude Code, sus apps y su plataforma para desarrolladores:

- Claude Code

- Checkpoints (muy solicitados): guardan estados intermedios de una tarea larga y permiten “rollback” instantáneo.

- Terminal renovado y extensión nativa para VS Code.

- Apps de Claude (web/desktop)

- Ejecución de código y creación de archivos (hojas de cálculo, presentaciones, documentos) dentro de la conversación.

- Extensión de Chrome disponible para usuarios Max que se apuntaron a la lista de espera el mes pasado.

- Claude API / Developer Platform

- Context editing para limpiar contexto obsoleto de forma automática en tareas largas sin chocar continuamente con el límite de ventana.

- Memory tool para almacenar y consultar información fuera de la ventana de contexto, útil en agentes que deben persistir conocimiento entre sesiones.

- Claude Agent SDK: la misma infraestructura que impulsa Claude Code —gestión de memoria en ejecuciones largas, permisos que equilibran autonomía y control humano, coordinación de subagentes— ahora disponible para que equipos externos construyan sus propios agentes.

- “Imagine with Claude” (vista previa de investigación)

- Un experimento temporal para suscriptores Max (cinco días) en el que Claude genera software en tiempo real, sin funcionalidad preescrita, como demostración del potencial de Sonnet 4.5 cuando se combina con la infraestructura adecuada.

El posicionamiento de Anthropic es claro: dar a terceros los mismos bloques de construcción con los que la empresa ha resuelto problemas espinosos en agentes —memoria de largo recorrido, permisos, subagentes, tool use paralelo—.

Seguridad y alineamiento: ASL-3 y menos falsos positivos en clasificadores

Anthropic califica a Sonnet 4.5 como su modelo de frontera más alineado hasta la fecha y lo publica bajo protecciones ASL-3 (AI Safety Level 3), que asocian capacidades con salvaguardas apropiadas. Entre ellas destacan clasificadores que buscan entradas/salidas potencialmente peligrosas, con foco especial en CBRN (riesgos químicos, biológicos, radiológicos y nucleares).

La compañía reconoce que estos filtros pueden marcar en exceso contenido benigno, pero asegura haber reducido los falsos positivos ×10 desde su explicación inicial y ×2 desde el lanzamiento de Opus 4 (mayo). Cuando el clasificador interrumpe una conversación, facilita continuarla con Sonnet 4, que la empresa considera de menor riesgo CBRN.

En su system card, Anthropic publica por primera vez tests de seguridad que incluyen técnicas de interpretabilidad mecanicista y muestra gráficos con puntuaciones de “comportamiento desalineado” (cuanto más bajo, mejor) en dimensiones como adulación, engaño, búsqueda de poder o refuerzo de creencias delirantes.

Ecosistema: de Copilot a Canva y Figma, primeras impresiones de clientes

La nota de Anthropic recoge impresiones de primeros usuarios —desde herramientas para desarrolladores hasta diseño y seguridad— que apuntan a menos errores en edición de código, mejor planificación y más éxito en tareas largas:

- Equipos como Cursor reportan “rendimiento de vanguardia” en horizontes largos.

- En GitHub Copilot, evals iniciales apuntan a mejoras en razonamiento multietapa y comprensión de código, habilitando experiencias agénticas que abarcan múltiples repositorios.

- Canva y Figma describen avances en prototipado funcional y calidad de interacción, con un modelo “notablemente más inteligente” en tareas de larga memoria.

- En seguridad, un caso cita -44 % de tiempo medio de ingestión de vulnerabilidades y +25 % en precisión para agentes Hai.

- En legal, se mencionan borradores de opiniones judiciales tras analizar ciclos completos de escritos, o síntesis de registros de litigio para mociones de summary judgment.

- En finanzas institucionales, con thinking on, se habla de insights de nivel inversión que requieren menos revisión humana.

Estos testimonios son cualitativos; el detalle cuantitativo está en los benchmarks públicos y en la system card.

¿Qué implica para el “coding con IA” y los agentes?

Tres vectores concentran el impacto:

- Calidad + coste constante

Mantener el precio de Sonnet 4 con saltos medidos en SWE-bench, Terminal-Bench y τ2-bench sugiere que tareas complejas —editar grandes bases de código, arreglar builds, orquestar herramientas— bajan su coste efectivo por resolución correcta. - Uso del ordenador (OSWorld)

El 61,4 % da aire a experiencias en navegador (extensión de Chrome) y a agentes capaces de rellenar hojas de cálculo, tomar acciones en UI y conciliar datos entre aplicaciones. La nota describe navegación, carga de sitios, completado de formularios y generación de archivos “desde la conversación”. - Infraestructura para construir agentes

Abrir el Agent SDK y añadir context editing y memory a la API elimina fricciones clásicas: contexto que se “apolilla”, estado que se pierde entre pasos, y permisos que antes eran “todo o nada”. Para quien construye agentes “de jornada completa”, esto es operatividad.

Disponibilidad y precio

- Modelo: claude-sonnet-4-5, disponible hoy en la Claude API, Amazon Bedrock y Vertex AI.

- Precio: igual que Sonnet 4 (3 $/15 $ por millón de tokens).

- Producto: actualizaciones de Claude Code (terminal, VS Code, checkpoints) y apps (ejecución de código y creación de archivos).

- Plataforma: Agent SDK, context editing y memory tool en la Claude Developer Platform.

- Extra: “Imagine with Claude” para suscriptores Max, 5 días.

Anthropic recomienda actualizar a Sonnet 4.5 en todos los usos: en apps, API y Claude Code es un sustituto directo con mejor rendimiento al mismo precio.

Mirando al corto plazo

El mercado de modelos de frontera se mueve rápido. Con Sonnet 4.5, Anthropic responde al desafío de agentes y “computer use” poniendo sobre la mesa mejores números y, sobre todo, las piezas de infraestructura con las que cree que se construye una experiencia robusta: memoria, permisos, subagentes, ejecución paralela de herramientas y checkpoints. El siguiente capítulo, para clientes y builders, será medir en sus casos reales si los avances en benchmarks se traducen en resoluciones más fiables, menos reintentos y costes controlados.

Preguntas frecuentes

¿En qué mejora Claude Sonnet 4.5 frente a Sonnet 4 en tareas de código?

Según Anthropic, Sonnet 4.5 lidera SWE-bench Verified con 77,2 % (y 82,0 % con cómputo paralelo en inferencia) y Terminal-Bench con 50,0 %. Además, añade checkpoints en Claude Code, extensión de VS Code, ejecución de código en las apps y un Agent SDK para crear agentes con memoria, permisos y subagentes.

¿Qué significa que “usa mejor el ordenador”?

En OSWorld, que evalúa tareas reales en un equipo (navegar, rellenar formularios, manejar archivos), Sonnet 4.5 marca 61,4 %, muy por encima del 42,2 % de Sonnet 4 hace cuatro meses. En la práctica, habilita flujos donde el modelo opera aplicaciones desde la extensión de Chrome y genera archivos (hojas, presentaciones, documentos) dentro del chat.

¿Qué cambios hay en seguridad y alineamiento?

El modelo se publica con protecciones ASL-3. Anthropic asegura menos falsos positivos de los clasificadores (×10 desde su primer anuncio, ×2 desde Opus 4) y publica tests de alineamiento y evaluaciones de seguridad —incluida interpretabilidad mecanicista— en la system card. Si un clasificador interrumpe una conversación, es posible continuarla con Sonnet 4.

¿Cómo empiezo a construir agentes propios con el nuevo SDK?

El Claude Agent SDK expone la infraestructura que usa Claude Code: memoria para tareas largas, gestión de permisos (autonomía vs. control del usuario) y coordinación de subagentes. En la Claude API se han añadido context editing (para limpiar contexto rancio) y memory tool (persistencia fuera de la ventana) para evitar límites en tareas de largo recorrido. El modelo se consume como claude-sonnet-4-5 al mismo precio que Sonnet 4.

vía: anthropic