Las empresas del sector asegurador enfrentan desafíos significativos al procesar grandes volúmenes de datos no estructurados, provenientes de diversos formatos como PDFs, imágenes, videos y archivos de audio. Documentos de reclamación, videos de accidentes o transcripciones de chats contienen información crucial durante el ciclo de procesamiento de reclamaciones.

Los métodos tradicionales de preprocesamiento presentan limitaciones en precisión y consistencia, lo que afecta la extracción de metadatos y la eficacia del análisis impulsado por inteligencia artificial para la detección de fraudes y el análisis de riesgos. Para mitigar estos problemas, se ha desarrollado un sistema colaborativo de múltiples agentes especializados en clasificación, conversión y extracción de metadatos.

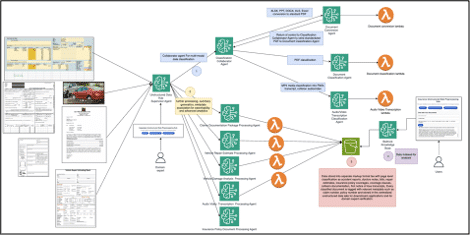

Este sistema automatiza la ingesta y transformación de datos no estructurados, mejorando la precisión del análisis. Para volúmenes pequeños y homogéneos, un solo agente puede ser suficiente. Sin embargo, para datos diversos, una estructura de múltiples agentes es más ventajosa, ofreciendo ingeniería de prompts dirigida, mejor depuración y extracción precisa.

El diseño modular del sistema permite una escalabilidad eficiente, facilitando la incorporación de nuevos agentes y la mejora continua mediante el feedback de expertos. Además, Amazon Bedrock, un servicio gestionado, respalda la creación de agentes cognitivos que pueden operar a gran escala, mejorando tanto flujos de trabajo como la precisión del procesamiento.

Este centro de preprocesamiento clasifica datos entrantes, extrae metadatos clave y convierte documentos a formatos uniformes. Los resultados alimentan un lago de datos enriquecido, fundamental para la detección de fraudes y análisis avanzados. El flujo de trabajo integra un agente supervisor, agentes especializados y Amazon S3 como destino de datos, promoviendo una gestión más robusta.

Con estos avances, se espera minimizar la intervención humana y mejorar la precisión de la extracción de datos. La integración de experticia humana en el ciclo de validación asegura una mejora continua en la calidad de los datos. En última instancia, la transformación de datos no estructurados permite optimizar procesos críticos, acelerar la detección de fraudes y facilitar decisiones informadas, estableciendo un nuevo estándar en el procesamiento de reclamaciones para el sector asegurador.