Los modelos de lenguaje de gran escala (LLMs, por sus siglas en inglés) han revolucionado la interacción entre humanos y computadoras, permitiendo una comunicación más natural con las aplicaciones. No obstante, en situaciones del mundo real, resulta esencial manejar flujos de trabajo intrincados, conectarse a datos externos y coordinar múltiples capacidades de inteligencia artificial. Imaginemos la posibilidad de programar una cita médica: un agente de inteligencia artificial revisa el calendario, accede al sistema del médico, verifica el seguro y confirma la cita en un único paso. Esta capacidad podría cambiar por completo la experiencia del usuario.

Los agentes de LLM funcionan como gestores de toma de decisiones que determinan el flujo operativo de las aplicaciones. Sin embargo, al enfrentarse a operaciones a gran escala, surgen múltiples desafíos, como la ineficiencia en la selección de herramientas, las limitaciones en la gestión del contexto y la necesidad de especialización en áreas concretas como planificación y análisis. La arquitectura de múltiples agentes emerge como una solución, al fraccionar el sistema en agentes más pequeños y especializados que actúan de manera independiente. Este enfoque modular mejora no solo la eficiencia del sistema, sino también su capacidad de escalar, lo que es esencial para aplicaciones basado en LLM.

AWS, dentro de Amazon Bedrock, ha introducido una capacidad de colaboración entre múltiples agentes, propiciando que los desarrolladores puedan construir y manejar agentes de inteligencia artificial que, trabajando en conjunto, asuman tareas complejas. Esta nueva estrategia incrementa la tasa de éxito en la realización de tareas, además de mejorar la precisión y productividad en procesos que requieren múltiples pasos.

En los sistemas de un solo agente, la planificación implica dividir tareas en secuencias manejables. No obstante, los sistemas de múltiples agentes deben coordinar flujos de trabajo distribuidos entre ellos, demandando un mecanismo donde cada agente se alinee hacia el objetivo general. Esto acarrea desafíos únicos, como la gestión de dependencias entre los agentes y la asignación de recursos, requiriendo marcos sólidos que mantengan coherencia y optimización en el rendimiento global.

La gestión de memoria en la inteligencia artificial difiere notablemente según la arquitectura. Los sistemas con un solo agente emplean una estructura de memoria a corto y largo plazo, junto a fuentes de datos externas. Por otro lado, los sistemas de múltiples agentes necesitan recursos más avanzados para manejar y sincronizar datos contextuales a través de diversos agentes.

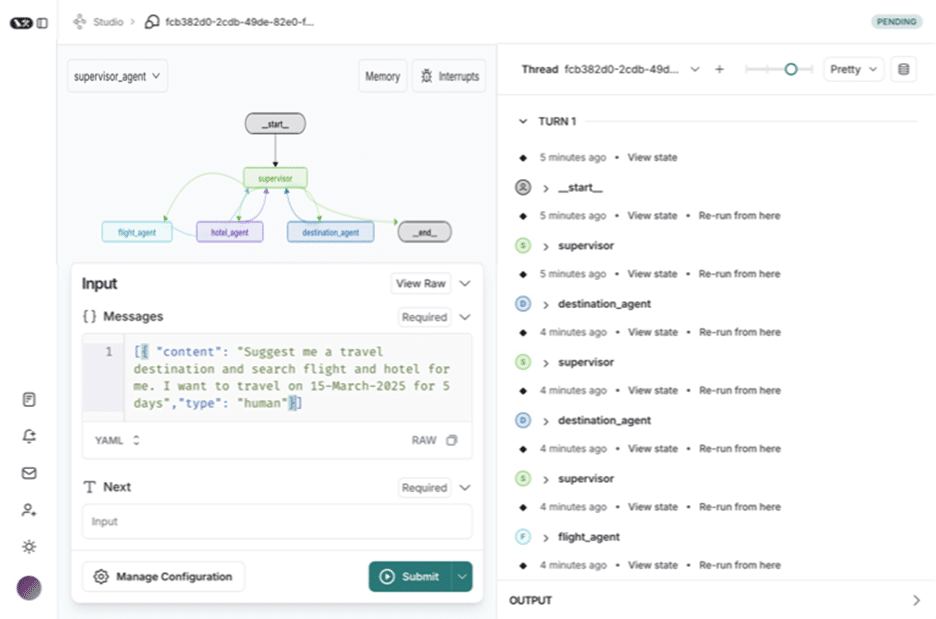

LangGraph, parte de LangChain, coordina flujos de trabajo entre varios agentes a través de una arquitectura gráfica, manejando procesos complejos y manteniendo el contexto dentro de las interacciones. LangGraph Studio, un entorno de desarrollo integrado, facilita la creación de aplicaciones con un enfoque multi-agente, dando herramientas para visualización, monitoreo y depuración en tiempo real.

Este marco implementa grafos dirigidos y máquinas de estado, proporcionando un control detallado sobre el flujo y estado de las aplicaciones de los agentes. La arquitectura no solo gestiona memoria, sino que también permite la intervención humana en procesos críticos.

Un ejemplo ilustrativo expone un agente supervisor que coordina agentes especializados para crear un asistente de viaje, gestionando desde recomendaciones de destino hasta la búsqueda de vuelos y alojamientos. Esta integración de marcos de múltiples agentes establece una base robusta para desarrollar sistemas avanzados de inteligencia artificial, prometiendo optimizar la experiencia del usuario y la efectividad operativa de las aplicaciones.