En el competitivo mundo de la inteligencia artificial, la comunidad científica y tecnológica se ha sorprendido con el reciente lanzamiento de DeepSeek-R1, un modelo de razonamiento que ha generado gran expectación tras «romper internet» y sacudir incluso el mercado bursátil. Este avance ha impulsado a diversos investigadores a replicar y profundizar en la metodología empleada, dando origen al ambicioso proyecto Open-R1.

Innovación en el entrenamiento de modelos

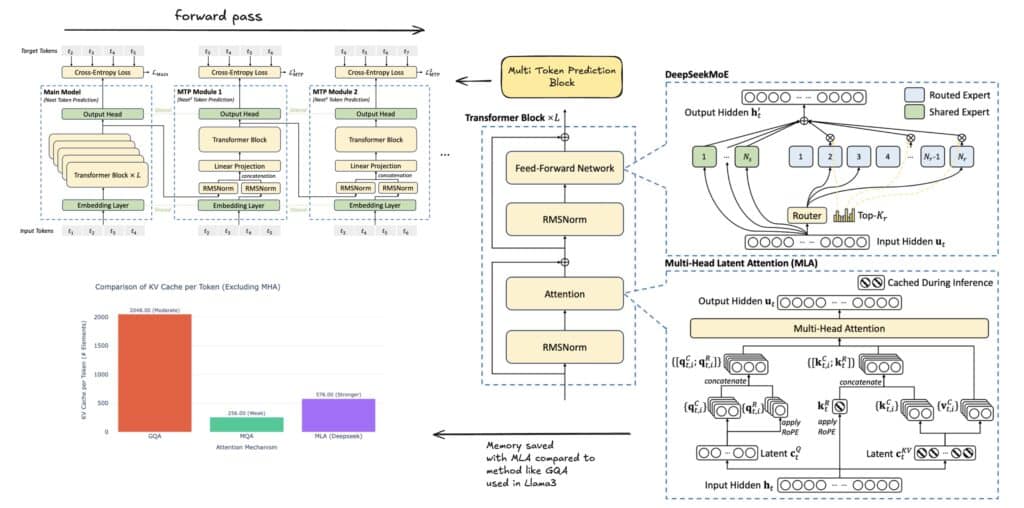

DeepSeek-R1 se basa en la consolidada arquitectura de DeepSeek-V3, un modelo Mixture of Experts (MoE) de 671 B, que ha demostrado un rendimiento equiparable al de otros gigantes como Sonnet 3,5 y GPT‑4. Su entrenamiento, que supuso una inversión de tan solo 5,5 M dólares, se vio beneficiado por innovaciones técnicas como la Predicción de Múltiples Tokens (MTP) y la Atención Latente de Múltiples Cabezas (MLA), además de numerosas optimizaciones de hardware.

El proceso de formación de DeepSeek-R1 se ha destacado por su uso intensivo de aprendizaje por refuerzo (RL). Dos variantes, DeepSeek-R1‑Zero y DeepSeek-R1, se desarrollaron siguiendo enfoques distintos. La primera prescindió del ajuste supervisado, basándose únicamente en RL mediante Group Relative Policy Optimization (GRPO). Este método se apoyó en un sistema de recompensas sencillo que evaluaba la precisión y la estructura de las respuestas, permitiendo que el modelo desarrollase habilidades de razonamiento como descomponer problemas complejos y validar sus propias salidas, aunque a costa de una mayor dificultad en la claridad de sus respuestas.

Ante esta limitación, la versión DeepSeek-R1 incorporó una fase inicial de «cold start» en la que se realizó un ajuste fino con un pequeño conjunto de ejemplos meticulosamente seleccionados para mejorar la claridad y legibilidad. Posteriormente, se aplicaron nuevas rondas de RL y procesos de refinamiento que incluyeron el rechazo de salidas de baja calidad mediante recompensas verificables y basadas en preferencias humanas, logrando así un modelo que no solo razona de forma acertada, sino que también ofrece respuestas pulidas y coherentes.

El reto de la transparencia y el surgimiento de Open-R1

Aunque la publicación de DeepSeek-R1 ha supuesto un avance notable, la comunidad ha observado que la iniciativa presenta importantes interrogantes en cuanto a la recopilación de datos, los parámetros de entrenamiento y las leyes de escalabilidad. A pesar de que se han hecho públicos los pesos del modelo, los conjuntos de datos y el código empleado en su formación permanecen en reserva.

Ante esta situación, ha surgido el proyecto Open-R1, cuyo objetivo es reconstruir de forma sistemática el pipeline de datos y entrenamiento utilizado en DeepSeek-R1, validar sus afirmaciones y abrir nuevas posibilidades en el ámbito de los modelos de razonamiento. Entre los pasos a seguir, se destacan:

- Replicar los modelos R1-Distill: Se pretende destilar un conjunto de datos de razonamiento de alta calidad a partir de DeepSeek-R1.

- Recrear el pipeline de RL puro: Esto implicará la curación de nuevos conjuntos de datos a gran escala enfocados en matemáticas, razonamiento y programación.

- Demostrar la viabilidad del proceso multi-etapa: Se buscará evidenciar que es posible partir de un modelo base, pasar por un ajuste fino supervisado (SFT) y culminar con el aprendizaje por refuerzo (RL).

La iniciativa no se limitará exclusivamente a los conjuntos de datos matemáticos, sino que también se explorarán otros campos de gran potencial, como la programación y áreas científicas, entre ellas la medicina, donde los modelos de razonamiento pueden tener un impacto significativo.

Una invitación a la colaboración

El proyecto Open-R1 aspira a ir más allá de la simple replicación de resultados. Su objetivo es compartir conocimientos, documentar tanto los éxitos como los desafíos encontrados en el proceso, y evitar que otros investigadores desperdicien recursos en caminos infructuosos. De esta forma, se invita a la comunidad global a contribuir—ya sea mediante código, participando en debates en plataformas como Hugging Face o colaborando en el desarrollo de nuevas metodologías.

En definitiva, Open-R1 se presenta como un esfuerzo colaborativo que promete abrir las puertas a futuros modelos de razonamiento de código abierto, permitiendo que tanto investigadores como desarrolladores se beneficien de técnicas de vanguardia y de una transparencia sin precedentes en el entrenamiento de sistemas de inteligencia artificial.

vía: Hugging face