En el dinámico ámbito de la inteligencia artificial, las organizaciones están adoptando cada vez más un enfoque versátil utilizando múltiples modelos de lenguaje grandes (LLM, por sus siglas en inglés) para desarrollar aplicaciones más robustas y eficientes. Esta estrategia responde a la creciente necesidad de abordar una amplia variedad de casos de uso, optimizando aspectos como costo, latencia y calidad. Aunque un solo modelo puede ser eficiente, rara vez es capaz de manejar todas las necesidades específicas de rendimiento y aplicación.

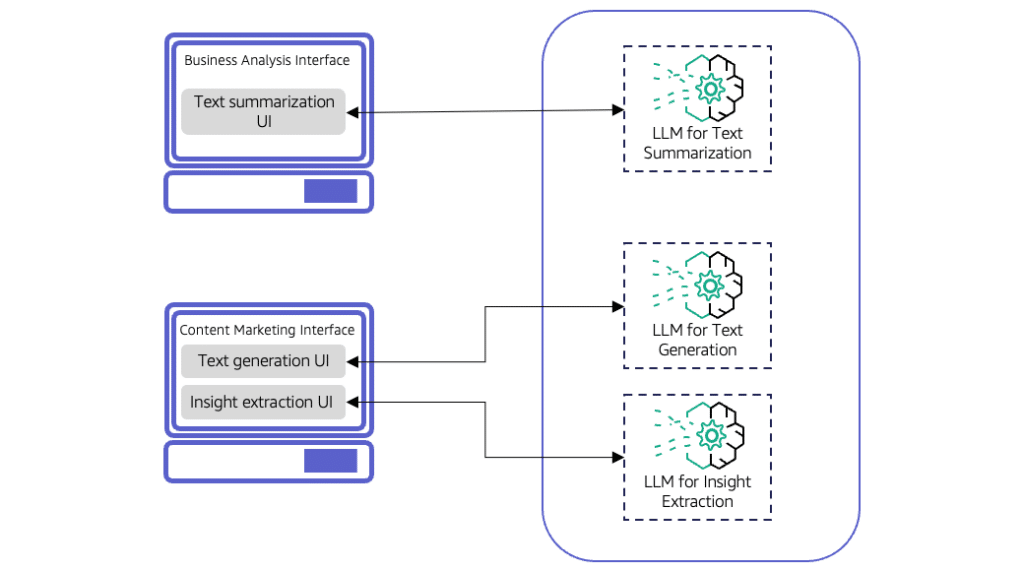

El uso de múltiples LLM permite a las empresas asignar el modelo adecuado para cada tarea específica, adaptándose a distintos dominios y ofreciendo aplicaciones más versátiles que se ajustan a las demandas cambiantes de los usuarios y los objetivos de negocio. Sin embargo, este enfoque presenta un desafío significativo: la correcta dirección de cada solicitud del usuario al modelo apropiado. La implementación de una lógica de enrutamiento precisa es crucial para interpretar correctamente los mensajes y asignarlos al LLM adecuado según la tarea necesaria.

Aplicaciones como la creación de contenido de marketing se beneficiarían considerablemente de este enfoque, ya que requieren capacidades de generación de texto, resumen, análisis de sentimientos y extracción de información. A medida que estas aplicaciones se hacen más complejas en sus interacciones, es esencial que manejen con eficacia los distintos niveles de complejidad de las tareas, ajustándose al nivel del usuario y al tipo de documento procesado.

Existen principalmente dos enfoques para el enrutamiento de solicitudes a diferentes LLM: el estático y el dinámico. El enrutamiento estático facilita un diseño modular y flexible mediante la implementación de componentes de interfaz de usuario específicos para cada tarea. Sin embargo, al agregar nuevas funciones, se requiere el desarrollo de componentes adicionales. Por su parte, el enrutamiento dinámico, frecuentemente utilizado en asistentes virtuales y chatbots, canaliza las solicitudes a través de un componente de UI único, dirigiéndolas dinámicamente al LLM que mejor se adapta a cada tarea.

Entre las técnicas de enrutamiento dinámico destaca el enrutamiento asistido por LLM, que emplea un modelo clasificador para decisiones de enrutamiento más precisas, aunque a mayor costo. Además, el enrutamiento semántico, que representa mensajes de entrada mediante vectores numéricos, permite una eficaz adaptación a nuevas categorías de tareas, gracias a su capacidad para identificar similitudes con categorías predefinidas.

Un enfoque híbrido, que combina las técnicas de enrutamiento estático y dinámico, puede ofrecer un sistema de enrutamiento robusto y adaptativo a las diversas necesidades de los usuarios. No obstante, la adopción de estos sistemas requiere un análisis minucioso de los costos, la latencia y la complejidad del mantenimiento, junto con una evaluación constante del rendimiento de los modelos empleados.

En respuesta a esta tendencia creciente, plataformas como Amazon Bedrock están ganando protagonismo al ofrecer servicios gestionados de LLM que facilitan el enrutamiento inteligente de solicitudes. Estas plataformas permiten a los desarrolladores centrarse en la creación de aplicaciones innovadoras, mientras optimizan los costos y mantienen la calidad de las respuestas, reduciendo los costes operativos hasta en un 30%.

En definitiva, el uso estratégico de múltiples LLM en aplicaciones de inteligencia artificial generativa amplía las capacidades organizacionales y enriquece la experiencia del usuario. El éxito de su implementación radica en una cuidadosa consideración de las diversas dinámicas y necesidades internas de cada organización.