La inteligencia artificial generativa da un nuevo salto técnico con la llegada de FramePack, una arquitectura innovadora que permite la creación de vídeos mediante difusión (diffusion models) directamente desde una GPU de consumo con tan solo 6 GB de memoria de vídeo. Este avance, liderado por Lvmin Zhang en colaboración con Maneesh Agrawala de la Universidad de Stanford, promete democratizar el acceso a la creación de contenido audiovisual generado por IA, hasta ahora reservado a quienes disponían de costosos recursos computacionales.

¿Qué es FramePack?

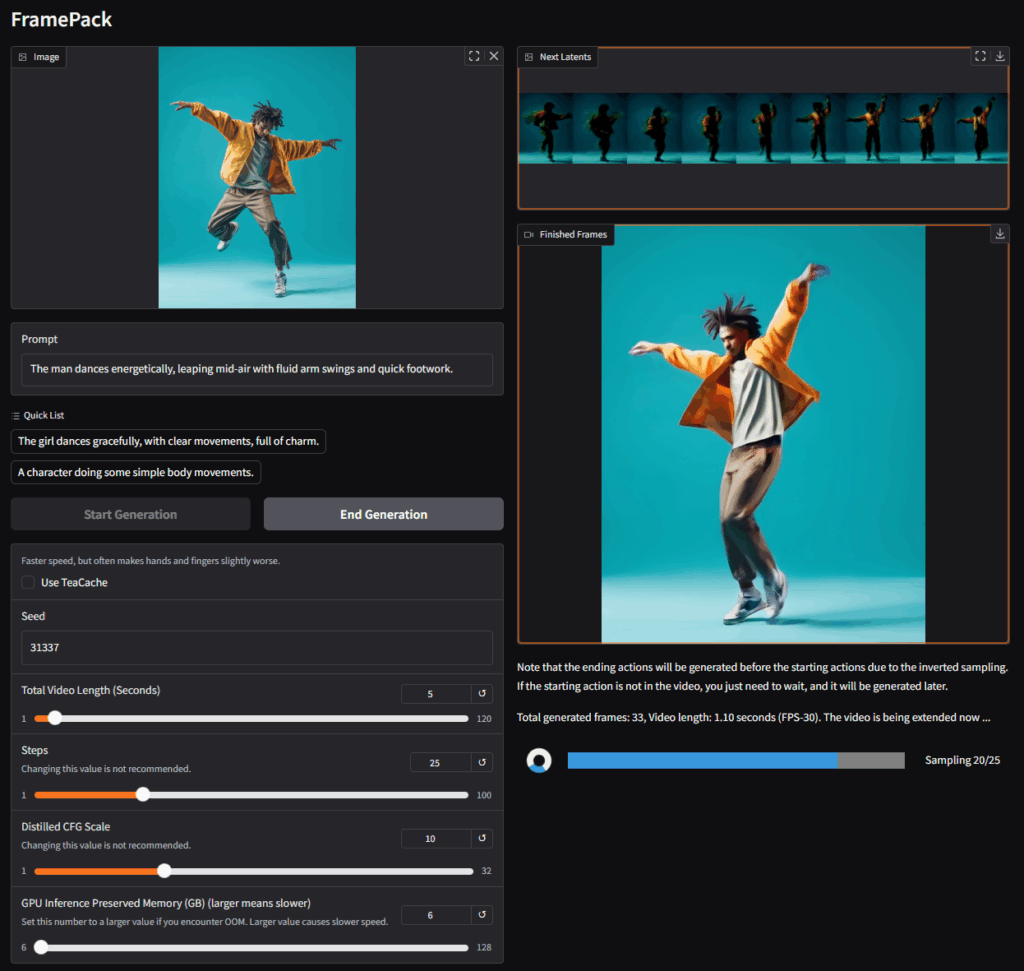

FramePack es un nuevo sistema de predicción cuadro a cuadro que comprime el contexto temporal de entrada —es decir, la cantidad de cuadros anteriores usados para generar el siguiente— a un tamaño fijo. Este enfoque reduce significativamente la carga de memoria sobre la GPU, permitiendo mantener una calidad y duración superiores incluso en ordenadores portátiles.

Gracias a esta compresión inteligente, el sistema evita uno de los principales cuellos de botella en los modelos tradicionales de difusión de vídeo: el aumento exponencial del contexto conforme crece la duración del vídeo. Con FramePack, un modelo de 13.000 millones de parámetros puede generar vídeos de hasta 60 segundos (1.800 cuadros a 30 fps) usando solamente 6 GB de VRAM.

Adiós a las limitaciones de hardware

Hasta ahora, las herramientas de generación de vídeo basadas en difusión exigían entre 12 GB o más de VRAM, lo que excluía a usuarios con tarjetas gráficas modestas. FramePack es compatible con tarjetas NVIDIA RTX 30, 40 y 50, y soporta los formatos FP16 y BF16. No se ha verificado compatibilidad con arquitecturas más antiguas ni con tarjetas gráficas de AMD o Intel.

Esto implica que una gran parte de los equipos gaming actuales —e incluso portátiles potentes— ya cumplen los requisitos mínimos para experimentar con la generación de vídeo por IA, tanto en Linux como en Windows.

Rendimiento sorprendente y visualización inmediata

El modelo de ejemplo ofrecido por los desarrolladores permite visualizar el vídeo mientras se genera cuadro a cuadro. Por ejemplo, con una RTX 4090, la velocidad de generación alcanza los 0,6 cuadros por segundo con optimización (teacache), o unos 2,5 s/cuadro en modo estándar. En portátiles con GPU RTX 3060 o 3070, el rendimiento se reduce, pero sigue siendo funcional.

Este enfoque “next-frame-section prediction” permite tener una retroalimentación visual inmediata, útil tanto para artistas digitales como para entornos de prototipado rápido.

Instalación sencilla y software disponible en GitHub

FramePack se puede descargar directamente desde su repositorio oficial en GitHub (lllyasviel/FramePack) y cuenta con un paquete instalador de un solo clic para Windows (basado en CUDA 12.6 y PyTorch 2.6). En Linux, basta con instalar los requisitos mediante pip y ejecutar la interfaz gráfica desde consola.

El sistema descarga automáticamente los modelos desde HuggingFace (más de 30 GB de datos) e incluye una GUI intuitiva para generar vídeo a partir de imágenes y prompts escritos. También permite activar o desactivar optimizaciones como teacache, aunque esta puede afectar levemente la calidad final del vídeo.

Aplicaciones prácticas y creativas

FramePack puede utilizarse para crear:

- Clips animados a partir de imágenes estáticas

- GIFs, memes y vídeos de corta duración

- Secuencias para proyectos de arte, juegos o interfaces

- Experimentos en educación y entrenamiento de modelos

- Contenido para redes sociales o música

Con una comunidad en crecimiento y un enfoque open-source, FramePack abre las puertas a una nueva generación de herramientas de vídeo IA accesibles desde equipos personales.

Precaución: versiones falsas

Los autores del proyecto advierten que únicamente el repositorio de GitHub es oficial. Existen múltiples webs falsas como framepack.co, framepack.ai, etc., que no están asociadas con el proyecto. No deben descargarse archivos ni realizar pagos a través de esos sitios.

Un nuevo horizonte para la IA generativa de vídeo

FramePack es un ejemplo tangible del avance de la IA generativa más allá del texto e imagen estática. Al permitir generar vídeos largos con recursos modestos, supone un cambio radical en quién puede crear, experimentar y explorar las posibilidades del vídeo sintético.

Aunque los resultados varían según el hardware y la configuración, la posibilidad de crear vídeos fluidos y personalizados desde una imagen con una RTX 3060 o 3070 es ya una realidad. Un paso más hacia la democratización de la inteligencia artificial creativa.