Google ha ampliado su familia Gemini 3 con el lanzamiento de Gemini 3 Flash, un modelo diseñado para resolver una tensión que se ha vuelto central en la carrera de la Inteligencia Artificial: cómo ofrecer razonamiento avanzado sin disparar latencia y costes. La compañía lo presenta como una pieza “de escala” —menos enfocada en deslumbrar en demos largas y más en sostener uso masivo—, y por eso lo está desplegando como modelo por defecto tanto en la app de Gemini como en AI Mode en Search, además de abrirlo a desarrolladores a través de su ecosistema de APIs y herramientas.

La tesis de Google es clara: Flash no es un “Gemini recortado”, sino una variante optimizada para iteración rápida, apps interactivas, flujos agentic y, sobre todo, para convertirse en el modelo que más gente use sin darse cuenta. En otras palabras, no compite solo por potencia bruta, sino por ser el modelo que siempre está ahí cuando alguien pregunta, programa, analiza un documento o monta un prototipo.

Un modelo pensado para velocidad… sin renunciar al músculo

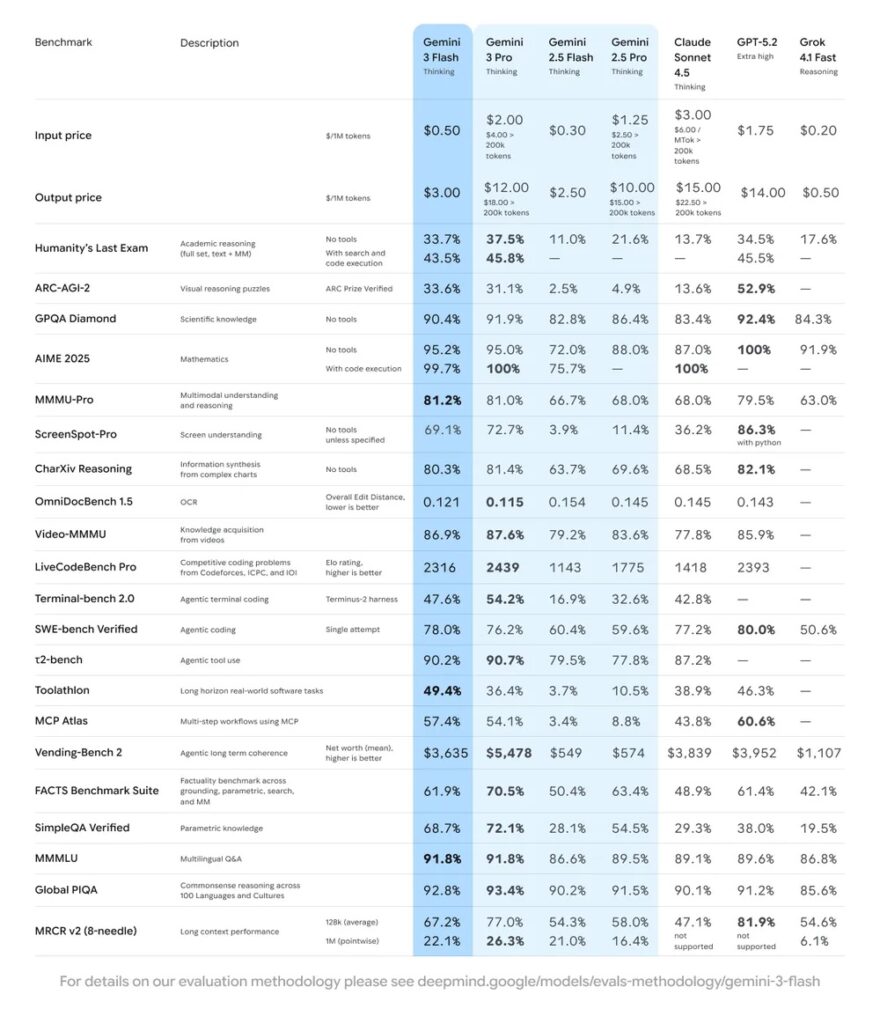

Según la propia Google, Gemini 3 Flash combina “razonamiento de nivel Pro” con “latencia Flash”, y lo enmarca como un avance en eficiencia: el modelo puede modular cuánto “piensa” en función de la complejidad del encargo, algo relevante en productos donde cada milisegundo y cada token cuentan. En su comunicación pública, Google destaca que, en uso típico, Flash utiliza un 30% menos de tokens de media frente a Gemini 2.5 Pro para completar tareas cotidianas con alta precisión, y que además es hasta 3× más rápido en comparativas que atribuye a benchmarking externo. También lo sitúa en una posición competitiva en pruebas exigentes: menciona GPQA Diamond (90,4%), Humanity’s Last Exam (33,7% sin herramientas) y MMMU Pro (81,2%), además de un 78% en SWE-bench Verified orientado a capacidades de agentes de programación.

Este paquete de cifras importa por dos motivos. Primero, porque sugiere que Google quiere reivindicar rendimiento “de frontera” en formato utilizable, no solo en laboratorio. Y segundo, porque en 2025 la batalla no se decide únicamente en quién gana un benchmark, sino en quién logra que su modelo sea el más rentable de desplegar cuando se escala a millones de usuarios y a miles de integraciones empresariales.

Dónde se puede usar y por qué esa distribución es parte del mensaje

La jugada de Google es, ante todo, de distribución. Gemini 3 Flash:

- Pasa a ser el modelo por defecto en la app de Gemini, sustituyendo a la generación anterior “Flash”.

- Llega a AI Mode en Search como parte del empuje de Google por convertir la búsqueda en una interfaz de investigación y acción, no solo de enlaces.

- Se ofrece a desarrolladores en el Gemini API y se integra en el stack de producto para creación: Google AI Studio, Gemini CLI, Android Studio, Vertex AI y Gemini Enterprise, entre otros canales.

Esto cambia el contexto: Flash no pretende ser el modelo “para ocasiones especiales”, sino el que alimenta el volumen. Y si el volumen se lo lleva el modelo rápido, la percepción de calidad —para la mayoría de usuarios— acaba asociándose a quien responde antes y bien “casi siempre”.

Precio por token: el detalle que delata la estrategia

Google también ha puesto el foco en el coste. En su anuncio, fija el precio de Gemini 3 Flash en $0,50 por 1.000.000 de tokens de entrada y $3,00 por 1.000.000 de tokens de salida (con audio de entrada a $1,00 por 1.000.000). En un mercado donde cada producto compite por integrar IA sin reventar márgenes, esta cifra funciona como señal: Flash quiere ser el modelo que puedas permitirte usar “en todas partes”.

Y aquí entra un factor menos visible: Google afirma estar procesando más de 1 billón (1T) de tokens al día en su API desde el arranque de Gemini 3. Ese tipo de escala hace que optimizar eficiencia no sea un “nice to have”, sino una condición para que el negocio sea sostenible cuando el uso se multiplica.

Qué significa para el mercado: menos “chatbot”, más motor industrial

Gemini 3 Flash encaja con una transición que ya se venía viendo: pasar de asistentes conversacionales a IA como motor operativo. Un modelo rápido, con buen razonamiento y fuerte rendimiento en código, favorece:

- Apps con bucles de iteración (probar, corregir, volver a probar).

- Agentes que hacen llamadas frecuentes a herramientas.

- Experiencias multimodales donde el usuario espera respuesta inmediata (texto, imagen, vídeo).

- Trabajo empresarial que exige rendimiento constante, no solo picos de genialidad.

Dicho de forma simple: si Gemini 3 Pro es el escaparate, Gemini 3 Flash es el “diésel” que Google quiere meter en su flota.

Preguntas frecuentes

¿Gemini 3 Flash sustituye a Gemini 3 Pro o son modelos distintos?

Son modelos distintos dentro de la familia Gemini 3: Flash prioriza velocidad y coste, mientras Pro apunta a rendimiento alto de forma más general.

¿Gemini 3 Flash ya está disponible en España y en castellano?

Google indica que el despliegue es global y que Flash pasa a ser el modelo por defecto en la app de Gemini y en AI Mode en Search, con disponibilidad progresiva por usuarios.

¿Qué usos técnicos encajan mejor con Gemini 3 Flash?

Especialmente bien: desarrollo de software con iteración rápida, apps interactivas, análisis con baja latencia y flujos agentic donde el coste por token se vuelve crítico.

¿Cuánto cuesta usar Gemini 3 Flash vía API?

Google comunica $0,50/1.000.000 tokens de entrada y $3,00/1.000.000 tokens de salida (audio de entrada: $1,00/1.000.000).

vía: blog.google