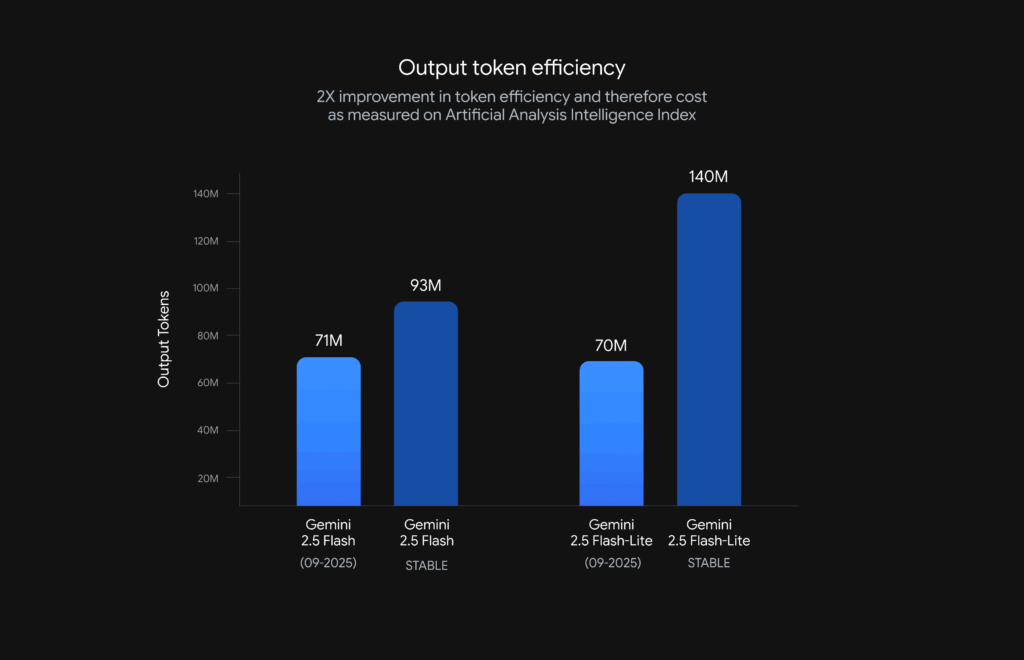

Google ha publicado nuevas versiones preliminares de sus modelos de respuesta rápida Gemini 2.5 Flash y Gemini 2.5 Flash-Lite. Los dos “previews” ya están disponibles en Google AI Studio y Vertex AI y, según la compañía, no pretenden sustituir todavía a las versiones estables, sino acercar a los desarrolladores las mejoras de calidad y eficiencia que irán conformando las próximas graduaciones. La noticia llega con cifras concretas: reducción del 50 % en tokens de salida para Flash-Lite y del 24 % para Flash, además de mejoras en el seguimiento de instrucciones, multimodalidad y —en el caso de Flash— un salto en uso de herramientas y tareas agénticas que Google resume con una ganancia del 5 % en SWE-Bench Verified (del 48,9 % al 54 %) frente a su lanzamiento anterior.

La compañía acompaña el anuncio con una novedad operativa que agradecerá cualquiera que mantenga aplicaciones en producción: aliases “-latest” por familia —gemini-flash-latest y gemini-flash-lite-latest— para probar sin tocar código cada vez que aparece un “preview”, con el compromiso de un aviso de 2 semanas antes de actualizar o retirar una versión concreta que quede detrás del alias.

A efectos prácticos, los nuevos identificadores a usar para probar desde hoy son:

- gemini-2.5-flash-lite-preview-09-2025

- gemini-2.5-flash-preview-09-2025

Y para quien prefiera estabilidad por encima de novedad, Google reafirma que los modelos recomendados para producción siguen siendo:

- gemini-2.5-flash

- gemini-2.5-flash-lite

A continuación, el detalle de lo que cambia, por qué importa y qué camino tienen delante quienes ya operan con la familia Flash.

Qué aporta el nuevo 2.5 Flash-Lite “preview”: disciplina, concisión y multimodalidad que ahorra euros

Flash-Lite es el modelo ligero de la familia, diseñado para alto rendimiento (peticiones por segundo) y costes bajos. En esta iteración, Google resume la apuesta en tres ejes:

- Mejor seguimiento de instrucciones

El nuevo “preview” entiende mejor los prompts complejos y los system prompts. En estrecha relación con la curva de adopción empresarial, esta mejora apunta a reducir desvíos y hallucinations en peticiones donde se exige estilo, formato o pasos muy concretos (por ejemplo, “lista numerada con fuentes al final”, “tabla con 5 columnas exactas”, “resumen en 120 palabras”). - Menos verborrea

Un clásico en modelos rápidos es que “hablan de más”. Aquí Google dice haber recortado la verbosidad para producir respuestas más concisas, clave para bajar latencia y, sobre todo, reducir tokens de salida. La cifra que acompaña al anuncio es potente: -50 % de output tokens de media, lo que se traduce directamente en ahorro de costes para aplicaciones con gran volumen. - Multimodal y traducción más finas

Flash-Lite “preview” viene con transcripción de audio más precisa, mejor comprensión de imagen (identificación y descripción) y mayor calidad de traducción. Este frente importa en todos los casos de uso de asistencia visual (OCR ligero, interpretación de capturas o facturas, validación de campos) y en experiencias multilingües donde un modelo ligero debe entender y responder con menos margen de error.

Con todo, el mensaje de Google es prudente: es un “preview”, no una versión estable. La cadena de coste/latencia mejora ya, la calidad también, pero la recomendación sigue siendo testear contra el caso de uso específico antes de promover a producción.

Qué cambia en 2.5 Flash “preview”: agentes más listos y menor coste con “thinking on”

El “hermano mayor” de la línea, Gemini 2.5 Flash, está orientado a respuestas más ricas que Lite, manteniendo velocidad y precio contenidos frente a modelos tope de gama. Las dos mejoras que Google subraya son:

- Uso de herramientas más inteligente (agentic)

El nuevo “preview” mejora cómo decide y cuándo invoca herramientas externas: APIs, funciones, retrieval, acciones encadenadas. La compañía lo respalda con un dato de referencia: +5 % de SWE-Bench Verified (del 48,9 % al 54 %) respecto al lanzamiento anterior. En términos prácticos, esto se traduce en menos intentos fallidos, mejor orquestación en tareas de varios pasos y más éxito allí donde el modelo debe planear y ejecutar (consultar un API, resumir el resultado, decidir un siguiente paso). - Más eficiencia con “thinking on”

Flash “preview” es ahora más eficiente cuando se activa el modo razonamiento: produce salidas de mayor calidad con menos tokens, lo que acorta latencia y reduce coste. Junto al recorte de output tokens destacado en los gráficos del anuncio, es un guiño claro a quienes escalan agentes y flujos complejos: más casos cubiertos por sesión con igual o menor presupuesto.

La validación de terceros suele llegar con cuentagotas en lanzamientos así, pero Google aportó una declaración de Manus —una empresa de agentes autónomos— donde su cofundador y Chief Scientist Yichao “Peak” Ji habla de un “15 %” de mejora en tareas agénticas de horizonte largo en sus pruebas internas, con una eficiencia de costes que les permite escalar.

“-latest”: un alias para vivir al día sin tocar código… con letras pequeñas

La segunda mitad del anuncio es operacional y, para muchos equipos, casi tan importante como la calidad del modelo: llegan los aliases “-latest”. En vez de recordar cadenas largas de versión, se puede apuntar a:

- gemini-flash-latest

- gemini-flash-lite-latest

Estos nombres siempre referirán a la versión más reciente de su familia, incluidos “previews”. Google promete aviso con 2 semanas de antelación (por correo) antes de actualizar o retirar la versión que queda detrás del alias. Es un atajo para experimentar con novedades sin tocar el código que integra el modelo.

Dos matices importantes:

- Son aliases de modelo, de modo que coste, límites y características pueden cambiar entre lanzamientos. Si la aplicación no tolera esa variabilidad, hay que quedarse en los identificadores estables (gemini-2.5-flash y gemini-2.5-flash-lite).

- Usar “-latest” no congela el comportamiento del modelo: es para pruebas, feature flags y entornos no críticos o bien robustos a cambios.

Qué significa esto para quien ya usa Flash/Flash-Lite

1) Coste y rendimiento

Si el precio por interacción pesa en tu P&L, el -50 % de tokens de salida en Flash-Lite y el -24 % en Flash son el titular. Con una misma longitud de respuesta, los costes bajan; con una respuesta más concisa y útil, bajan todavía más. La reducción también acorta latencia, “aceite” para interfaces concurrentes (asistentes de soporte, chat embebido, RAG con alto QPS).

2) Agentes y orquestación

El +5 % en SWE-Bench Verified no convierte al modelo en un autónomo perfecto, pero sube el listón para agentes multi-step que dependen de tool use fiable. Si tus flujos encadenan retrieval, llamadas a APIs, validaciones y resúmenes, merece la pena A/B testear el “preview”.

3) Multimodalidad

En Flash-Lite hay mejoras de audio, imagen y traducción. Para integraciones de voice-to-text (actas, notas) y visión (capturas, tickets, documento + campos), compensa re-evaluar calidad. Si tu producto depende de comprensión visual, anota la novedad aunque no sea el foco del modelo.

4) Flujo de adopción

Si trabajas con entornos duales (preproducción y producción):

- Cambia a gemini-flash-latest/gemini-flash-lite-latest en staging, sin tocar más.

- Corre pruebas de regresión (precisión, latencia, coste).

- Si todo cuadra, promueve en producción a los “preview” con identificadores largos (para no depender del alias) o espera a la graduación a estable.

Cómo impacta en productos reales (escenarios típicos)

- Atención al cliente. Los resúmenes más concisos y el mejor seguimiento de instrucciones ayudan a reducir tokens, latencia y errores de tono. Con Flash-Lite, bots de primer nivel escala mejor.

- RAG empresarial. El uso de herramientas más fino en Flash y el ahorro de tokens permiten más grounding por sesión y respuestas más ajustadas con menor costo.

- Automatización y agentes. Con +5 % de SWE-Bench Verified y el testimonio de Manus (+15 % en tareas agénticas internas), los flujos de varios pasos (consultar-validar-actuar) tienen más éxito y menos reintentos.

- Traducción y voz. La mejora en traducción y transcripción en Lite favorece experiencias multilingües y voice-first de alto volumen.

Lo que no cambia (y conviene recordar)

- Son “previews”: Google quiere feedback y no promete graduación inmediata.

- El alias “-latest” es un comodín para explorar; producción crítica, mejor estable.

- El ahorro de tokens no sustituye el buen prompting: promts claros, instrucciones compactas, formatos definidos y controles (por ejemplo, máximos de tokens) siguen marcando la diferencia.

- La observabilidad es imprescindible: latencia, ratio de tool calls, tokens y calidad (human evals) deberían medirse en cada despliegue.

Qué viene ahora

Google insiste en que publicar previews de forma continua le acerca feedback y permite a los equipos montar experiencias productivas sobre las mejores iteraciones de Gemini sin esperar a una gran “versión” anual. Si el patrón de este año se mantiene, habrá más pasos —afinados de calidad, tool use, multimodal y coste— antes de la graduación a la siguiente línea estable.

Mientras tanto, el mensaje práctico es claro: probar ya —sin tocar código si se usan los aliases “-latest”— y medir si las promesas de calidad+eficiencia se sostienen en tu caso de uso.

Preguntas frecuentes

¿Qué diferencia práctica hay entre gemini-2.5-flash y gemini-2.5-flash-lite?

Flash está pensado para respuestas más ricas y mejor uso de herramientas en tareas de varios pasos, con un trade-off de coste/latencia superior a Lite. Flash-Lite prioriza alto rendimiento y ahorro, ideal para altas concurrencias y respuestas concisas. En los nuevos “previews”, Lite recorta -50 % de tokens de salida y Flash -24 %, además de los avances de tool use (+5 % SWE-Bench Verified) y eficiencia con “thinking on”.

¿Cómo activo las versiones preliminares en Google AI Studio o Vertex AI?

Usa los identificadores: gemini-2.5-flash-lite-preview-09-2025 y gemini-2.5-flash-preview-09-2025. Si deseas probar sin cambiar código en cada update, apunta a los aliases gemini-flash-latest y gemini-flash-lite-latest (Google promete aviso de 2 semanas antes de modificar lo que hay detrás del alias).

¿Cuándo debo evitar “-latest” y quedarme en la versión estable?

Si tu aplicación no tolera fluctuaciones de coste, latencia o comportamiento, usa los modelos estables (gemini-2.5-flash y gemini-2.5-flash-lite). El alias “-latest” sirve para experimentar y pre-validar mejoras antes de promoverlas a producción.

¿De verdad voy a ahorrar la mitad del coste en Flash-Lite?

Google reporta -50 % de tokens de salida en Flash-Lite “preview” (y -24 % en Flash). El ahorro real depende de tus prompts y del formato de respuesta. Para maximizarlo: instrucciones concisas, límites de tokens, evitar redundancias y revisar verbosidad en plantillas.

Modelos “preview” citados: gemini-2.5-flash-lite-preview-09-2025, gemini-2.5-flash-preview-09-2025.

Aliases: gemini-flash-latest, gemini-flash-lite-latest.

Modelos estables actuales: gemini-2.5-flash, gemini-2.5-flash-lite.