La nueva generación de chips de Google para inteligencia artificial, Ironwood, marca un salto de potencia y eficiencia diseñado para afrontar los retos de los modelos de lenguaje y razonamiento más avanzados.

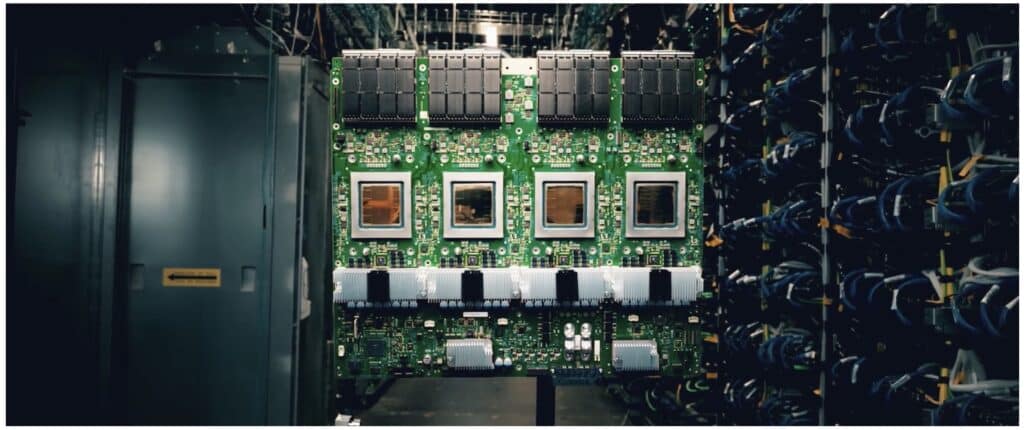

Google ha presentado oficialmente Ironwood, su séptima generación de unidades de procesamiento Tensor (TPU), en el evento Cloud Next 2025. Este nuevo chip representa el futuro de la computación de inteligencia artificial, en un momento en el que el foco de la innovación se traslada del entrenamiento de modelos hacia su despliegue y uso en tiempo real, en lo que la compañía denomina “la era de la inferencia”.

¿Qué es Ironwood y por qué es relevante?

Ironwood es la primera TPU diseñada específicamente para ejecutar modelos de IA inferencial, como los grandes modelos de lenguaje (LLM), los modelos con mezcla de expertos (MoE) y otros sistemas que razonan o generan contenido en tiempo real. La clave está en su potencia, escalabilidad y eficiencia energética, lo que la convierte en la solución más ambiciosa de Google hasta la fecha.

Cada chip Ironwood alcanza los 4.614 teraflops (TFLOPS) de rendimiento pico, más de 16 veces superior al de la TPU v4 lanzada en 2022. Además, permite agrupar hasta 9.216 chips en un solo pod, ofreciendo un total de 42,5 exaflops, superando con creces la capacidad de los superordenadores más potentes del mundo.

Tecnología de vanguardia al servicio de la IA

Ironwood no solo aporta fuerza bruta. También incorpora una arquitectura renovada para:

- Reducir la latencia mediante redes de interconexión ultra rápidas (ICI) de 1,2 Tbps.

- Multiplicar la memoria de alto rendimiento (HBM), alcanzando los 192 GB por chip y un ancho de banda de 7,4 TB/s, ideal para modelos con millones de parámetros.

- Mejorar la eficiencia energética, duplicando el rendimiento por vatio respecto a su predecesora, Trillium.

Google Cloud como plataforma AI-as-a-Service

Ironwood estará disponible a través de Google Cloud en diferentes configuraciones, desde 256 chips hasta pods completos con miles de unidades. Los desarrolladores podrán escalar fácilmente mediante el entorno Pathways, el runtime de Google DeepMind para distribuir modelos entre miles de chips de forma eficiente.

Google consolida así su visión de IA como infraestructura y servicio (AI-as-a-Service), ofreciendo a empresas, investigadores y startups acceso a la misma tecnología que impulsa servicios como Gmail, YouTube o Google Search.

📊 Comparativa de TPUs de Google (2022–2025)

| Característica | TPU v4 (2022) | TPU v5p (2023) | Ironwood (2025) |

|---|---|---|---|

| Tamaño del pod (chips) | 4.896 | 8.960 | 9.216 |

| Memoria HBM por chip | 32 GB | 95 GB | 192 GB |

| Ancho de banda HBM | 1,2 TB/s | 2,8 TB/s | 7,4 TB/s |

| Flops pico por chip | 275 TFLOPS | 459 TFLOPS | 4.614 TFLOPS |

Una apuesta clara por el futuro de la IA

Ironwood no es solo un procesador más rápido. Representa un cambio de enfoque. De entrenar modelos en segundo plano a desplegarlos en tiempo real para resolver problemas complejos, desde asistentes conversacionales avanzados hasta simulaciones científicas o recomendadores financieros.

Google no solo quiere liderar el desarrollo de modelos. Con Ironwood, quiere liderar la infraestructura sobre la que estos modelos se ejecutan, construyendo la próxima generación de centros de datos especializados en IA. Y todo apunta a que lo está logrando.

Fuente: Google blog y Revista Cloud