La gestión de modelos de lenguaje a gran escala, conocida comúnmente como LLMOps, se ha afirmado como un pilar esencial para las empresas y sectores tecnológicos que buscan optimizar el uso de herramientas avanzadas de inteligencia artificial. Este campo, altamente técnico, tiene una influencia significativa en todos los aspectos de los marcos modernos de IA, desde el diseño de modelos hasta su implementación.

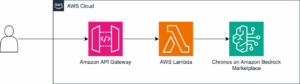

LLMOps incluye un amplio conjunto de técnicas, prácticas y herramientas que son necesarias para operar y manejar grandes modelos de lenguaje durante todo su ciclo de vida. Entre las etapas críticas de este proceso se encuentran el entrenamiento de los modelos, su ajuste fino, monitoreo, implementación y la preparación de datos. A medida que el ámbito de LLMOps continúa expandiéndose, se detecta una diversidad creciente de herramientas que permiten ajustar soluciones tanto propietarias como de código abierto. Un ejemplo de esto es la provisión de modelos de lenguaje como una API, un método que ha ganado popularidad por ofrecer estos modelos de forma cerrada utilizando la infraestructura disponible.

Uno de los factores críticos en LLMOps es la selección del diseño arquitectónico adecuado y la personalización de modelos pre-entrenados, lo cual es esencial no solo para la eficiencia de costos, sino también de tiempo. Además, las prácticas de optimización de hiperparámetros juegan un papel crucial, pues buscan mejorar el rendimiento de los modelos mediante la combinación óptima de parámetros, aplicando técnicas como la búsqueda aleatoria o la optimización bayesiana.

La gestión de datos en el contexto de LLMOps implica una organización meticulosa, almacenamiento seguro y control de versiones que garantizan un flujo de datos fluido a lo largo del ciclo de vida del modelo. La recopilación, limpieza y etiquetado de datos son actividades fundamentales en este proceso, al igual que la protección de la privacidad de los datos mediante la seudonimización y el cumplimiento de regulaciones como GDPR y CCPA.

Las empresas que implementan LLMOps pueden beneficiarse de una mejor escalabilidad y eficiencia al gestionar grandes volúmenes de solicitudes de manera simultánea, lo que resulta crítico para aplicaciones empresariales. La eficiencia lograda se traduce en una colaboración más ágil entre ingenieros de aprendizaje automático, científicos de datos y otros profesionales involucrados, así como en una optimización de recursos que contribuye a la reducción de costos computacionales.

Por otro lado, LLMOps promueve la reducción de riesgos al otorgar prioridad a la privacidad y seguridad de los datos, proporcionando transparencia y asegurando un rápido cumplimiento de las regulaciones vigentes. Las prácticas recomendadas en LLMOps abordan desde el análisis exploratorio de datos hasta el diseño ético de modelos, asegurando así un manejo eficaz y seguro de la información.

Con un entendimiento sólido de lo que implica LLMOps, las organizaciones tienen la capacidad de tomar la delantera en el contexto tecnológico actual, pavimentando el camino hacia futuros desarrollos en inteligencia artificial en una era marcada por intensos debates sobre la ética de la inteligencia general artificial.