En un entorno donde la inteligencia artificial generativa está experimentando un crecimiento sin precedentes, las empresas buscan cada vez más adaptar modelos fundacionales a sus dominios específicos. Este enfoque está diseñado para satisfacer necesidades concretas en campos como la resumición de documentos, la personalización de servicios industriales y la asesoría técnica en la generación de códigos. Estas innovaciones han permitido a las organizaciones ofrecer experiencias personalizadas y mejorar sus servicios en sectores que van desde el procesamiento del lenguaje natural hasta la generación de contenidos, todo ello sin requerir un alto nivel de conocimientos técnicos.

Sin embargo, implementar estos modelos de inteligencia artificial en el ámbito empresarial no está exento de desafíos. Los modelos genéricos a menudo no poseen el conocimiento suficiente para ciertas terminologías o dominios específicos de las organizaciones. Para solucionar esta limitación, las empresas están recurriendo a modelos de lenguaje grande (LLMs) específicos de dominio, diseñados para realizar tareas especializadas dentro de contextos particulares. Así, se están afinando modelos de inteligencia artificial generativa en industrias como finanzas, ventas, marketing, tecnología de la información, recursos humanos, salud y atención al cliente.

A medida que aumenta el interés por soluciones de inteligencia artificial personalizadas, las empresas se encuentran con el reto de manejar eficientemente múltiples modelos ajustados según diferentes casos de uso y segmentos de clientes. Desde el análisis de currículos hasta la generación de correos electrónicos especializados, las compañías gestionan cientos de modelos refinados, lo cual puede resultar en un proceso costoso y complejo. Las soluciones tradicionales para el alojamiento de modelos pueden volverse difíciles de gestionar, consumir muchos recursos y dar lugar a un aumento de los costos de infraestructura y a posibles cuellos de botella en el rendimiento.

Una solución prometedora para estos desafíos es la utilización de una técnica llamada Low-Rank Adaptation (LoRA), que adapta modelos de lenguaje preentrenados a nuevas tareas o dominios mediante la adición de matrices de pesos entrenables de pequeño tamaño. No obstante, el método tradicional de hosting, que fusiona las capas afinadas con los pesos del modelo base, es ineficiente tanto en recursos como en costos.

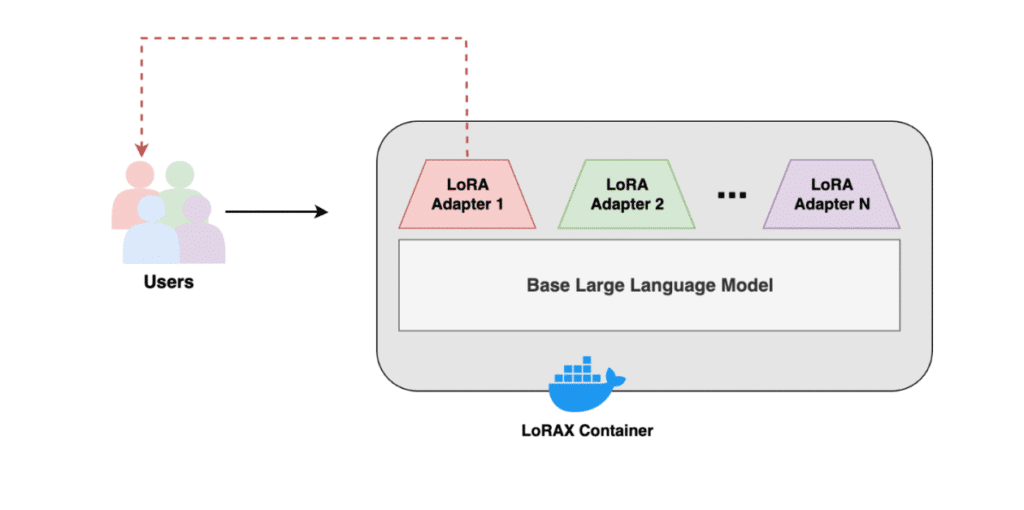

El software de código abierto LoRAX facilita la gestión y el despliegue de una cartera creciente de modelos afinados de manera significativamente más eficiente y rentable. Gracias a LoRAX, las empresas pueden ajustar un modelo base para diversas tareas y hospedar distintas variantes en una sola instancia de EC2 de Amazon, lo que representa un ahorro considerable sin comprometer el rendimiento.

Este impulso hacia la eficiencia ha impulsado un aumento en la adopción de LoRAX en AWS, donde se están desarrollando soluciones para el despliegue de adaptadores LoRA. Con el respaldo de una comunidad activa y la opción de personalizar integraciones, LoRAX se erige como una alternativa viable para el despliegue de modelos de inteligencia artificial generativa, especialmente en contextos que requieren un soporte robusto.

En última instancia, la implementación de LoRAX no solo optimiza la gestión de modelos a gran escala, sino que también ofrece un control más flexible y económico de los costos asociados, permitiendo a las empresas maximizar el potencial de los modelos de fundación para satisfacer sus necesidades específicas en el panorama digital actual.