Amazon ha lanzado recientemente los Amazon Bedrock Agents, permitiendo a las empresas desarrollar rápidamente aplicaciones de inteligencia artificial generativa para realizar tareas complejas a partir de múltiples sistemas y fuentes de datos. No obstante, en algunas regiones y sectores regulados, las normativas de protección de datos han creado la necesidad de integrar servicios de IA generativa en la nube con datos que deben permanecer en las instalaciones de las empresas. Para abordar estas inquietudes, AWS ha ampliado la funcionalidad de Amazon Bedrock Agents para incluir servicios híbridos y de borde, como AWS Outposts y AWS Local Zones. Esto facilita la creación de aplicaciones de generación aumentada por recuperación (RAG) que utilizan datos locales.

Las organizaciones que necesitan procesar o almacenar información sensible, como los datos personales identificables (PII), han manifestado la necesidad de que la infraestructura de AWS cumpla con las normativas locales y les permita manejar datos de manera conforme. La combinación de servicios híbridos y de borde ofrece a las empresas la escalabilidad y flexibilidad de la nube de AWS, manteniendo a la vez la capacidad de procesamiento local y de baja latencia que permite un cumplimiento normativo más efectivo.

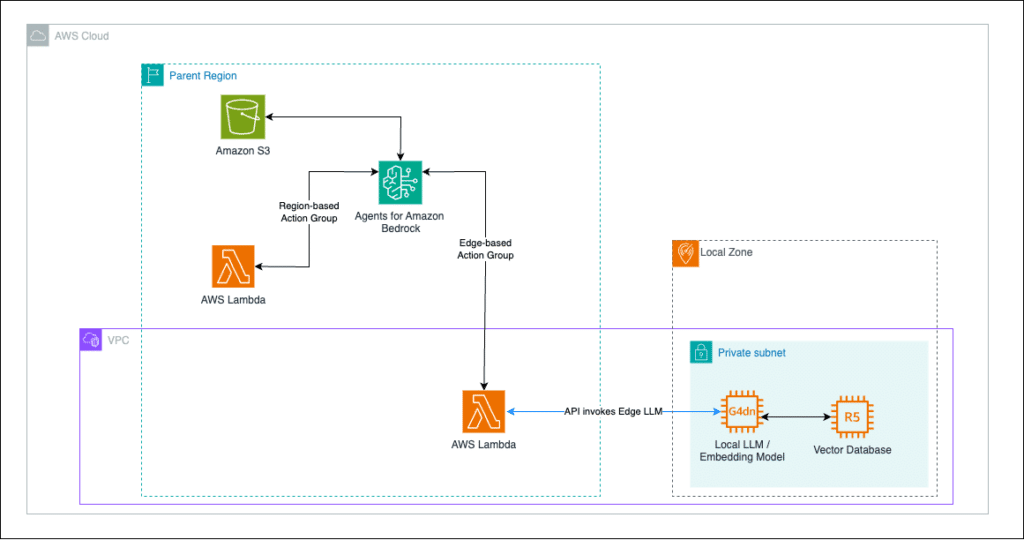

La arquitectura destinada a implementar estas soluciones se divide en dos patrones principales: RAG completamente local y RAG híbrido. El primero implica el uso de una instancia local en un rack de Outposts, donde se aloja el modelo de lenguaje grande (LLM) y las bases de datos de conocimiento, garantizando que los datos sensibles no abandonen las instalaciones. El enfoque híbrido, por su parte, permite operar modelos de IA en varias ubicaciones, incluyendo la nube y entornos locales, asegurando que los datos regulados se mantengan dentro de ciertos límites estatales.

Amazon Bedrock Agents facilita la construcción y configuración de agentes autónomos que interactúan con modelos, fuentes de datos y aplicaciones de software. Esto incluye la capacidad de invocar funciones de AWS Lambda para operar modelos autogestionados en el borde. Un ejemplo de esta funcionalidad se encuentra en un chatbot de servicio al cliente de un minorista de calzado, el cual utiliza una base de conocimiento local para responder consultas específicas sobre la fabricación de zapatos, mientras que las preguntas más generales se manejan a través de la infraestructura en la nube.

AWS sigue comprometido con ayudar a las organizaciones a implementar soluciones de IA generativa cumpliendo con las normativas de privacidad y seguridad, facilitando que se beneficien de la innovación mientras protegen sus datos sensibles. Con la capacidad de ejecutar modelos cerca de los dispositivos y usuarios finales, las empresas pueden mejorar la latencia y la privacidad, incrementando la eficiencia operativa y el cumplimiento regulatorio.