En los últimos años, el auge de los modelos de lenguaje de gran tamaño (LLMs) ha impulsado la adopción de la inteligencia artificial en diversas industrias. No obstante, para potenciar aún más las capacidades de los LLMs y aprovechar información actualizada y conocimientos específicos del dominio, es esencial integrar fuentes de datos externas. En este contexto, la Generación Aumentada por Recuperación (RAG) ha emergido como una solución eficaz para abordar este desafío.

La técnica RAG busca información relevante en bases de datos o documentos existentes en función de la entrada del usuario e incorpora esa información en la solicitud al LLM, generando respuestas más precisas y contextuales. Este enfoque se implementa en diversas aplicaciones, desde la documentación técnica en el desarrollo de productos hasta la atención al cliente y el apoyo a sistemas de toma de decisiones con datos actualizados.

La implementación de RAG aporta un valor significativo a los proveedores de software como servicio (SaaS) y a sus usuarios. Los proveedores pueden beneficiarse de una arquitectura multi-tenant que ofrece servicios a múltiples inquilinos desde una única base de código. A medida que estos inquilinos utilizan el servicio, sus datos se acumulan, estando protegidos por controles de acceso y aislamiento de datos adecuados. RAG permite utilizar datos específicos de cada inquilino para ofrecer servicios de IA personalizados.

Por ejemplo, en un centro de atención telefónica SaaS, los registros históricos, preguntas frecuentes y manuales de productos se acumulan como bases de conocimiento específicas. Al implementar un sistema RAG, el LLM genera respuestas adecuadas a partir de estas fuentes, permitiendo interacciones precisas que integran conocimientos comerciales particulares. Esta personalización no se lograría con asistentes de IA genéricos. Así, RAG se convierte en esencial para proporcionar experiencias de IA personalizadas en entornos SaaS, mejorando la diferenciación del servicio y su valor.

Sin embargo, el uso de RAG con datos específicos plantea desafíos técnicos de seguridad y privacidad. La preocupación principal es mantener una arquitectura segura que garantice el aislamiento de datos entre inquilinos y evite filtraciones o accesos indebidos. En entornos multi-tenant, la seguridad de datos se vuelve crucial para la confiabilidad y ventaja competitiva de los proveedores de SaaS.

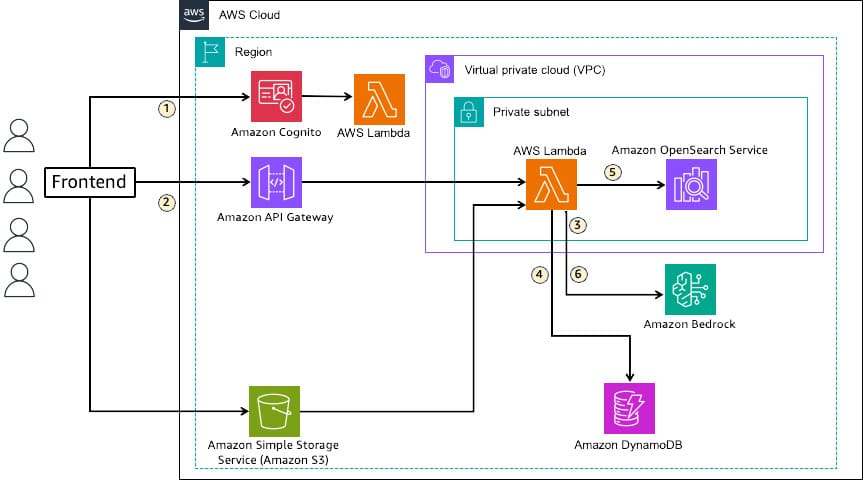

Para simplificar la implementación de RAG, Amazon Bedrock Knowledge Bases proporciona una solución. Utilizando OpenSearch como base de datos vectorial, ofrece Amazon OpenSearch Service o Amazon OpenSearch Serverless, cada cual con características y modelos de permisos adecuados para entornos multi-tenant. La combinación de JSON Web Token (JWT) y Control de Acceso Basado en Atributos (FGAC) ofrece una solución eficaz para el aislamiento de inquilinos, garantizando una gestión efectiva de acceso y control de datos.

La solución emplea autenticación con JWT para asegurar el aislamiento de datos en OpenSearch Service, estableciendo una separación clara de permisos de acceso. Con RAG, la búsqueda de información relevante a partir de consultas del usuario enriquece al LLM con contexto adicional, mejorando la calidad y precisión de las respuestas generadas.

A medida que el uso de RAG se intensifica en el sector SaaS, los desafíos técnicos en el manejo de datos multi-tenant demandan soluciones seguras e innovadoras que protejan la información sensible y al mismo tiempo maximicen la utilidad de los sistemas de IA. Esto representa un avance crucial en la evolución del software y servicios en la nube, donde la personalización y la seguridad son más críticas que nunca.