Los modelos de generación de música han emergido como herramientas revolucionarias que transforman el texto del lenguaje natural en composiciones musicales. Este avance, nacido de la inteligencia artificial (IA) y el aprendizaje profundo, permite a los sistemas comprender y traducir texto descriptivo en música coherente y estéticamente atractiva. Gracias a su capacidad de democratizar la producción musical, individuos sin formación formal musical pueden crear piezas de alta calidad simplemente describiendo sus deseos en palabras.

La IA generativa está cambiando radicalmente la creación y el consumo de música. Las empresas pueden sacar provecho de esta tecnología para desarrollar nuevos productos, mejorar procesos y abrir nuevas oportunidades, generando un impacto significativo en el mundo de los negocios. Estos modelos tienen una variedad de aplicaciones, desde la creación de bandas sonoras personalizadas para multimedia y videojuegos, hasta el uso en entornos educativos para estudiantes que estudian estilos y estructuras musicales. Los artistas y compositores también se benefician de nuevas ideas y composiciones, promoviendo la creatividad y la colaboración.

Un ejemplo notable de este tipo de herramienta es AudioCraft MusicGen de Meta. El código de MusicGen ha sido liberado bajo la licencia MIT, y los pesos del modelo bajo CC-BY-NC 4.0. MusicGen tiene la capacidad de crear música a partir de texto o melodías, ofreciendo un mayor control sobre el resultado final. Utiliza tecnología de IA avanzada para generar una amplia gama de estilos y géneros musicales, satisfaciendo diversas necesidades creativas. A diferencia de métodos tradicionales que usan cascadas de varios modelos, MusicGen opera como un único modelo de lenguaje sobre múltiples flujos de representación musical comprimida, permitiendo un control preciso sobre la generación de muestras mono y estéreo de alta calidad adaptadas al gusto del usuario.

Estos modelos pueden ser utilizados en el ámbito educativo, la creación de contenido y la composición musical. Permiten a los estudiantes experimentar con diferentes estilos, generar bandas sonoras personalizadas y crear composiciones únicas. Además, MusicGen ayuda a músicos y compositores, fomentando la innovación y la creatividad en sus procesos.

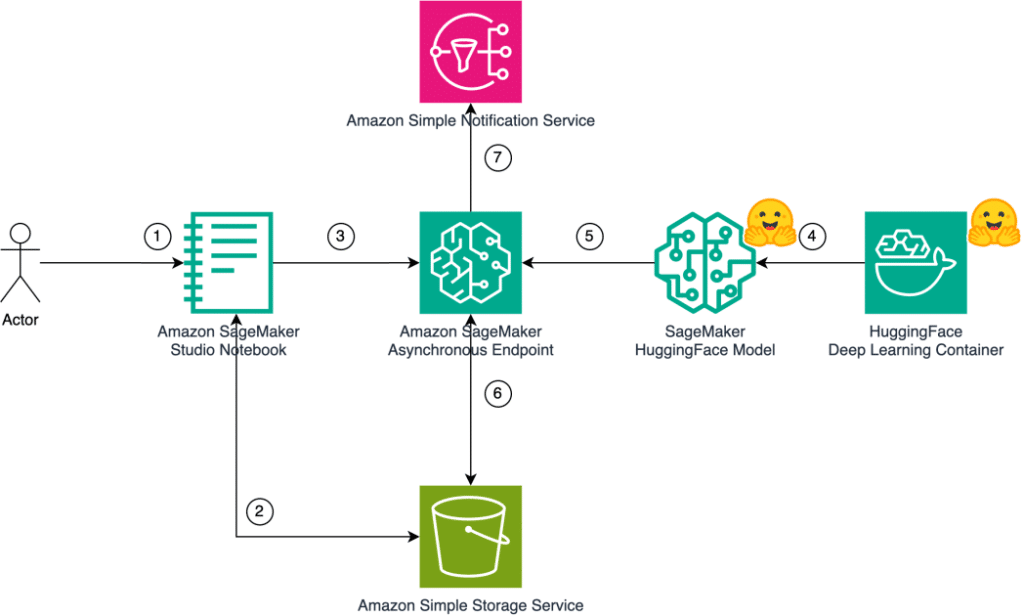

La implementación de MusicGen en Amazon SageMaker, utilizando la inferencia asincrónica, es particularmente efectiva. Este método implica el despliegue de los modelos de AudioCraft MusicGen obtenidos del Hugging Face Model Hub en la infraestructura de SageMaker. La arquitectura de esta solución permite a los usuarios crear música usando texto en lenguaje natural como entrada, empleando los modelos de AudioCraft MusicGen desplegados en SageMaker.

Los pasos detallados muestran la secuencia desde la entrada del usuario hasta la generación de la salida musical. Esta configuración aumenta la eficiencia y maximiza los recursos disponibles, gracias a la escalabilidad automática de las instancias de inferencia asincrónica de SageMaker.

Para aquellos interesados en explorar estas capacidades y comenzar a generar música a partir de sus ideas creativas, esta herramienta ofrece un camino accesible y sofisticado para la innovación musical con IA. Los interesados en implementar este modelo pueden encontrar el código fuente completo y detalles adicionales en los repositorios oficiales de GitHub.