El CEO de NVIDIA comparó la mente de Elon Musk con una “GPU definitiva” en el podcast BG2 y apuntó a su capacidad para orquestar proyectos extremos de supercomputación. El comentario llega mientras xAI levanta en Memphis (Tennessee) un clúster de entrenamiento de IA de escala gigavatio y, según datos difundidos en las últimas semanas, con al menos 200.000 GPU instaladas y cientos de millones de dólares ya comprometidos.

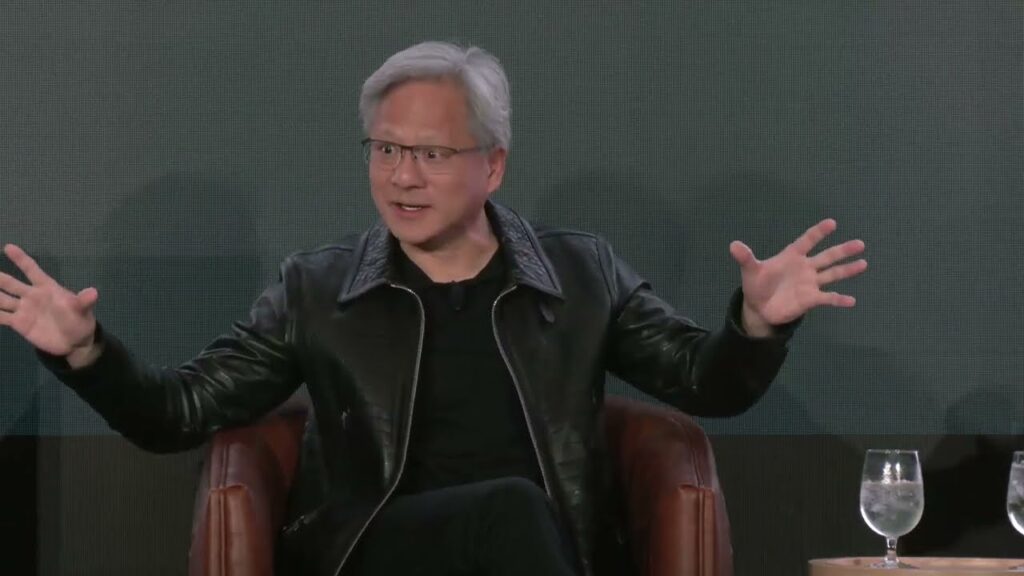

La metáfora no pudo ser más gráfica ni más estratégica. Jensen Huang, consejero delegado de NVIDIA, describió a Elon Musk como «la GPU definitiva» durante una conversación reciente en el podcast BG2, una forma de condensar —con un guiño a los chips que fabrica su propia empresa— la impresión de que el fundador de Tesla, xAI y SpaceX “tiene en la cabeza todas las piezas” de sistemas de una complejidad inédita: supercomputadores de IA que combinan miles de aceleradores, redes de altísimo ancho de banda, suministro eléctrico masivo y financiación milimetrada. Huang llegó a señalar que Musk podría ser el primero en alcanzar la escala de 1 gigavatio en cómputo de IA.

El elogio no es aislado y llega en un momento en el que xAI acelera la construcción de Colossus II, un clúster de entrenamiento de IA en Memphis (Tennessee) cuya ambición no es menor: convertirse en el primer entrenamiento de IA a escala gigavatio del mundo. Informaciones recientes hablan de un despliegue con al menos 200.000 GPU de NVIDIA, una inversión superior a 400 millones de dólares ya desembolsada y un plan de crecimiento hacia el millón de unidades. Todo ello se ha levantado en tiempos poco habituales para la industria, con hitos como duplicar el sistema hasta 200.000 GPU en apenas tres meses tras una primera fase completada en cuatro.

Por qué Huang ve a Musk como “una GPU humana”

Más allá del soundbite, el razonamiento de Huang se apoya en la dificultad extrema de poner en marcha supercomputadores de IA a gran escala: no es sólo cuestión de conseguir chips, sino de encajar al mismo tiempo diseño de red, interconexión, energía, refrigeración, centros de datos, suministro estable, financiación y equipos de ingeniería capaces de operar al límite 24/7. Según relató el directivo, Musk condensa en su cabeza las interdependencias técnicas y financieras y empuja los proyectos con un sentido de urgencia poco común. De ahí la hipérbole: equiparar su cerebro con una GPU —el corazón de la computación acelerada— subraya su capacidad de paralelización mental y de ejecución.

El contexto industrial y comercial también ayuda a entender el tono. Las compañías de Musk —xAI, Tesla, SpaceX y la propia X— figuran entre clientes relevantes de NVIDIA. Al mismo tiempo, el fabricante de GPU se alinea con otros actores clave del ecosistema de IA, tejiendo acuerdos a gran escala con hyperscalers y laboratorios punteros. En la práctica, NVIDIA suministra a ambos frentes de la carrera: la visión de xAI capitaneada por Musk y la hiperescala de otros gigantes, apoyados por grandes nubes públicas.

Colossus II y la carrera por el gigavatio

La escala gigavatio se ha convertido en línea de meta en la carrera por la IA de propósito general. Un gigavatio no es una cifra de márketing: expresa la potencia eléctrica necesaria para alimentar fábricas de cómputo con cientos de miles de GPU trabajando en paralelo. En ese rango, hablar de latencias de millones de tokens por segundo y de ventanas de entrenamiento para modelos con billones de parámetros obliga a un salto de infraestructura que está reescribiendo la arquitectura de los centros de datos.

En Memphis, Colossus II se presenta como acicate de esa transición. Los anuncios y reportes han ido dibujando un proyecto que crece por capas: una primera oleada de H100/H200, nodos de nueva generación basados en plataformas Grace Blackwell y siguientes actualizaciones sobre la marcha; objetivo de alcanzar y superar el medio millón de aceleradores y, de ahí, escalar. Aunque la cifra exacta puede variar según fases y ramp-ups, la constante es la misma: acelerar.

La velocidad de ejecución es, de hecho, uno de los puntos que Huang subraya al atribuir a Musk un “gran sentido de la urgencia”. Si se toman como referencia los 122 días que xAI reivindica para levantar la primera gran fase de Colossus y los 92 días posteriores para duplicarlo a 200.000 GPU, la cadencia de obra, suministro, instalación y puesta en marcha resulta inusual. Para los observadores, esa integración vertical de decisiones —diseño, logística, compra, construcción y operación— es parte del factor Musk.

¿Hipérbole o diagnóstico?

El comentario «Musk es la GPU definitiva» puede leerse como hipérbole inspirada o como diagnóstico sobre el tipo de liderazgo que requieren los hiperproyectos de IA. Huang, que vende las GPU que alimentan tanto a xAI como a otros laboratorios y nubes, sabe que el cuello de botella ya no son sólo los chips: son las redes ópticas, los transformadores, los terrenos, los equipos eléctricos, el packaging avanzado, los plazos regulatorios y la energía. En ese escenario, quien encaja el puzzle antes, genera ventaja.

No es casual que, en paralelo al elogio, el discurso público del sector apunte a la competencia global por capacidad de cómputo y acceso a GPU en un mercado donde la demanda supera a la oferta. El trasfondo es claro: la carrera no solo va de algoritmos, sino de gigavatios, kilómetros de fibra y cadenas de suministro capaces de sostener el ritmo.

La aritmética del músculo: 200.000 GPU, 400 millones y camino al millón

Varios reportes han apuntado que el sitio de Memphis rebasa las 200.000 GPU instaladas, con más de 400 millones de dólares ya invertidos, y que xAI aspira a escalar hacia el millón de unidades en las inmediaciones. Más allá de las cifras —que pueden fluctuar por fases, sustitución de modelos o mejoras de densidad—, el patrón es claro: aumentar la huella hasta niveles inéditos, convertir el suministro eléctrico en variable de diseño y rodear el clúster de una cadena logística capaz de sostener operación continua.

A ello se suma la dinámica competitiva: NVIDIA avanza acuerdos estructurales con diversos actores para anclar gigavatios futuros; xAI presiona por su gigavatio en Memphis; y otros jugadores —desde hyperscalers hasta consorcios nacionales— avanzan planes similares. En ese tablero, las frases lapidarias ayudan a fijar narrativa —y confianza— en torno a quién lidera cada tramo de la carrera.

¿Qué implica para la industria?

- Estandarización de “fábricas de IA”. La idea de AI factories —centros de datos especializados en entrenamiento e inferencia— tiende a modularizar el diseño: bloques de potencia, bloques de redes y bloques de GPU replicables. Eso permite acelerar despliegues y mejorar el TCO en la escala de cientos de megavatios o gigavatios.

- Competencia por la energía. El gigavatio sitúa a la IA compitiendo por capacidad eléctrica con sectores industriales históricos. Estados y empresas empiezan a co-diseñar subestaciones, microgrids, sistemas BESS (baterías a escala red) y contratos PPA con renovables para blindar suministro y reducir la huella de carbono.

- Nuevos cuellos de botella. Aunque las GPU sigan siendo críticas, aparecen otras restricciones: mano de obra especializada, fibras y switches ópticos, sustratos avanzados de packaging y plazos urbanísticos/regulatorios. El tiempo se convierte en ventaja competitiva.

- Geopolítica del cómputo. La soberanía digital se mide ya en capacidad de entrenamiento. Quien acumula y opera cómodo en el rango 100–1.000 MW de cómputo puede marcar ritmo científico, industrial y militar.

La lectura editorial: del meme a la métrica

Comparar a Musk con una GPU puede sonar a meme tecnológico, pero encierra una métrica: paralelizar decisiones a la velocidad y escala que exigen las infraestructuras de IA. Huang —ingeniero, vendedor y estratega— elige bien sus metáforas. A la vez, protege un posicionamiento: NVIDIA como proveedor central de quien quiera llegar al gigavatio y como interlocutor —también político— en la gestión global de la capacidad de cómputo.

En la batalla por el futuro de la IA, los adjetivos importan menos que los megavatios reales y los tokens por segundo. Colossus II actúa como símbolo de la era gigavatio, pero es la capacidad sostenida —confiable, eficiente y con buenos costes marginales— la que marcará diferencias. En ese tramo, la industria mirará menos a los tuits y más a los PUE, a los SLAs y a las curvas de aprendizaje de equipos que ya operan granjas de GPU como si fueran refinerías de cálculo.

Preguntas frecuentes

¿Qué quiso decir Jensen Huang con «Elon Musk es la GPU definitiva»?

Fue una metáfora para subrayar la capacidad singular de Musk para coordinar aspectos técnicos, financieros, logísticos y energéticos de supercomputadores de IA de escala extrema. El mensaje: su liderazgo encaja las piezas necesarias —chips, redes, energía y capital— para ejecutar proyectos que exigen decisiones en paralelo y velocidad.

¿Qué es Colossus II y por qué se habla de un clúster “de gigavatio”?

Colossus II es el clúster de entrenamiento de IA que xAI construye en Memphis (Tennessee). La denominación “gigavatio” se refiere a la potencia eléctrica objetivo para alimentar una fábrica de cómputo con cientos de miles de GPU trabajando en paralelo. Es el umbral simbólico y práctico de la nueva era del entrenamiento a gran escala.

¿Cómo encaja NVIDIA en esta historia si también colabora con otros actores?

NVIDIA suministra hardware y software a múltiples frentes de la carrera por la IA. Mientras xAI escala su clúster, la compañía teje alianzas con otros laboratorios y nubes para desplegar centros de datos de próxima generación. Su estrategia pasa por asegurar oferta para varios ganadores del entrenamiento a gran escala.

¿Hasta qué punto es creíble alcanzar un millón de GPU?

El objetivo existe en planes y proyecciones. Su viabilidad depende de suministro de chips, energía disponible, red óptica, packaging avanzado y ejecución industrial. Memphis se observa como caso de estudio por la velocidad de construcción y ramp-up logrados hasta ahora; el verdadero reto será sostener operación, costes y eficiencia a medida que la escala crezca.