El debate sobre si los ASICs de Big Tech —como los TPUs de Google o los chips propios de Amazon— podrán destronar a NVIDIA en la era de la inteligencia artificial vuelve a subir de temperatura. Pero Jensen Huang, consejero delegado de NVIDIA, lo tiene claro: el verdadero campo de batalla no está entre marcas, sino entre equipos de ingeniería capaces de construir sistemas extremadamente complejos de forma sostenida en el tiempo.

Sus últimas declaraciones, durante la presentación de resultados del tercer trimestre, apuntan a un mensaje muy directo: no hay muchos equipos en el mundo capaces de hacer lo que hace NVIDIA, y por eso la compañía no ve a los ASICs como una amenaza estructural a corto plazo para su posición dominante.

El contexto: ASICs vs GPU, la “supuesta” transición de entrenamiento a inferencia

A medida que el mercado de la IA va madurando, muchos analistas han asumido un relato muy concreto:

- La etapa de entrenamiento masivo de modelos fundacionales estaría dando paso a una fase donde pesa más la inferencia a gran escala.

- En esa fase, los ASICs (Application-Specific Integrated Circuits) —chips hechos a medida para tareas concretas, como los TPUs de Google— podrían resultar más eficientes, más baratos por operación y, por tanto, un sustituto natural de las GPU de propósito más general.

Ese es el marco en el que entra la pregunta de un analista a Huang, citando específicamente el reciente acuerdo con Anthropic, que combina infraestructura basada en sistemas Blackwell y Rubin de NVIDIA con el uso, en paralelo, de los nuevos TPUs de Google (Ironwood).

La duda era clara: si grandes clientes como Anthropic diversifican y empiezan a usar ASICs de terceros a gran escala, ¿no significa eso que el stack de NVIDIA es, en el fondo, reemplazable?

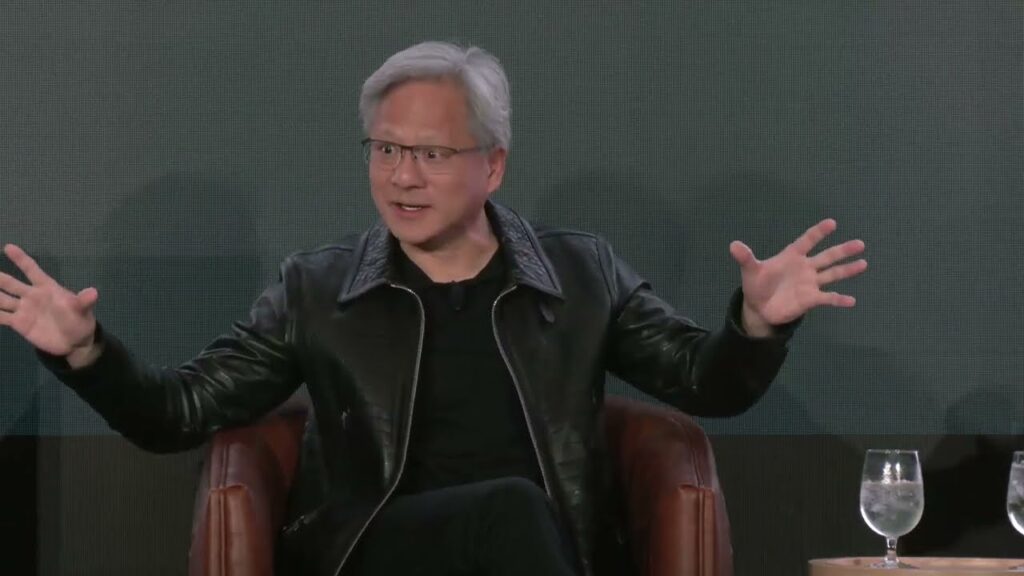

Huang: «No compites contra empresas, compites contra equipos»

La respuesta de Jensen Huang fue reveladora:

«No compites contra una empresa, compites contra equipos. Y no hay tantos equipos en el mundo que sean extraordinarios construyendo cosas tan increíblemente complejas».

Traducido al lenguaje de negocio:

- Google, Amazon o cualquier gran CSP pueden diseñar sus propios chips.

- Pero diseñar el silicio es solo una parte del problema.

- Lo que realmente marca la diferencia es disponer de un equipo capaz de coordinar hardware, software, librerías, drivers, compiladores, herramientas de desarrollo, documentación y soporte, versión tras versión, durante años.

Huang viene a decir que, incluso si un ASIC alcanza un buen rendimiento en papel, igualar el ritmo de innovación y la cohesión del ecosistema NVIDIA no es algo que muchos grupos de ingeniería puedan sostener.

Anthropic, TPUs y el mensaje entre líneas

El caso de Anthropic es especialmente simbólico:

- Por un lado, firma un acuerdo con NVIDIA para construir infraestructura basada en Blackwell y Rubin, con despliegues de gran escala.

- Por otro, también acuerda utilizar Ironwood TPU de Google para parte de sus cargas de inferencia.

Para algunos analistas, esa combinación era la prueba de que NVIDIA empezaba a perder exclusividad en los grandes contratos.

Huang, sin embargo, utiliza justo ese ejemplo para subrayar que:

- Las grandes compañías pueden y van a usar chips de varios proveedores.

- Pero eso no implica que el stack de NVIDIA sea fácilmente sustituible.

- La verdadera competencia no es tanto “NVIDIA vs Google”, sino “equipo que integra todo el stack vs equipo que intenta ponerse al día”.

En otras palabras: NVIDIA está dispuesta a convivir con ASICs específicos dentro de arquitecturas mixtas, siempre que el “esqueleto” principal siga siendo su ecosistema de hardware y, sobre todo, de software.

El factor clave: CUDA como muro defensivo

Huang también envía un mensaje implícito pero evidente: incluso si un ASIC pudiera igualar o superar en bruto el rendimiento de una GPU de NVIDIA, seguiría quedando el problema del software.

El ecosistema CUDA se ha convertido en un estándar de facto en IA:

- Millones de líneas de código, herramientas, frameworks y modelos están ya optimizados para GPU de NVIDIA.

- La mayoría de investigaciones en deep learning de la última década se han hecho sobre CUDA.

- Muchas librerías críticas —desde entrenamiento distribuido hasta inferencia optimizada— se publican primero o únicamente con soporte NVIDIA.

Para un proveedor de servicios cloud (CSP), Huang plantea una cuestión muy práctica:

¿Qué es más óptimo, llenar el centro de datos con ASICs “random” que exigen porting y mantenimiento específico, o apostar por NVIDIA, que ya trae detrás un ecosistema maduro, documentado y con una base de desarrolladores enorme?

Su argumento es que incluso si se logra un ASIC muy eficiente para una tarea concreta, el coste total de propiedad (TCO) —en desarrollo, mantenimiento y talento— puede seguir favoreciendo a NVIDIA.

¿De verdad los ASICs no son una amenaza?

El discurso de Huang es coherente desde la perspectiva de NVIDIA, pero deja espacio para el matiz:

- Google lleva años afinando sus TPUs, que ya se utilizan en producción para muchos servicios internos y externos.

- Amazon, Microsoft y otros grandes actores también están invirtiendo en silicio propio, con el objetivo claro de reducir dependencia y costes.

- A medida que la inferencia represente una parte mayor del gasto en IA, el incentivo para tener ASICs de altísima eficiencia crecerá.

Sin embargo, la realidad operativa de los centros de datos es que pocas empresas pueden permitirse apoyarse solo en hardware propietario, sin una base sólida en GPU de NVIDIA, al menos a día de hoy.

En ese sentido, la lectura más razonable es que:

- A corto y medio plazo, los ASICs complementarán a NVIDIA en determinadas cargas de trabajo.

- La “desnvidiaficación” total del stack de IA parece, hoy por hoy, muy improbable.

- El factor decisivo serán los equipos y el software, no únicamente la hoja de especificaciones del chip.

Y es precisamente ahí donde Huang insiste: la carrera no es solo por el mejor chip, sino por el mejor equipo de ingeniería capaz de evolucionar un ecosistema completo generación tras generación.

Un mensaje a clientes y rivales: NVIDIA quiere ser “irremplazable”

Al final, las declaraciones de Jensen Huang persiguen varios objetivos simultáneos:

- Tranquilizar a inversores y clientes: aunque los titulares hablen de TPUs, XPUs y ASICs personalizados, NVIDIA se ve a sí misma como el ancla del ecosistema de IA, no como un proveedor fácilmente substituible.

- Reivindicar el valor del stack completo: hardware, software, librerías, compiladores, frameworks… No basta con fabricar un chip, hay que sostener una plataforma.

- Marcar territorio frente a Big Tech: Google, Amazon o Microsoft pueden invertir miles de millones en silicio propio, pero Huang sugiere que muy pocos equipos pueden mantener el ritmo de NVIDIA en todas las fases del ciclo de innovación: pre-entrenamiento, post-entrenamiento e inferencia.

Mientras tanto, el mercado seguirá probando alternativas. Pero, si de algo está convencido el CEO de NVIDIA, es de que no basta con diseñar un ASIC brillante en el laboratorio: hace falta un ejército de ingenieros, años de iteración y una comunidad de desarrolladores dispuesta a apostar por esa plataforma.

Y, de momento, ese terreno sigue siendo, principalmente, territorio de NVIDIA.

vía: wccftech