Durante meses, el consenso parecía claro: los modelos cerrados de última generación —ahí donde los analistas colocan a GPT-5— marcarían el techo de la capacidad de razonamiento y rendimiento general. La irrupción de Kimi K2 Thinking, el nuevo modelo abierto de la china Moonshot, ha roto esa narrativa. No sólo por la cifra que encabeza su ficha técnica —un billón de parámetros—, sino por el enfoque con el que sus autores dicen haber afinado la capacidad de “pensar” del sistema. El lanzamiento reabre un debate de fondo: ¿se puede competir en la frontera de la IA con modelos abiertos y técnicas que miran más allá del “cuanto más grande, mejor”?

Moonshot, la compañía que está detrás del asistente Kimi, ha publicado la página técnica de K2 Thinking con una mezcla muy poco habitual en un anuncio comercial: fórmulas, geometría diferencial y detalles de construcción. El documento no es un folleto de marketing: se adentra en mapas logarítmicos, transporte paralelo y densidades en espacios hiperbólicos; conceptos que, traducidos, apuntan a una idea sencilla: reformular el espacio donde el modelo “razona” para que las cadenas de deducción se conserven de forma más estable y eficiente.

Un modelo abierto… y gigantesco

La primera afirmación que ha atraído titulares es el tamaño: ≈ 1.000.000.000.000 de parámetros. Ese orden de magnitud rompe la barrera simbólica de los “trillion-scale models” en la esfera open-weight y sitúa a K2 Thinking en la liga de los sistemas más grandes que se han anunciado públicamente. La compañía lo presenta como un modelo abierto, una decisión que, si se confirma con pesos y licencia disponibles, tendrá un impacto directo en la comunidad investigadora y en empresas que no pueden o no quieren encadenar su operación a un servicio cerrado.

El adjetivo Thinking no es casual. Moonshot sostiene que la arquitectura y el procedimiento de entrenamiento se han orientado a razonamiento de varios pasos, planificación y tareas de largo horizonte, campos en los que los grandes LLM empiezan a mostrar fatiga cuando deben mantener coherencia durante muchos tokens. El objetivo declarado: reducir al mínimo las alucinaciones, mejorar la consistencia lógica y hacer que el modelo “conserve ideas” a lo largo de diálogos extensos o problemas matemáticos complejos.

Por qué K2 habla de hipérbolas (y qué significa para el usuario)

Quien abra el documento técnico encontrará párrafos que parecen extraídos de una clase de geometría de Riemann: mapa logarítmico, transporte paralelo y distancias geodésicas en el modelo de Lorentz. ¿Qué pinta todo eso en un LLM? La intuición es la siguiente: si el modelo necesita mantener relaciones jerárquicas y estructuras de árbol (por ejemplo, descomponer un problema en subproblemas y volver a componer la solución), un espacio hiperbólico resulta más natural que el euclídeo porque representa mejor esas jerarquías con menos distorsión.

En términos prácticos, los autores describen cómo muestrear y transportar información en ese espacio hiperbólico de forma estable. Aparecen expresiones como la densidad log-pdf y factores de normalización (con términos del tipo sinh(r)/r) que corrigen el volumen cuando uno se mueve por la “curvatura negativa” del espacio. Esta aritmética no es decorativa: pretende evitar que el “hilo de pensamiento” se degrade cuando el modelo encadena pasos. Es, dicho en palabras llanas, un mecanismo para que la memoria de trabajo del sistema no se deshilache al razonar.

¿Se traduce esto en una experiencia distinta para el usuario? Si la implementación está a la altura, sí: menos pasos “en falso” al resolver un problema, menos vaivenes al justificar una respuesta y mayor coherencia en tareas que exigen mantener varias piezas en la cabeza durante mucho tiempo (programación, demostraciones matemáticas, análisis jurídico, planificación de proyectos).

¿Supera a GPT-5? Lo que se sabe (y lo que no)

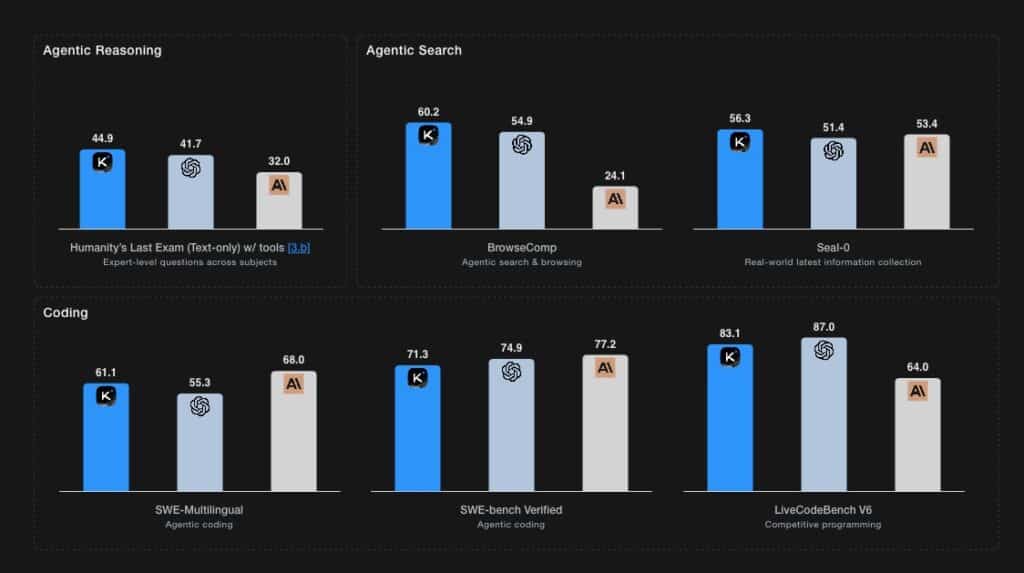

La comparación con GPT-5 —un sistema del que, por definición, hay poca información pública detallada— debe tratarse con prudencia. Que K2 Thinking sea más grande no implica, por sí solo, que sea mejor en tareas generales. El rendimiento real de un LLM depende tanto del entrenamiento, los datos, las instrucciones y el post-training como del recuento de parámetros. Y, a día de hoy, no hay baterías independientes de pruebas publicadas que permitan una comparación sólida 1:1 entre K2 y el modelo de OpenAI.

Lo que sí puede afirmarse con seguridad es que Moonshot ha levantado la mano con una propuesta abierta y ambiciosa en tamaño y en técnica, y que se suma a una corriente que crece: modelos abiertos con contextos ultra largos, razonamiento estructurado y mecanismos explícitos de “pensamiento” (ya sea con scratchpads, tool use o arquitecturas agénticas). La carrera por el “mejor modelo” ya no se dirime sólo en un gráfico de leaderboard, sino en quién logra llevar el pensamiento largo a producción con coste controlado.

Impacto para la comunidad y para la empresa

Si Moonshot publica pesos y licencia con condiciones razonables, K2 Thinking puede convertirse en una piedra de toque para universidades, laboratorios y compañías que necesitan auditar cómo razona un modelo, adaptarlo a su dominio o desplegar la IA en entornos bajo control (privacidad, soberanía del dato, cumplimiento). El salto a un billón de parámetros trae, eso sí, un peaje obvio: coste de inferencia y hardware. Ejecutar o afinar un modelo de este tamaño exige GPUs de última generación —las de clase H100/GB200 o equivalentes—, redes de alto ancho de banda y memoria HBM en abundancia.

Las empresas con casos de uso sensibles (sanidad, finanzas, sector público) miran con interés la posibilidad de operar modelos en su perímetro o en nubes privadas. Un modelo open-weight ofrece transparencia en seguridad y flexibilidad en el despliegue; a cambio, obliga a gestionar el TCO (coste total de propiedad) con mimo: cuantización, serving multimodelo, caching y políticas de token para mantener latencias y costes en línea con los objetivos del negocio.

¿Un punto de inflexión para el “open-weight”?

El anuncio de Moonshot se produce en un momento de recomposición del tablero. Por un lado, la demanda de cómputo crece de forma sostenida; por otro, los grandes proveedores de nube y chips afinan su oferta para servir IA a escala. En ese contexto, la apuesta por modelos abiertos y muy grandes no es sólo un gesto técnico: es una declaración estratégica. Indica que hay actores —no sólo en Estados Unidos— dispuestos a compartir la base del sistema a cambio de impulsar un ecosistema de innovación sobre él.

El encaje con la realidad geopolítica también aflora: China quiere —y necesita— pruebas de que puede jugar en la frontera técnica con propuestas propias. Un modelo abierto y de trillion scale es un argumento a la vez tecnológico y político.

Preguntas que quedan en el aire

La página técnica no resuelve algunas incógnitas clave:

- Disponibilidad de pesos y licencia. Moonshot califica K2 Thinking como modelo abierto, pero habrá que ver qué licencia elige (permisiva, comercial, restrictiva) y cómo permite afinados o redistribución.

- Datos y procedencia. La calidad del razonamiento está ligada al corpus y a las técnicas de post-training (RLHF, RLAIF, distillation). Transparencia aquí será decisiva para ganarse a la comunidad.

- Benchmarks independientes. Sin comparativas terceras en razonamiento, matemáticas, programación o seguridad, la valoración seguirá siendo preliminar.

- Coste de operación. El modelo exige infraestructura puntera; la pregunta es cómo encaja K2 Thinking en presupuestos reales y latencias de producto.

Aun con esas preguntas, el lanzamiento ya ha logrado su primer efecto: mover las expectativas. La intuición de que “lo mejor” quedaría cerrado se ha agrietado. Si K2 Thinking cumple lo que sugiere su ficha técnica, el campo de juego entre cerrado y abierto será más estrecho de lo que muchos imaginaron.

Preguntas frecuentes

¿Kimi K2 Thinking publica los pesos del modelo?

Moonshot presenta K2 Thinking como modelo abierto, con el objetivo de que la comunidad pueda usar y auditar el sistema. La disponibilidad efectiva de pesos y los términos de licencia serán determinantes para saber hasta dónde llega esa apertura (uso comercial, afinado, redistribución).

¿En qué se diferencia K2 Thinking de otros LLM abiertos?

Además del tamaño (≈ 1 billón de parámetros), el documento técnico apunta a un enfoque en razonamiento y planificación con geometría hiperbólica para estabilizar cadenas de pensamiento largas. La promesa es menos alucinación y mayor coherencia en tareas multistep frente a LLM clásicos de similar escala.

¿Necesito hardware especial para ejecutar K2 Thinking?

Un modelo de este tamaño requiere GPUs de última generación (clase H100/GB200 o equivalentes), memoria HBM elevada y redes de alto caudal si se sirve en clúster. Para despliegues empresariales, será clave la cuantización, el serving multimodelo y el uso de cachés para controlar latencias y costes.

¿Supera a GPT-5?

No existen benchmarks independientes publicados que permitan afirmarlo con rigor. K2 Thinking se posiciona para competir en razonamiento y tareas largas, pero la comparación directa con modelos cerrados exige pruebas de terceros con baterías estándar y escenarios reales.

Fuentes

- Moonshot AI — Kimi K2 Thinking (página técnica y detalles de construcción).