Durante años, el debate sobre la Inteligencia Artificial (IA) giró alrededor de algoritmos, arquitecturas y “trucos” de ingeniería. Hoy, en la frontera, la conversación se ha desplazado a algo mucho más terrenal: quién puede comprar, alimentar y operar la infraestructura necesaria para entrenar los modelos más avanzados.

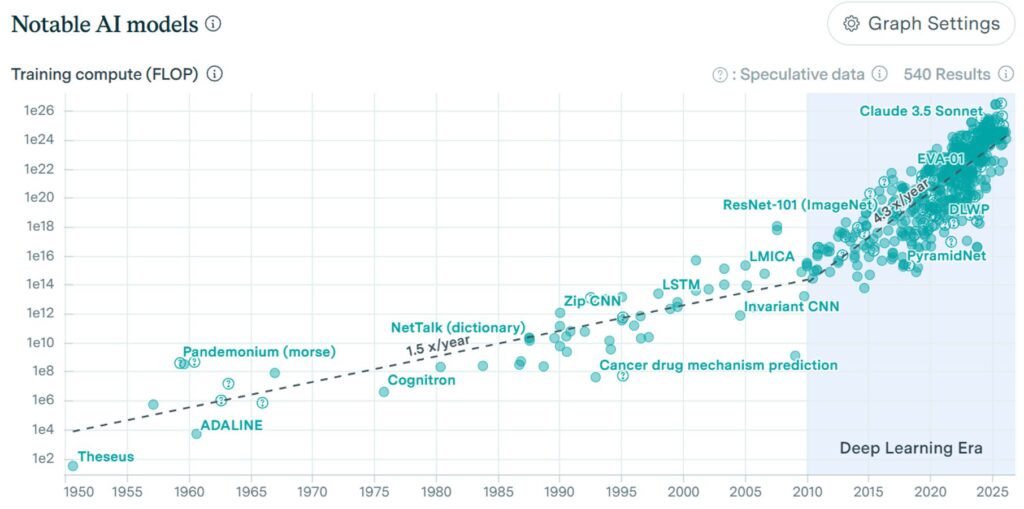

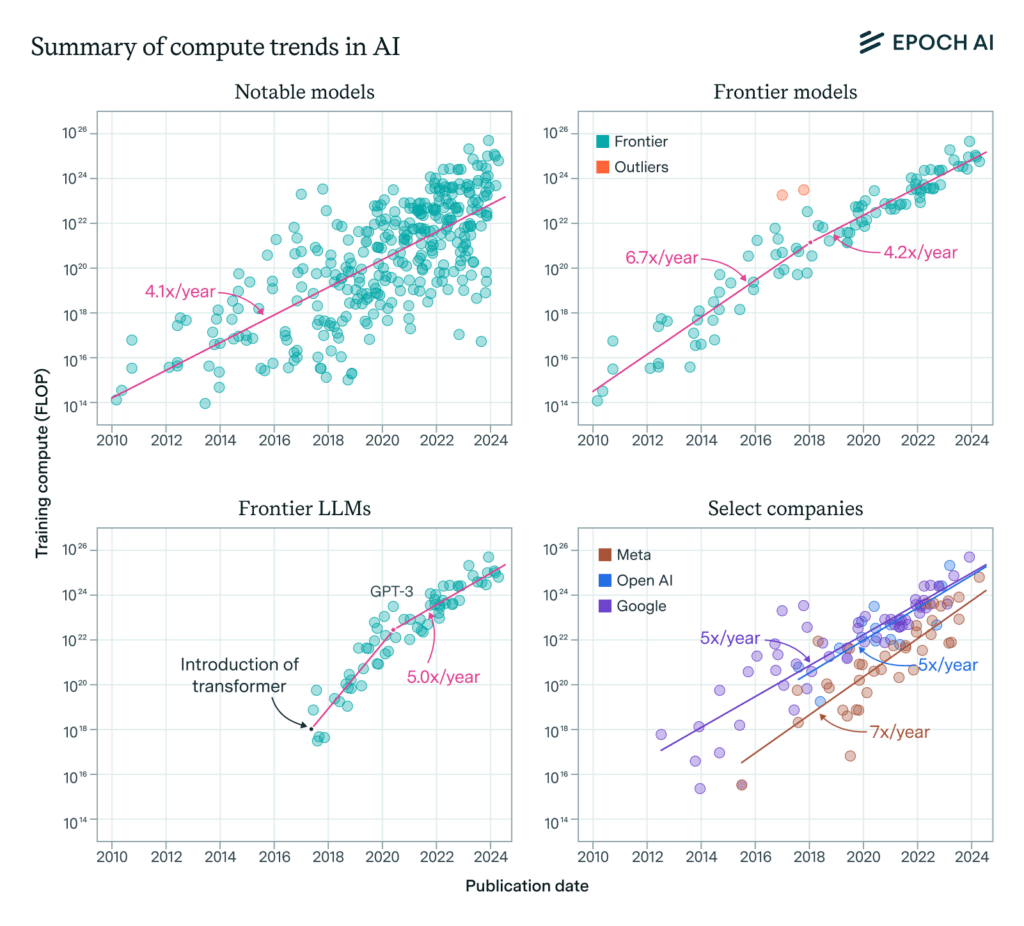

Los datos lo describen con crudeza. Un análisis de Epoch AI estima que el cómputo de entrenamiento en modelos “notables” creció a un ritmo aproximado de 4,1× al año entre 2010 y mayo de 2024, mientras que los modelos situados en la frontera (los que van marcando récords de escala) han estado alrededor de 5,3× al año en ese mismo periodo, con una tendencia reciente más cerca de 4–5× anual.

Por qué “4–5× al año” cambia las reglas del juego

Ese multiplicador no es un detalle técnico: es una palanca estratégica. En términos prácticos, significa que el “listón” del entrenamiento puntero se mueve tan rápido que solo unos pocos actores (por capital, acceso a hardware, energía y talento) pueden seguir el ritmo.

La comparación con la Ley de Moore sirve para aterrizarlo. Moore describió en 1965 la expectativa de que el número de componentes en circuitos integrados creciera de forma sostenida, un concepto que acabó popularizándose como una duplicación periódica del rendimiento/capacidad. Pero la IA moderna ha ido, en muchos tramos, por delante del calendario industrial clásico: OpenAI ya documentó hace años que el cómputo empleado en las mayores carreras de entrenamiento se estaba duplicando cada 3,4 meses en un periodo analizado (2012–2018), un ritmo explosivo para cualquier cadena de suministro tecnológica.

El tamaño del reto: cuando entrenar significa 10^26 operaciones

En el debate público aparecen cifras como 10^26 operaciones para entrenar modelos de frontera recientes. Expresado de forma más intuitiva (en escala larga, la habitual en castellano), es del orden de 100.000.000 de trillones de operaciones. Es una magnitud que, por sí sola, explica por qué la frontera de la IA se está convirtiendo en una carrera industrial y geopolítica:

- Industrial, porque depende de fábricas, logística, chips, redes, centros de datos y contratos energéticos.

- Geopolítica, porque esos recursos se concentran en regiones, alianzas y marcos regulatorios concretos.

Y aquí aparece una idea incómoda para muchos líderes: la innovación ya no se compra solo en forma de software. También se compra en forma de megavatios disponibles, plazos de conexión a red, disponibilidad de GPUs, capacidad de refrigeración y velocidad de despliegue.

El cuello de botella silencioso: energía (y su impacto directo en centros de datos)

Entrenar y operar modelos a gran escala no es “solo” cuestión de servidores: es cuestión de electricidad continua, estable y relativamente barata. La Agencia Internacional de la Energía (IEA) lo sitúa en cifras que ayudan a dimensionar el fenómeno: estima que el consumo eléctrico de los centros de datos a nivel global ronda los 415 TWh (aprox. 1,5 % del consumo mundial) y proyecta que podría llegar a 945 TWh en 2030 (cerca del 3,0 %), impulsado por el crecimiento del dato, la conectividad y, de forma destacada, la IA.

Este punto conecta directamente con la conversación europea: la red eléctrica, la planificación de capacidad y los plazos de conexión pasan a ser parte del “roadmap” tecnológico. Y eso explica por qué los anuncios relevantes en centros de datos ya no se presentan solo como proyectos inmobiliarios, sino como proyectos energético-industriales.

Europa y la escala: el caso de Madrid como laboratorio

En este contexto, no sorprende que Madrid se esté consolidando como uno de los polos europeos que intentan capturar parte de esa ola. Un ejemplo reciente: Iberdrola y Echelon Data Centres anunciaron una alianza para un modelo de desarrollo “hiperscale” (mejor dicho, para el ecosistema de hiperescalares) que ataca los tres frenos típicos del sector: suelo, acceso a red y velocidad de entrega. El proyecto en Madrid (Madrid Sur) se plantea con 144 MW IT y una conexión prevista de hasta 230 MW, con entrada en operación antes de 2030.

Más allá del titular corporativo, lo relevante es el mensaje: el centro de datos del futuro cercano no se gana solo con ingeniería de racks. Se gana con integración vertical (energía + infraestructura + permisos + ejecución).

Entonces, ¿cómo compiten quienes no pueden “escalar” al mismo ritmo?

Esta es la pregunta que se hacen cada vez más empresas (y países) fuera del reducido club capaz de orquestar infraestructuras gigantescas. Y aquí conviene separar mito de realidad:

- La frontera no es el único lugar donde hay valor.

La mayoría del impacto económico de la IA en empresas no vendrá de “tener el modelo más grande”, sino de aplicar modelos (propios o de terceros) a procesos concretos: atención al cliente, ingeniería, logística, fraude, mantenimiento predictivo, calidad, etc. - La eficiencia vuelve a estar de moda (y puede ser decisiva).

Hay margen real en ingeniería de software y de modelos: especialización, compresión, destilación, cuantización, mejores datos, mejores pipelines, inferencia optimizada… En muchos casos, ganar por eficiencia será más rentable que intentar ganar por escala bruta. - La arquitectura institucional importa tanto como la técnica.

Las ventajas pueden moverse hacia quien domine la gobernanza del dato, la integración con negocio, el cumplimiento normativo, la ciberseguridad y la capacidad de desplegar con fiabilidad. - Estrategias más distribuidas pueden ser racionales.

Frente a la obsesión por un único “modelo total”, gana peso una aproximación de múltiples modelos más pequeños y específicos (y, en paralelo, un enfoque más pragmático y distribuido en aplicaciones industriales, robótica o biomedicina).

La lectura para directivos: el nuevo mapa de ventajas competitivas

En 2026, la IA de frontera se parece menos a una carrera de laboratorio y más a una carrera de capacidad industrial. El acceso a cómputo, energía, capital y talento se convierte en una ventaja estructural —y, por extensión, en un factor que concentra poder de innovación en pocos actores.

La buena noticia es que eso no condena al resto a quedarse fuera. Pero sí obliga a cambiar la pregunta:

- No es “¿cómo entreno el modelo más grande?”

- Es “¿cómo convierto IA en productividad real, con eficiencia, seguridad y control del coste total?”

Y ahí, paradójicamente, la escala extrema deja de ser el centro del tablero. La ventaja puede estar en desplegar mejor, integrar más rápido, medir impacto con rigor y elegir con inteligencia cuándo pagar por escala… y cuándo no.