La evaluación del rendimiento de los modelos de lenguaje de gran tamaño (LLM) se ha convertido en un tema crucial para las organizaciones que desean maximizar los beneficios de esta tecnología en constante evolución. En respuesta a esta necesidad, se ha introducido un nuevo marco denominado «LLM-as-a-judge», que promete simplificar y optimizar el proceso de evaluación. Este enfoque innovador permite a las empresas evaluar la eficacia de sus modelos de inteligencia artificial utilizando métricas predefinidas, asegurando que la tecnología se adapte a sus necesidades y objetivos específicos. La implementación de este método permite a las compañías medir con precisión el rendimiento de sus sistemas de IA, facilitando decisiones informadas sobre la selección, optimización y despliegue de modelos. Como consecuencia, se espera que esta práctica no solo mejore la confiabilidad y eficiencia de las aplicaciones de IA, sino que también promueva un uso más estratégico de la tecnología en las organizaciones.

Amazon Bedrock es una de las plataformas que ha integrado estas capacidades avanzadas. Este servicio completamente gestionado ofrece modelos fundacionales de alto rendimiento de destacadas empresas de IA a través de una única API. Recientemente, Amazon Bedrock ha implementado dos capacidades significativas de evaluación: el uso de «LLM-as-a-judge» como parte de la Evaluación de Modelos de Amazon Bedrock y la evaluación RAG para las Bases de Conocimiento de Amazon Bedrock. Ambas funcionalidades emplean la técnica «LLM-as-a-judge» como soporte, aunque se enfocan en evaluar distintos aspectos. Este enfoque brinda una orientación exhaustiva sobre cómo configurar características, iniciar trabajos de evaluación a través de la consola y APIs de Python, y demuestra cómo esta característica innovadora de evaluación puede mejorar las aplicaciones de IA generativa utilizando múltiples métricas, incluyendo calidad, experiencia del usuario, cumplimiento de instrucciones y seguridad.

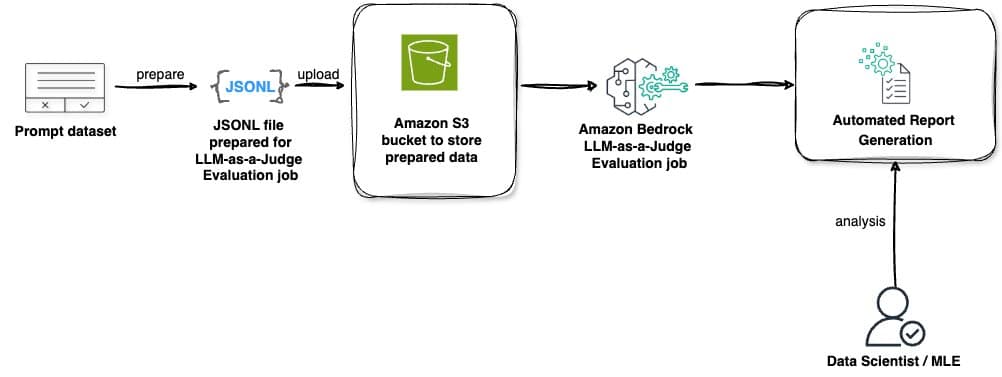

El método «LLM-as-a-judge» se distingue por diversas características clave que lo diferencian de los métodos de evaluación tradicionales. Una de sus principales ventajas es la automatización de la evaluación inteligente, donde los modelos previamente entrenados evalúan respuestas de manera automática, alcanzando una calidad comparable a la evaluación humana y logrando ahorros de costos de hasta el 98%. Además, este sistema abarca áreas esenciales de evaluación como la calidad (corrección, completitud, fidelidad), la experiencia del usuario (utilidad, coherencia, relevancia), el cumplimiento de instrucciones (adhesión a directrices, estilo profesional) y el monitoreo de seguridad (daños, estereotipos, manejo de rechazos). La integración de esta característica con Amazon Bedrock permite a los usuarios acceder a la funcionalidad mediante la consola de gestión de AWS, facilitando la incorporación de sus conjuntos de datos personalizados para fines evaluativos.

El marco de evaluación «LLM-as-a-judge» se presenta como una solución integral que ofrece a las organizaciones la posibilidad de optimizar el rendimiento de sus modelos de IA, manteniendo al mismo tiempo altos estándares de calidad y seguridad. Esta tecnología permite a las empresas asegurar que sus aplicaciones de inteligencia artificial no solo sean eficientes en términos operativos, sino también alineadas con sus objetivos estratégicos.