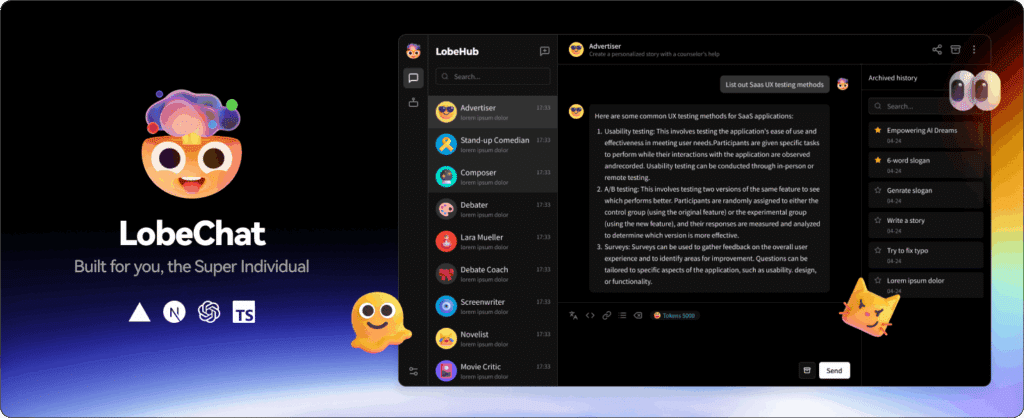

El ecosistema de herramientas para trabajar con modelos de lenguaje no deja de crecer, pero la mayoría comparten dos problemas: son servicios cerrados y dependen de un único proveedor de IA. LobeHub (y su aplicación principal, LobeChat) llega justo a romper ese esquema: es un workspace de agentes de IA open source, con diseño moderno, soporte para múltiples modelos, plugins MCP y despliegue propio con un clic.

Su objetivo es claro: convertirse en el “parque de juegos” donde tanto usuarios como desarrolladores puedan crear, combinar y desplegar sus propios agentes de IA de forma privada y flexible, sin quedar atados a una sola plataforma.

Un espacio de trabajo para agentes de IA, no solo un “chat”

LobeHub se presenta como un AI Agent Workspace, pensado para:

- Usuarios que solo quieren “entrar y usar” sin instalar nada (hay versión web).

- Desarrolladores que quieren montarse su propia instancia en Vercel, Docker o nubes como Alibaba Cloud.

- Equipos que necesitan un entorno controlado, con multiusuario, base de datos propia y conexión a múltiples proveedores de modelos.

Aunque se llama LobeChat, va mucho más allá de una interfaz de chat:

- Permite crear y gestionar agentes preconfigurados (tipo marketplace de GPTs).

- Integrar plugins y MCPs para conectar con APIs, bases de datos y servicios externos.

- Gestionar conocimiento propio (archivos, RAG, bases de conocimiento).

- Usar modelos en la nube o modelos locales con Ollama.

MCP Marketplace: conectar la IA con el mundo real

Uno de los pilares de LobeHub es el soporte nativo para MCP (Model Context Protocol), el estándar que está emergiendo para conectar modelos de lenguaje con herramientas externas.

LobeHub ofrece:

- Instalación de plugins MCP con un clic, directamente desde un MCP Marketplace propio.

- Conexión con APIs, BBDD, sistemas de ficheros y servicios externos, sin tener que programar toda la integración a mano.

- Un ecosistema en expansión de plugins que amplían lo que los agentes pueden hacer: buscar en la web, consultar datos, interactuar con otras plataformas, etc.

Para el usuario final, esto se traduce en algo muy simple:

el agente deja de ser un “chat aislado” y se convierte en un orquestador de acciones sobre servicios reales.

Conocimiento propio: archivos y RAG integrados

LobeChat integra funciones de file upload y knowledge base, permitiendo:

- Subir documentos, imágenes, audio y vídeo.

- Crear bases de conocimiento que el agente puede consultar durante la conversación.

- Hacer RAG (Retrieval Augmented Generation) de forma transparente para el usuario.

En la práctica, se puede montar:

- Un agente que responda sobre documentación interna.

- Un asistente que consulte informes, contratos o manuales técnicos.

- Un “chat” sobre PDFs, vídeos o contenido corporativo sin sacarlos del entorno.

Artefactos, razonamiento y ramas de conversación

LobeHub pone mucho foco en la experiencia avanzada con modelos:

Artifacts (tipo “Claude Artifacts”)

Permite que la IA genere y visualice en tiempo real:

- SVG dinámicos,

- páginas HTML interactivas,

- documentos y otros formatos.

Ideal para prototipos, visualizaciones, mini-interfaces o documentos generados sobre la marcha.

Chain of Thought (CoT) visual

LobeChat ofrece una visualización del razonamiento paso a paso, mostrando cómo el modelo llega a una conclusión. No es solo texto: es una forma de ver el proceso, útil para:

- comprender decisiones,

- depurar prompts,

- enseñar cómo “piensa” el modelo.

Conversaciones ramificadas

En vez de un chat lineal, LobeChat permite ramificar la conversación desde cualquier mensaje:

- Continuación: seguir en la misma línea, manteniendo contexto.

- Standalone: abrir una nueva rama independiente basada en un mensaje concreto.

Es literalmente un árbol de ideas, perfecto para explorar escenarios alternativos, iterar sobre versiones o comparar enfoques.

Multimodal: visión, voz e imágenes

LobeChat nace preparado para la IA multimodal:

- Reconocimiento visual: soporte para modelos tipo GPT-4-vision. Se pueden subir imágenes y pedir análisis, explicaciones o acciones basadas en su contenido.

- Texto a voz (TTS) y voz a texto (STT):

- Conversaciones por voz,

- respuestas leídas en voz alta,

- integración con motores como OpenAI Audio o Microsoft Edge Speech.

- Generación de imágenes:

- Invocación de herramientas tipo DALL·E 3, MidJourney o Pollinations desde el propio chat.

- Flujo de trabajo donde la creatividad visual se integra en la conversación.

Soporte para múltiples proveedores y modelos locales

A diferencia de muchas plataformas cerradas, LobeHub está diseñada para ser agnóstica de proveedor:

- Soporta varios servicios de modelos (OpenAI y otros), con intención de ampliar la lista.

- Permite usar modelos locales vía Ollama, para quienes quieren privacidad máxima o entornos sin salida a Internet.

Esto permite escenarios como:

- Un agente que use OpenAI para ciertas tareas y un modelo local para otras.

- Configuraciones optimizadas por coste, privacidad o rendimiento.

PWA, app de escritorio y experiencia cuidada

En el plano de experiencia de usuario, LobeHub ofrece:

- Aplicación de escritorio para usar el workspace sin depender del navegador, con rendimiento más estable.

- PWA (Progressive Web App): se puede instalar como “app” en escritorio y móvil desde el navegador, con aspecto casi nativo.

- Diseño muy trabajado, con temas claro/oscuro, personalización de colores y modos de visualización (tipo burbujas de chat o modo documento).

- Interfaz adaptada a dispositivos móviles, con iteraciones constantes para mejorar usabilidad.

Multiusuario, base de datos local o servidor y despliegue en 1 clic

A nivel de infraestructura, LobeHub está pensado tanto para el usuario individual como para equipos:

- Multiusuario, con integración con:

next-auth(OAuth, email, credenciales, etc.),- o Clerk, para quien necesita MFA, gestión avanzada de perfiles y auditoría.

- Soporte de base de datos local (con CRDT para sincronización multi-dispositivo en modo experimental)

o base de datos en servidor (PostgreSQL) para despliegues más serios.

Para desplegarlo, ofrece varias opciones:

- Vercel, Zeabur, Sealos, Alibaba Cloud, RepoCloud, con plantillas de “Deploy” en un clic.

- Docker, con un script de inicialización (

setup.sh) ydocker compose up -d. - Configuración por variables de entorno (API keys, lista de modelos, códigos de acceso, proxies, etc.).

En resumen, en pocos minutos se puede tener tu propio “ChatGPT privado” con soporte para múltiples modelos, plugins, agentes y datos propios.

Un ecosistema completo: plugins, UI, TTS/STT y herramientas satélite

Alrededor de LobeChat, el proyecto LobeHub mantiene varios paquetes y herramientas:

- @lobehub/ui: librería de componentes de interfaz para aplicaciones web de IA.

- @lobehub/icons: colección de logos y SVGs de modelos y marcas de IA/LLM.

- @lobehub/tts: librería de hooks React para TTS/STT de alta calidad.

- @lobehub/lint: configuraciones linting para proyectos del ecosistema.

- Un SDK de plugins, plantilla de plugins y un “gateway” desplegado en Vercel para facilitar el desarrollo y ejecución de plugins externos.

Conclusión: un candidato serio para montar tu propio “centro de control” de IA

LobeHub no es “otra interfaz más” para hablar con un modelo. Es un intento ambicioso de crear un espacio unificado para agentes de IA, donde:

- puedes elegir modelo,

- conectar herramientas,

- usar tu propio conocimiento,

- desplegarlo donde quieras,

- y compartir agentes con una comunidad activa.

Para desarrolladores, empresas y usuarios avanzados que quieren algo más que un simple chat en la nube, LobeChat se perfila como una de las opciones open source más completas del momento para montar un AI Agent Workspace moderno, extensible y bajo tu control.