En los últimos días se ha instalado un tono casi épico en redes: “hemos entrado en una nueva era”, proclaman algunos perfiles tecnológicos, convencidos de que ya es posible ejecutar “superinteligencia” en un ordenador de sobremesa, de forma privada y con costes cercanos a cero. El detonante de esa euforia tiene nombre propio: M2.5, un nuevo modelo de lenguaje presentado por MiniMax que llega con una ambición muy concreta: no competir solo en conversación, sino en productividad real, con especial foco en programación y agentes capaces de usar herramientas.

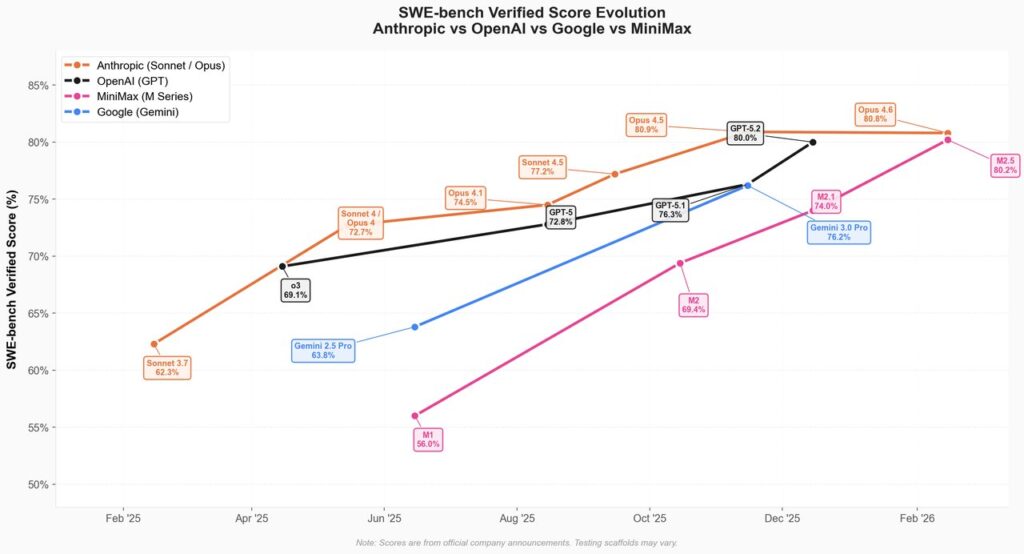

MiniMax define M2.5 como un “frontier model” orientado al trabajo práctico, y acompaña el lanzamiento con números que han llamado la atención por dos motivos: rendimiento y eficiencia. Según la compañía, el modelo alcanza un 80,2 % en SWE-Bench Verified (una métrica popular para evaluar resolución de incidencias reales de software), y destaca también en pruebas asociadas a navegación y herramientas, como BrowseComp (76,3) y BFCL para tool calling (76,8). En paralelo, el fabricante insiste en que la mejora no es únicamente de precisión: M2.5 habría completado la evaluación de SWE-Bench Verified un 37 % más rápido que la generación anterior (M2.1), situándose —en su relato— cerca del rendimiento temporal de modelos propietarios punteros.

Esa combinación de “más rápido” y “más barato” es la que alimenta la narrativa del “software factory”: agentes que trabajan sin descanso, detectan oportunidades o problemas (por ejemplo, rastreando foros y redes), plantean una solución y empujan un despliegue. La promesa suena futurista, pero la tecnología que lo hace plausible es bastante concreta: modelos entrenados para planificar, llamar a herramientas con fiabilidad y ejecutar tareas largas con coste controlado.

Del asistente al “arquitecto”: el giro hacia la planificación

Uno de los puntos más repetidos en la comunicación de MiniMax es que M2.5 no se limita a “escribir código”, sino que tiende a descomponer el problema y planificar antes de entrar en la implementación. La empresa describe una conducta de “spec-writing”: primero estructura, luego ejecución. También asegura que el modelo ha sido entrenado en más de 10 lenguajes y en más de 200.000 entornos reales, con la intención de cubrir un ciclo completo de desarrollo: diseño desde cero, puesta en marcha del entorno, iteración de funcionalidades, revisión y pruebas.

Este matiz es relevante porque conecta con el fenómeno de 2026: la IA deja de ser un generador de fragmentos sueltos y se convierte en un motor de trabajos encadenados. Ahí es donde cobran peso los benchmarks de agentes y tool calling. En la práctica, un agente útil no es el que “habla bonito”, sino el que: consulta una fuente, interpreta, decide, ejecuta un comando o una llamada a API y vuelve con un resultado verificable.

“Inteligencia barata” y el debate sobre el coste real

MiniMax acompaña el lanzamiento con un mensaje agresivo en precio: afirma que ejecutar el modelo de forma continua puede costar 1 dólar por hora a 100 tokens por segundo, y que a 50 tokens por segundo la cifra bajaría a 0,30 dólares por hora. Además, presenta dos variantes orientadas al uso en producción: una opción “estándar” optimizada para coste y otra “Lightning” optimizada para velocidad. Esta estrategia es la que ha llevado a algunos análisis a presentar M2.5 como una alternativa con economics muy competitivos frente a modelos cerrados.

Ahora bien, la misma conversación que impulsa el entusiasmo también introduce cautela: “gratis” no significa lo mismo en API que en despliegue local. En local entran factores inevitables —hardware, energía, refrigeración, mantenimiento— y, sobre todo, el tamaño y requisitos del propio modelo. MiniMax sí deja clara su intención de facilitar ese camino: la compañía indica que los pesos del modelo están publicados y recomienda vLLM o SGLang para desplegarlo con buen rendimiento, además de mencionar soporte para otros frameworks.

Abierto, sí; automático, no: lo que implica montar un “agente 24/7”

La idea de un sistema que “busca retos en X y Reddit, construye apps y las publica en producción” no depende solo del modelo. Requiere una arquitectura completa: conectores a fuentes, filtrado de calidad, verificación de información, control de seguridad, sandboxing, CI/CD, pruebas automatizadas, gestión de secretos y límites operativos para evitar que un error acabe “rompiendo” algo en público.

Lo que M2.5 aporta a esa visión es el componente que suele fallar antes: capacidad consistente para seguir un plan largo y usar herramientas sin desbordarse en coste o latencia. Aun así, la frontera práctica está en la ingeniería alrededor: un agente sin guardarraíles puede convertirse en un generador de deuda técnica a velocidad industrial.

No es casual que, en paralelo al anuncio, haya debate en comunidades técnicas. Algunos usuarios celebran el salto de rendimiento en benchmarks y el enfoque de eficiencia; otros recuerdan que el desempeño real depende mucho del “harness” (la forma de orquestar el agente), del tipo de tarea y del contexto del proyecto. El patrón se repite en cada salto generacional: los números abren la puerta, pero el uso diario decide el impacto.

Una señal del mercado: modelos abiertos que quieren ser “de producción”

Más allá del ruido, el lanzamiento de M2.5 refuerza una tendencia clara: los modelos abiertos ya no se conforman con ser “alternativas baratas”. Quieren ser la base de herramientas profesionales (IDE, refactorización, pruebas, agentes internos) y, sobre todo, habilitar despliegues privados donde el dato no salga de casa o del CPD.

Si MiniMax logra que esos números se traduzcan en fiabilidad real, la consecuencia es obvia: más equipos podrán plantearse automatizaciones avanzadas —incluida esa “fábrica de software” que hoy suena grandilocuente— sin depender de un único proveedor ni de costes imprevisibles. No será “magia gratis”, pero sí puede ser el siguiente paso hacia una IA más operativa y menos teatral.

Preguntas frecuentes

¿Qué significa que M2.5 sea un modelo “abierto” y se pueda desplegar en local?

Que MiniMax indica que publica los pesos del modelo y que permite despliegues privados (por ejemplo, en un clúster propio), sin depender exclusivamente de una API externa.

¿Qué es SWE-Bench Verified y por qué importa para herramientas de programación con IA?

Es una evaluación basada en incidencias reales de repositorios; la variante “Verified” busca validar que las soluciones funcionan. Un buen resultado sugiere capacidad para reparar o implementar cambios con criterios cercanos a producción.

¿Qué es el “tool calling” y por qué es clave para agentes autónomos 24/7?

Es la capacidad del modelo para invocar herramientas (APIs, navegadores, comandos, funciones) de forma estructurada y fiable. Es el ingrediente central para que un agente no solo responda, sino que actúe.

¿De verdad se puede montar una “fábrica autónoma de software” en un PC?

Se puede automatizar gran parte del pipeline, pero no depende solo del modelo: hace falta orquestación, pruebas, seguridad, control de costes y límites operativos. Sin esos elementos, el riesgo de errores y resultados poco fiables aumenta.

vía: Minimax X