La supremacía de OpenAI y Google en el terreno de la inteligencia artificial generativa enfrenta un nuevo desafío procedente de China. Sand AI ha presentado MAGI-1, un modelo de vídeo basado en IA que, según sus creadores, supera ampliamente en calidad y control a Sora, Gemini y otras soluciones comerciales.

Con un enfoque revolucionario y un rendimiento sobresaliente en tareas de generación de vídeo, MAGI-1 se perfila como un nuevo referente en el sector, además de apostar por la apertura del código, al liberar su modelo y herramientas en GitHub.

¿Qué es MAGI-1?

MAGI-1 es un modelo de difusión autoregresiva con 24.000 millones de parámetros, diseñado para generar vídeos de duración ilimitada a partir de imágenes o instrucciones textuales. A diferencia de otros modelos de IA que trabajan los vídeos de forma global, MAGI-1 genera los vídeos en fragmentos secuenciales de 24 fotogramas, asegurando una coherencia temporal superior y permitiendo transiciones fluidas y controladas entre escenas.

Cada fragmento es tratado como una unidad de trabajo: primero se elimina el ruido, y una vez estabilizado, se inicia el siguiente, posibilitando un procesamiento concurrente y una síntesis de vídeo en tiempo real ideal para aplicaciones de streaming.

Principales innovaciones de MAGI-1

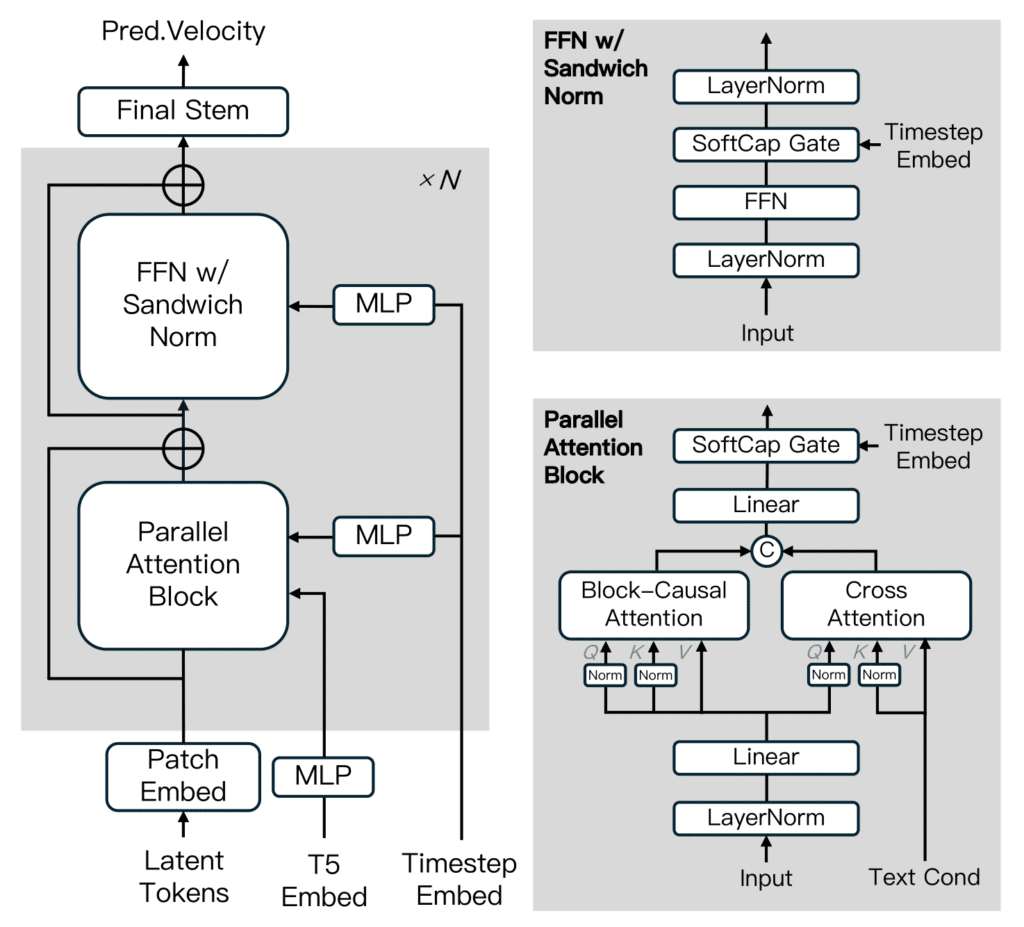

- Modelo de difusión basado en Transformer mejorado con técnicas como Block-Causal Attention, QK-Norm y Sandwich Normalization.

- Autoregresión de fragmentos: garantiza la continuidad temporal en vídeos de larga duración.

- Control de generación por fragmentos: permite definir eventos o narrativas distintas en diferentes partes del vídeo.

- Programación progresiva de ruido durante el entrenamiento, para fortalecer la consistencia causal.

- Inferencia optimizada: generación acelerada y eficiente sin sacrificar calidad visual.

¿En qué supera MAGI-1 a sus competidores?

En evaluaciones internas y comparativas, MAGI-1 ha mostrado:

- Mejor calidad de movimiento y mayor adherencia a instrucciones que modelos como Wan-2.1 y HunyuanVideo.

- Competencia directa con soluciones comerciales cerradas como Kling, Hailuo (i2v-01) y Sora, superándolas en varios parámetros de realismo de movimiento y control narrativo.

- Mejor rendimiento físico en tareas de continuación de vídeo, liderando las métricas del benchmark Physics-IQ en modelado de comportamientos físicos realistas.

En pruebas prácticas, MAGI-1 logra generar vídeos con una fluidez y coherencia temporal que, hasta ahora, solo estaba al alcance de los sistemas de IA más avanzados y cerrados.

Código abierto y ambición global

Una de las características más destacadas de MAGI-1 es su apuesta por el código abierto. Sand AI ha publicado en GitHub:

- Los pesos preentrenados de los modelos (MAGI-1-24B y una versión más ligera, MAGI-1-4.5B).

- El código de inferencia completo.

- Documentación técnica detallada y ejemplos de uso.

Esta estrategia democratiza el acceso a tecnologías de generación de vídeo avanzadas, permitiendo que desarrolladores, investigadores y empresas puedan experimentar, adaptar o integrar MAGI-1 en sus propios proyectos.

Una amenaza real para la hegemonía occidental en IA

Figuras destacadas del sector, como Kai-Fu Lee, director de Microsoft Research Asia, ya han reconocido el potencial disruptivo de MAGI-1. Al igual que ocurrió con DeepSeek en el ámbito del procesamiento de lenguaje natural, MAGI-1 podría marcar un antes y un después en la generación de vídeo mediante IA.

Frente a modelos cerrados como Sora (OpenAI) o Gemini (Google DeepMind), que mantienen su tecnología como un secreto comercial, MAGI-1 no solo compite en calidad, sino que abre la carrera tecnológica a un mayor número de actores.

Conclusión

El lanzamiento de MAGI-1 confirma que la competencia global en inteligencia artificial se está acelerando y diversificando. La calidad, flexibilidad y accesibilidad de este modelo chino de código abierto suponen una advertencia clara a los gigantes tecnológicos tradicionales: la innovación en IA no tiene fronteras.

MAGI-1 no es solo un modelo más; es el símbolo de una nueva etapa donde la generación de vídeo por IA combina realismo, control narrativo y democratización del acceso.

Referencias: diario amodei, TechCrunch, Hipertextual y código MAG-1 en GitHub.