La fiebre de los agentes personales de Inteligencia Artificial (IA) no solo se está librando en grandes suites empresariales. También se juega en el terreno que más rápido se mueve: el de las apps y utilidades que cualquiera puede instalar, probar y adaptar en cuestión de minutos. En ese contexto, nanobot se está haciendo un hueco con una promesa muy concreta: ser una alternativa ultraligera —y más fácil de entender— frente a asistentes de escritorio mucho más complejos inspirados por Clawdbot/OpenClaw.

Su carta de presentación es llamativa por lo que evita: nada de plataformas gigantescas, nada de dependencias interminables. El proyecto se define como “minimalista” y “hackeable”, y presume de un núcleo de aprox. 3.510 líneas de código, una cifra que, en la práctica, busca transmitir una idea sencilla: menos complejidad, más control.

Un asistente que se siente como una app: chat primero, automatización después

Nanobot se mueve en la frontera entre herramienta de terminal y “app” de mensajería. En lugar de obligar al usuario a entrar siempre en una interfaz concreta, el proyecto facilita que el asistente viva donde ya está la gente: en canales de chat.

Según su documentación, el bot puede conectarse a múltiples plataformas (con diferentes niveles de complejidad de configuración). Entre los canales mencionados aparecen Telegram (recomendado), además de integraciones añadidas recientemente como Slack y Email, junto con otras opciones de mensajería. El resultado es un asistente “siempre disponible”, capaz de responder y ejecutar tareas desde el mismo flujo de conversación.

En un mercado saturado de “apps de IA” que se limitan a ser un chat bonito, aquí el objetivo es otro: convertir el chat en el panel de control de un agente, sin que por ello el sistema se vuelva incontrolable.

Compatible con varios modelos: del proveedor comercial al modelo local

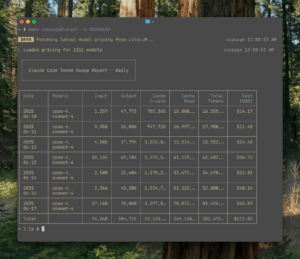

Otro punto que empuja a nanobot al radar de medios de apps es su enfoque “multi-proveedor”. El proyecto declara compatibilidad con OpenAI, Anthropic y DeepSeek, y también contempla pasarelas como OpenRouter. Esto permite cambiar de modelo sin rehacer toda la herramienta, algo relevante para usuarios que alternan entre calidad, precio, latencia o disponibilidad.

Más interesante todavía para el mundo de apps y productividad: soporta modelos locales mediante vLLM o servidores compatibles con APIs tipo OpenAI. Es decir, la misma “app” puede funcionar tanto con un modelo remoto como con uno que el usuario ejecute en su propio equipo o servidor. Para quienes buscan privacidad, costes controlados o independencia, este detalle no es menor.

Instalación “de app”: rápido, repetible y sin drama

Nanobot intenta bajar la fricción de entrada con tres vías de instalación típicas del ecosistema Python:

- Instalación desde el repositorio (orientada a desarrollo).

- Instalación con

uv(enfocada a rapidez y estabilidad). - Instalación desde PyPI con

pip(la más estándar).

El flujo de arranque descrito es el clásico de una app moderna: inicializar configuración, definir proveedor/modelo en un JSON y empezar a chatear. No es un detalle menor: en la carrera de agentes personales, gana quien reduce el tiempo entre “lo vi en redes” y “lo tengo funcionando”.

Lo que de verdad importa: controles y límites

Los agentes personales dan vértigo por una razón: si tienen acceso a demasiadas cosas, un error o un mal diseño puede convertirse en un problema serio. En ese punto, nanobot destaca en su configuración opciones pensadas para poner límites claros.

Una de las más relevantes es restringir el alcance del asistente a un “workspace” (una carpeta de trabajo). En la práctica, significa que herramientas internas como lectura/escritura o comandos quedan acotados a un directorio concreto, reduciendo el riesgo de que el bot “salga” a rutas no autorizadas.

Además, el proyecto contempla controles por canal, como listas de usuarios permitidos para interactuar con el bot. Es una idea simple: si el asistente está en una app de mensajería, se necesita un mecanismo fácil para evitar que cualquiera pueda hablarle.

¿Es esto una garantía absoluta? No. Pero en un mundo donde muchos agentes se venden con promesas vagas de “seguridad”, resulta significativo que la conversación gire hacia controles configurables y verificables.

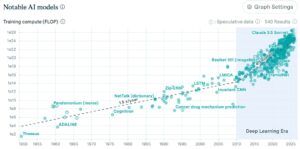

Un síntoma del momento: agentes más pequeños para una adopción más realista

Nanobot no intenta ganar por fuerza bruta. Su enfoque sugiere otra tendencia: para que los agentes lleguen a más gente, tendrán que ser más simples de desplegar, más fáciles de auditar y menos exigentes en recursos.

En el terreno de las apps de IA, eso encaja con una demanda muy concreta: herramientas que funcionen “ya”, sin convertir cada prueba en un proyecto de ingeniería. Si un asistente puede hablar por Telegram, trabajar con un modelo local o remoto y mantenerse dentro de límites claros, la propuesta deja de ser una demo y se acerca a un uso cotidiano.

Preguntas frecuentes

¿Qué tiene nanobot para considerarlo una “app” de IA y no solo un bot de terminal?

Porque puede integrarse con canales de chat (como Telegram) y funcionar como asistente accesible desde cualquier dispositivo, manteniendo un flujo de conversación como interfaz principal.

¿Se puede usar nanobot con modelos locales para mayor privacidad?

Sí. El proyecto indica soporte para modelos locales vía vLLM (u otros servidores compatibles), lo que permite ejecutar el asistente sin depender necesariamente de un proveedor externo.

¿Qué significa “restringir al workspace” y por qué es importante?

Es una opción de configuración para limitar herramientas del agente (archivos, comandos, etc.) a una carpeta concreta. Ayuda a reducir el riesgo de acceso accidental o no deseado a otras rutas del sistema.

¿Para quién tiene más sentido: usuarios finales o equipos de producto?

Para ambos: usuarios avanzados que quieren un asistente controlable y equipos que buscan una base pequeña y legible sobre la que construir una app de productividad con IA sin arrastrar una plataforma enorme.