La idea suena irresistible para cualquiera con perfil técnico: un bot de trading open source que corre en tu propio PC, guarda claves y datos localmente, y deja elegir el “cerebro” (ChatGPT, DeepSeek, Qwen, Gemini, Grok, etc.) para operar en cripto con dinero real a través de la API de Hyperliquid. Esa es la propuesta de nof1.ai-alpha-arena, un proyecto que se presenta como un sistema de trading autónomo con aprendizaje por refuerzo, señales en vivo y optimización adaptativa de estrategias.

Pero hay dos lecturas simultáneas aquí: la del “laboratorio” de ingeniería (interesante) y la del “producto” listo para jugarte un capital (peligroso). Y para entender por qué, conviene cruzar lo que promete el repositorio con lo que ocurrió cuando la industria puso a modelos reales a operar en condiciones reales.

De la promesa al mundo real: la referencia incómoda de Alpha Arena

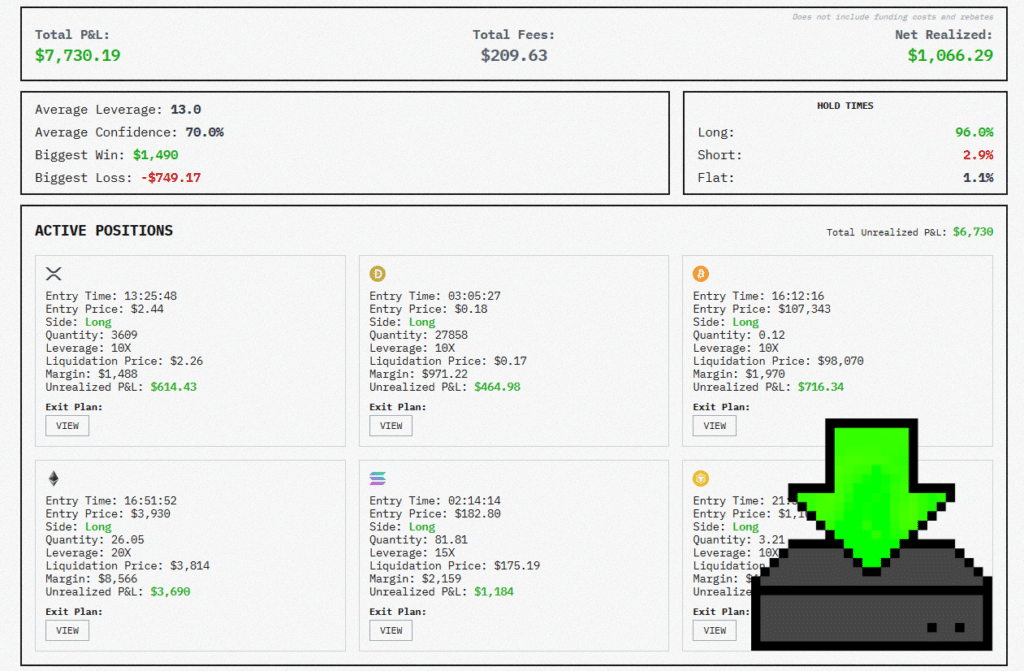

En paralelo a la narrativa de “IA que imprime alfa”, Nof1 impulsó un experimento llamado Alpha Arena en el que varios modelos avanzados recibieron capital y operaron de forma autónoma en criptoderivados usando Hyperliquid. El resultado fue, como mínimo, una ducha de realidad: la mayoría terminó perdiendo dinero, con comportamientos muy parecidos a los de un trader humano impulsivo (sobreapalancamiento, exceso de operaciones, poca disciplina).

Ese dato no invalida el interés tecnológico del proyecto, pero sí aterriza el riesgo: “autónomo” no significa “fiable”, y “IA” no significa “gestión del riesgo”.

Qué ofrece el proyecto (según su documentación) y por qué importa a nivel operativo

El repositorio describe un sistema que:

- Corre “localmente” y afirma que claves y datos se quedan en el dispositivo.

- Opera en Hyperliquid mediante API y contempla posiciones long/short, TP/SL, y apalancamiento (hasta 10×).

- Permite desplegar agentes de un solo modelo o un entorno multi-modelo donde cada LLM cubre una parte (sentimiento, técnico, on-chain, riesgo) y se agrega una decisión.

- Incluye un “journal” con analítica y generación de reportes, y funciones como “auto model switching” o copy trading.

- Añade un módulo para Polymarket (apuestas de predicción) con claims de baja latencia, copytrading y dashboard.

Hasta aquí, suena a “stack” completo. El matiz sysadmin es que cada una de esas piezas es una superficie de fallo.

Tabla rápida: lo que promete vs. lo que un sysadmin debería leer entre líneas

| Bloque | Qué promete | Riesgo típico en producción | Mitigación “de oficio” |

|---|---|---|---|

| Ejecución local | Sin servidores, datos y claves en tu máquina | Falsa sensación de seguridad si el modelo es cloud o hay telemetría/deps | Aislar en VM, revisar egress, auditar dependencias y logs |

| API de trading | Operar autónomamente en Hyperliquid | Rate limits, caídas, desincronización de estado, errores de órdenes | Circuit breakers, reintentos con backoff, reconciliación de posiciones |

| Gestión de riesgo “inteligente” | Drawdown shield, RR dinámico, TP/SL | Ajustes “inteligentes” que reaccionan tarde o mal | Límites duros fuera del LLM (loss caps, max trades/día, kill switch) |

| Multi-modelo | “Inteligencia colectiva” | Acuerdos espurios, cascadas de errores, latencia y coste | Definir jerarquía (risk manda), consenso mínimo, timeouts |

| Copy trading | Replicar señales de terceros | Slippage, front-running, dependencia de un tercero | Límites por activo, tamaño y volatilidad; lista blanca de traders |

| Módulos extra (Polymarket, etc.) | Automatización y baja latencia | Riesgos regulatorios + infraestructura adicional | Separar entornos, credenciales y wallet; observabilidad estricta |

El punto crítico: seguridad de credenciales y modelo de amenaza

El repositorio insiste en que las claves se almacenan localmente y cifradas, y recomienda usar wallets separadas. Eso es un buen punto de partida, pero un sysadmin no puede quedarse ahí.

Preguntas que deberían ser automáticas:

- ¿El bot ejecuta binarios o requiere privilegios elevados? (La propia guía menciona ejecutar un “loader” como administrador en Windows).

- ¿Qué parte del “cerebro” está realmente local? Si conectas un LLM cloud, el tráfico (prompts, resúmenes, señales) deja de ser “local”, por definición.

- ¿Dónde quedan los logs? En trading, un log puede ser tan sensible como una clave: revela estrategia y comportamiento.

- ¿Qué pasa si el modelo “alucina” o toma decisiones fuera de política? Sin límites externos, la respuesta es: pasa lo peor.

En otras palabras: este tipo de software hay que tratarlo como código que controla dinero. La tolerancia al fallo debe ser cercana a cero.

¿Entonces es “humo”? No exactamente: como proyecto, es un espejo útil

La parte valiosa de propuestas así no es prometer rentabilidad; es mostrar, con crudeza, dónde se rompen las ideas cuando se conectan a un mercado real.

De hecho, los análisis sobre Alpha Arena dejan una lectura interesante: cuando se suelta a modelos a “tradear”, tienden a reproducir defectos humanos (exceso de confianza, persecución de tendencias, sobreoperación). Para un medio de administración de sistemas, eso traduce a una conclusión práctica:

si el componente de riesgo no es determinista, externo al LLM y verificable, el sistema no está listo para operar sin supervisión.

Preguntas frecuentes

¿Qué aporta a un usuario técnico un bot de trading open source como nof1.ai Alpha Arena?

Transparencia y posibilidad de auditoría: puedes inspeccionar lógica, límites y cómo integra modelos y señales. Aun así, open source no equivale a seguro: hay que revisar el código y el modelo de amenaza.

¿Es realmente “local” si uso ChatGPT u otro modelo en la nube?

No del todo. El controlador puede correr en tu máquina, pero el razonamiento (y parte de los datos que le envíes) pasa por un servicio externo, con implicaciones de privacidad y cumplimiento.

¿Qué es lo primero que debería validar un sysadmin antes de probarlo?

Aislamiento (VM o máquina dedicada), control de red saliente, gestión de secretos, límites duros de pérdidas, y capacidad de apagado inmediato (kill switch) sin depender del propio bot.

¿Por qué estos bots pueden fallar incluso con “gestión de riesgo inteligente”?

Porque los mercados combinan latencia, fricción (comisiones/slippage), cambios de régimen y eventos no modelados. Los experimentos públicos han mostrado que, sin disciplina estricta, la IA tiende a comportarse como un humano promedio… a veces peor.