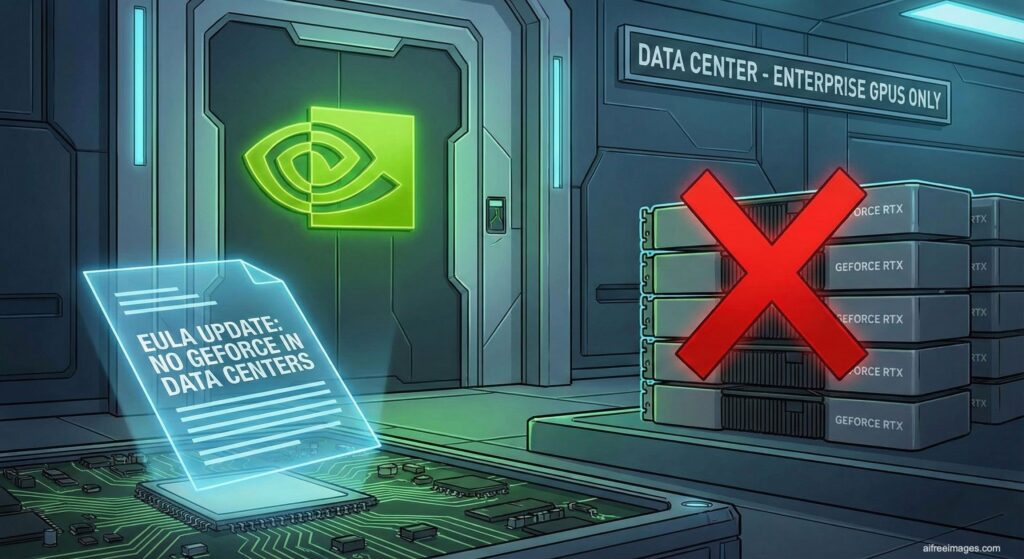

NVIDIA ha introducido un cambio clave en la licencia de uso de los drivers que dan servicio a sus tarjetas gráficas GeForce y Titan, y el impacto se nota especialmente en el mundo de la inteligencia artificial. A partir de ahora, el software que permite utilizar estas GPUs no está licenciado para despliegues en centros de datos, con la única excepción explícita del blockchain processing.

En otras palabras: las gráficas “de consumo” que muchos laboratorios, startups y equipos de IA habían utilizado como base de sus clústeres dejan de ser, sobre el papel, una opción aceptable en entornos de CPD.

Un cambio de licencia con mensaje: GeForce sí, pero no en tu clúster de IA

La nueva redacción del acuerdo de licencia (EULA) para los drivers de GeForce y Titan incluye una cláusula contundente:

“No Datacenter Deployment. The software is not licensed for datacenter deployment, except that blockchain processing in a datacenter is permitted.”

El texto no deja demasiado margen a la interpretación: el driver no puede usarse en despliegues de centro de datos. NVIDIA aclara, eso sí, que no pretende perseguir a investigadores individuales o pequeños grupos que utilicen estas tarjetas para trabajos de prueba o investigación “no a escala de datacenter”. Pero esa matización se hace en declaraciones públicas, no en la letra del contrato.

Oficialmente, la compañía defiende el cambio alegando que GeForce y Titan:

- No se diseñaron para la complejidad de un CPD (racks densos, 24/7, grandes cargas térmicas).

- No están pensadas como solución para entornos empresariales masivos, sino para PCs individuales y estaciones de trabajo ligeras.

Sin embargo, en el ecosistema de IA muchos leen este movimiento sobre todo como una forma de reforzar la segmentación entre las GPUs de consumo y la gama profesional para centros de datos.

El objetivo real: empujar a la IA hacia la gama profesional de NVIDIA

El momento y la redacción del cambio no parecen casuales. Durante años, investigadores y empresas han recurrido a GPUs GeForce “gaming” para montar nodos de entrenamiento e inferencia de modelos de IA:

- Misma arquitectura básica que las gamas profesionales.

- Un ecosistema CUDA y cuDNN idéntico a nivel de software.

- Coste muy inferior al de las tarjetas Tesla o RTX para data center.

Con la prohibición explícita de uso en CPD, NVIDIA envía un mensaje claro al mercado de IA empresarial: si el proyecto es serio y corre en racks, la opción “correcta” son las GPUs de gama data center, no las de consumo.

La compañía ya domina el mercado de aceleradores de IA gracias a su combinación de hardware, CUDA, librerías optimizadas y un ecosistema maduro. Limitar contractualmente el uso de GeForce en centros de datos reduce vías de “ahorro creativo” para quienes intentaban competir con menos presupuesto.

El impacto en la práctica: de los laboratorios de IA a las pequeñas nubes GPU

El cambio de EULA afecta de forma desigual según el perfil:

- Startups de IA y pequeños proveedores de GPU en la nube que ofrecen instancias con GeForce en lugar de GPUs profesionales.

- Empresas que montaron granjas internas para entrenamiento de modelos, RAG o inferencia usando RTX de consumo para recortar CAPEX.

- Laboratorios y grupos de investigación que comparten una pequeña granja GPU en un CPD institucional.

En todos estos escenarios, seguir usando GEForce en un centro de datos supone estar fuera de los términos de la licencia del driver. Eso puede traducirse en:

- Pérdida de soporte oficial por parte de NVIDIA.

- Riesgos legales o contractuales en auditorías de cumplimiento de software.

- Problemas con clientes que exigen licencias en regla y documentación de compliance.

Para entornos de IA donde se trabaja con financiación pública, datos sensibles o acuerdos corporativos estrictos, ignorar la EULA deja de ser un detalle menor.

Zonas grises: Linux, investigación y “no es un CPD, es mi laboratorio”

La licencia incluye una excepción para software destinado exclusivamente a Linux o FreeBSD, que puede copiarse y redistribuirse si no se modifican los binarios. Pero eso no elimina la cláusula de “No Datacenter Deployment”: la excepción habla de redistribución, no de dónde se usa.

NVIDIA ha lanzado mensajes relativamente tranquilizadores para el mundo investigador:

- Dice no querer obstaculizar “usos no comerciales o de investigación que no operen a escala de datacenter”.

- En la práctica, muchos centros académicos podrían seguir utilizando GeForce en pequeños clústeres internos.

Aun así, el texto jurídico es explícito, y será cada institución quien deba decidir si considera su entorno como “datacenter” a efectos de licencia o como laboratorio controlado.

Opciones para el ecosistema de IA: pagar más, cambiar de proveedor o irse al cloud

Para quienes desarrollan y despliegan soluciones de IA, el menú de opciones se reorganiza:

- Subir de gama dentro de NVIDIA

- Migrar a GPUs Tesla/RTX data center, con drivers y soporte específicos para CPD.

- A cambio, más coste por tarjeta pero licencia alineada con el uso real.

- Explorar alternativas en hardware y software

- Soluciones de AMD con la plataforma ROCm, que intenta recuperar terreno en IA y HPC.

- Otros aceleradores emergentes orientados a IA, aunque sin el mismo ecosistema que CUDA.

- Apostar por nubes GPU de terceros

- Donde el cumplimiento de licencias recae en el proveedor cloud.

- Con la contrapartida de perder parte del control on-premise que muchos buscan precisamente para IA privada o soberana.

Para proyectos de IA que quieren mantenerse locales, privados y bajo control directo, el movimiento de NVIDIA encarece la entrada y obliga a hacer números de nuevo.

Un recordatorio de la concentración de poder en la IA

Más allá de la letra del contrato, esta actualización de la EULA vuelve a poner sobre la mesa un debate incómodo para el sector: hasta qué punto el futuro de la IA depende de las decisiones comerciales de unos pocos proveedores de hardware.

Cuando el mismo actor controla:

- El hardware dominante para entrenamiento e inferencia.

- El stack de software (CUDA, cuDNN, librerías, tooling).

- Y ahora, vía licencia, marca qué usos son “legítimos” y cuáles no,

cada ajuste contractual reconfigura el ecosistema: quién puede entrenar modelos a bajo coste, quién puede ofrecer nubes GPU independientes, quién puede competir en servicios de IA y quién queda fuera por pura barrera económica.

Para los medios y observadores de IA, el movimiento de NVIDIA no es solo una nota legal: es un indicador de cómo se está consolidando el poder en la infraestructura que sostiene la inteligencia artificial actual. Y también un aviso de que la discusión sobre competencia, regulaciones y alternativas abiertas en hardware de IA será tan relevante como la de modelos, agentes o algoritmos.