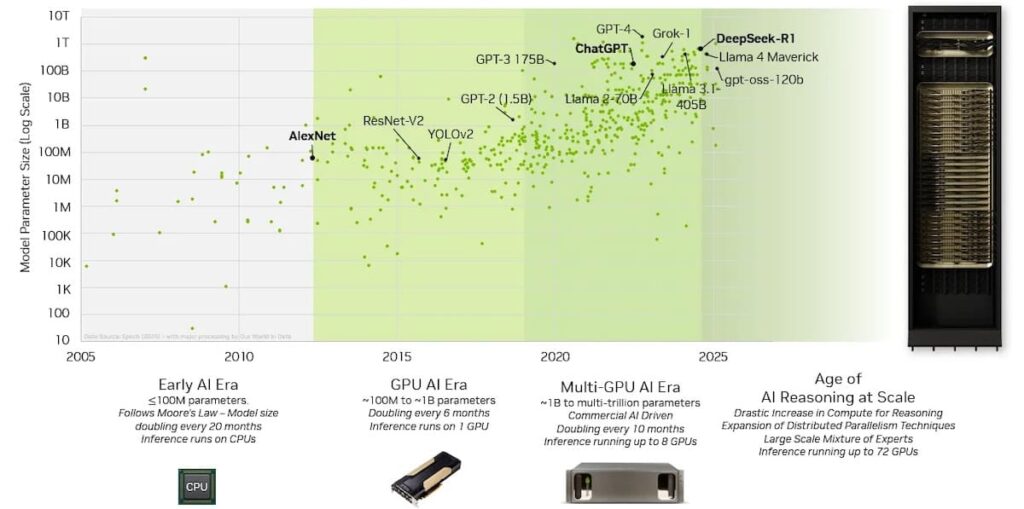

La carrera por escalar la inteligencia artificial ha llevado a la industria tecnológica a un punto crítico: los modelos ya no cuentan con millones de parámetros, ni siquiera con miles de millones. Hoy hablamos de billones de parámetros, arquitecturas mixture-of-experts (MoE) y razonamiento de IA con test-time scaling, lo que multiplica de forma exponencial las necesidades de cómputo y de interconexión.

En este escenario, NVIDIA NVLink se ha convertido en el verdadero “sistema nervioso” de las fábricas de IA modernas. Y con la llegada de NVLink Fusion, la compañía abre la puerta a que hiperescaladores y fabricantes de chips puedan integrar esta tecnología en diseños semipersonalizados de infraestructuras, desde clusters de GPUs hasta sistemas híbridos con CPUs y XPUs a medida.

El objetivo es claro: crear dominios de cómputo masivos, donde cientos de GPUs y procesadores actúen como una sola entidad coherente en memoria y procesamiento, maximizando rendimiento, eficiencia y, en última instancia, ingresos para las llamadas AI factories.

De la GPU individual a la fábrica de IA

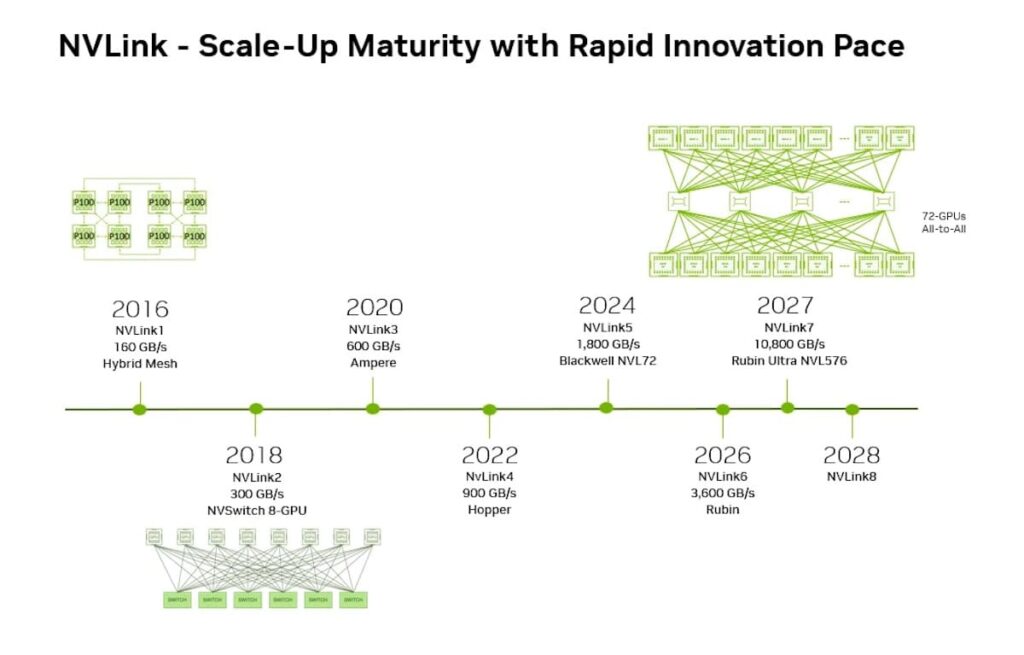

Un repaso a la evolución de NVLink muestra la rapidez del salto tecnológico:

- 2016: Nace NVLink para superar las limitaciones de PCIe, ofreciendo comunicación GPU-GPU más rápida y memoria unificada.

- 2018: Con la introducción de NVLink Switch, se alcanzan 300 GB/s en topologías de 8 GPUs.

- 2020-2023: Evolución hacia el uso en clústeres de cientos de GPUs, con integración de protocolos como SHARP para reducir latencia en operaciones colectivas.

- 2024: Llega la quinta generación de NVLink, soportando hasta 72 GPUs con comunicación all-to-all a 1.800 GB/s y un ancho de banda agregado de 130 TB/s.

Lo que comenzó como una alternativa a PCIe es hoy la base de los racks NVL72 de NVIDIA, diseñados específicamente para cargas de IA a gran escala.

El reto de la inferencia masiva

El entrenamiento de modelos LLM (Large Language Models) ya es una tarea titánica, pero la inferencia es el verdadero cuello de botella económico. Servir respuestas en tiempo real a cientos de millones de usuarios requiere sistemas optimizados al extremo, capaces de:

- Reducir la latencia (time-to-first-token).

- Aumentar el rendimiento por vatio.

- Maximizar la área bajo la curva Pareto: un equilibrio entre throughput y eficiencia energética que define la rentabilidad de una fábrica de IA.

Aquí es donde entra en juego NVLink. Un clúster con GPUs mal interconectadas pierde eficiencia, aunque disponga de potencia bruta. Los estudios internos de NVIDIA muestran que:

- En un mesh de 4 GPUs sin switch, el rendimiento se degrada por la división del ancho de banda.

- En una topología de 8 GPUs con NVLink Switch, se alcanza comunicación completa entre todos los nodos, mejorando de forma significativa el rendimiento.

- Al escalar a un dominio de 72 GPUs, el salto es exponencial: se maximiza el throughput, se reducen los costes por inferencia y se multiplica la rentabilidad.

NVLink Fusion: el gran salto hacia infraestructuras abiertas

Hasta ahora, el acceso a NVLink estaba limitado a las configuraciones estándar de NVIDIA. Con NVLink Fusion, la compañía cambia las reglas del juego al ofrecer acceso a todo el stack de NVLink a medida:

- SERDES y chiplets NVLink.

- Switches NVLink y topologías de rack-scale.

- Arquitectura Open Compute Project (OCP) MGX.

- Ecosistema de conectividad, potencia y refrigeración líquida.

Esto significa que hiperescaladores y grandes proveedores cloud podrán diseñar CPU personalizadas, XPUs híbridas o sistemas combinados, integrando NVLink directamente en sus arquitecturas.

UCIe y NVLink-C2C: interoperabilidad garantizada

Uno de los aspectos más relevantes de NVLink Fusion es su apuesta por estándares abiertos:

- Para XPUs personalizadas, NVIDIA ofrece un bridge chiplet que conecta UCIe (Universal Chiplet Interconnect Express) con NVLink, facilitando la integración de procesadores diseñados por terceros.

- Para CPUs personalizadas, se recomienda la integración de NVLink-C2C, que conecta directamente CPUs con GPUs NVIDIA, permitiendo acceso completo al ecosistema CUDA-X y sus miles de librerías optimizadas.

De esta forma, NVLink Fusion no cierra puertas: al contrario, habilita un ecosistema en el que distintos fabricantes pueden diseñar su propia visión de la IA a escala, sin perder compatibilidad con los estándares de NVIDIA.

Un ecosistema listo para producción

La promesa de NVLink Fusion no es teórica: NVIDIA asegura que la tecnología está lista para ser adoptada porque se apoya en un ecosistema probado:

- Los partners que ya construyen racks GB200 NVL72 y GB300 NVL72 están preparados para fabricar versiones personalizadas.

- La cadena de suministro incluye componentes de refrigeración líquida, potencia, cableado de cobre y fibra, y sistemas de gestión avanzada.

- El soporte de software es completo, gracias a librerías como NCCL (NVIDIA Collective Communication Library), que permiten optimizaciones automáticas en cualquier topología.

Implicaciones estratégicas para la industria

El impacto de NVLink Fusion va más allá de la tecnología:

- Para los hiperescaladores (AWS, Microsoft, Google, Meta): la posibilidad de diseñar infraestructuras semipersonalizadas con NVLink supone un control inédito sobre costes, eficiencia y escalabilidad.

- Para la soberanía digital: gobiernos y proyectos nacionales de IA podrán adoptar esta tecnología para construir superclústeres propios, sin depender únicamente de configuraciones estándar.

- Para la competencia: AMD y su ecosistema con Infinity Fabric o Broadcom/Cisco en interconexiones tendrán que acelerar para competir con la apertura parcial de NVIDIA.

El futuro: más allá de las 72 GPUs

NVIDIA no esconde que su hoja de ruta contempla un crecimiento aún más agresivo:

- NVLink 6, 7 y 8 ya están en desarrollo, con lanzamientos previstos en un ritmo anual.

- El objetivo es llegar a más de 1.000 GPUs en dominios de cómputo coherente, con anchos de banda del orden de los terabytes por segundo por acelerador.

- A largo plazo, se vislumbra un escenario donde varias fábricas de IA en distintos edificios puedan operar como un único superclúster global.

Conclusión

NVLink Fusion es, en esencia, la apuesta de NVIDIA por abrir su tecnología más estratégica, la que permite que miles de GPUs se comporten como un solo cerebro digital. Al hacerlo, habilita a hiperescaladores, gobiernos y grandes corporaciones a construir fábricas de IA adaptadas a sus necesidades, con la tranquilidad de contar con un ecosistema probado y una cadena de suministro lista para escalar.

En la era de la IA generativa y el razonamiento multimodal, donde cada milisegundo de latencia y cada vatio de energía cuentan, NVLink Fusion se convierte en el puente crítico entre el hardware personalizado y la promesa de la superinteligencia artificial a escala industrial.

Preguntas frecuentes (FAQ)

¿Qué es NVIDIA NVLink Fusion?

Es un programa que abre el acceso a la tecnología NVLink de NVIDIA (SERDES, chiplets, switches, racks NVL72) para que terceros puedan integrarla en CPUs y XPUs personalizadas y desplegar infraestructuras de IA a medida.

¿Qué ventajas ofrece frente a PCIe?

NVLink ofrece hasta 1,8 TB/s por GPU en comunicación bidireccional, frente a los 256 GB/s de PCIe Gen6, además de coherencia de memoria y escalabilidad a dominios de cientos de GPUs.

¿Cómo afecta a los hiperescaladores?

Les permite diseñar infraestructuras personalizadas con mayor control sobre costes y eficiencia, sin renunciar a la compatibilidad con CUDA y librerías de NVIDIA.

¿Es compatible con estándares abiertos?

Sí. NVLink Fusion utiliza UCIe para XPUs personalizadas y NVLink-C2C para CPUs, garantizando interoperabilidad y flexibilidad en la integración.

vía: developer.nvidia.com