NVIDIA ha convertido la Open Source AI Week en un escaparate de su estrategia para empujar la innovación en IA abierta: comunidad, herramientas y datos compartidos. En paralelo, refuerza su sintonía con PyTorch —el framework que más crece— al elevar Python a lenguaje de primera clase en CUDA, con el objetivo de que cualquier desarrollador pueda exprimir la GPU sin pelearse con la complejidad del bajo nivel. La compañía acompaña el mensaje con cifras de adopción, una agenda densa en la PyTorch Conference 2025 (San Francisco) y un catálogo creciente de repositorios, modelos y datasets abiertos.

La propuesta no es solo marketing: CUDA Python ya integra componentes pensados para que la aceleración en GPU sea más directa y productiva en entornos Python —desde fusión de kernels hasta integración de módulos de extensión y empaquetado simplificado—, y estrena nvmath-python, un puente nativo entre el código Python y bibliotecas de GPU muy optimizadas como cuBLAS, cuDNN o CUTLASS. El objetivo: que la ruta de “idea → prototipo → producción” sea más corta y, sobre todo, más predecible.

PyTorch + CUDA Python: bajar la barrera de entrada sin renunciar al rendimiento

Durante años, la productividad en IA ha orbitado alrededor de Python por su expresividad, su ecosistema y la velocidad con la que permite iterar. El peaje, históricamente, estaba en la frontera entre el mundo Python y la GPU: escribir kernels, compilar extensiones o gestionar dependencias era terreno especializado. Al incorporar Python como primera clase en la plataforma CUDA, NVIDIA intenta que lo habitual sea programar, probar y desplegar en el mismo idioma, con una capa de tooling que maneje detalles de empaquetado, compatibilidad y optimizaciones.

Ese cambio encaja con el modelo abierto de PyTorch. La comunidad —investigadores, startups y equipos de producto— quiere moverse rápido sin renunciar a la eficiencia de un backend maduro. La promesa de CUDA Python es precisamente esa: menos fricción para construir extensiones, mejor integración con el ecosistema y rendimiento a la altura cuando el proyecto cruza la pasarela hacia producción.

Las cifras que describen la tracción

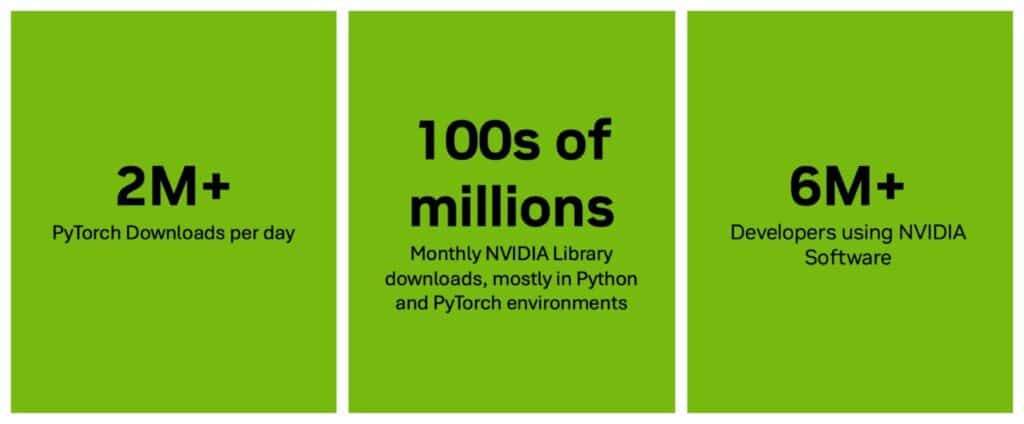

El pulso del ecosistema se mide también en descargas y uso real:

- PyTorch promedia más de 2 millones de descargas diarias en PyPI y alcanzó un pico de 2.303.217 el 14 de octubre. En el último mes sumó alrededor de 65 millones de descargas.

- Cada mes, los desarrolladores descargan cientos de millones de librerías de NVIDIA —CUDA, cuDNN, cuBLAS, CUTLASS, entre otras—, mayoritariamente dentro de entornos Python y PyTorch.

- NVIDIA presume de una base de más de 6 millones de desarrolladores usando su software.

En paralelo, la compañía amplía su oferta abierta: más de 1.000 herramientas open source en GitHub, más de 500 modelos y 100 datasets en sus colecciones de Hugging Face, y estatus de contribuyente destacado en repositorios de esa plataforma. La meta declarada: acelerar la reproducibilidad de la investigación y facilitar líneas base sólidas para productos que tengan que escalar.

nvmath-python: el eslabón que faltaba

Uno de los puntos finos de CUDA Python es nvmath-python, una librería que hace de puente entre el código Python y los núcleos matemáticos más optimizados de la plataforma. Traducido a impactos reales:

- Operaciones BLAS y convoluciones sin peaje extra por saltar del mundo Python a C/C++.

- Menos “pegamento” escrito a mano, menos riesgo de incompatibilidades de compilación y paquetes más sencillos de distribuir.

- Un camino más claro para fusión de kernels y optimización sin obligar al equipo a reescribir bloques enteros en otro lenguaje.

Para los equipos que construyen extensiones PyTorch o integran kernels a medida, esto supone menos tiempo en infraestructura y más tiempo en arquitectura de modelos y datos.

Open Source AI Week: hackathones, talleres y comunidad

La Open Source AI Week arranca con hackathones, workshops y meetups alrededor de lo último en IA y machine learning. La idea es reunir a organizaciones, grupos de investigación y comunidades para compartir prácticas, colaborar en herramientas y explorar cómo la apertura acelera el desarrollo. NVIDIA participa y patrocina, mantiene aportes a proyectos clave y, de paso, utiliza el evento para visibilizar herramientas, modelos y datasets propios con licencia abierta.

Nvidia en PyTorch Conference 2025: del keynote a los pósteres

La semana culmina en la PyTorch Conference 2025 (San Francisco), donde NVIDIA adelanta un keynote, cinco sesiones técnicas y nueve pósteres. El formato es relevante: PyTorch es, hoy, el idioma común de gran parte de la investigación y del stack de producto. Allí es donde se discute —y a menudo se decide— el futuro inmediato de runtimes, compiladores, kernels y frameworks de siguiente generación.

Por qué esto importa para desarrolladores y CTOs

- Velocidad de entrega. Si la aceleración GPU es más accesible en Python, los equipos pueden prototipar y llevar a producción con menos saltos mentales. Menos “context switching” implica menos bugs y time-to-market más corto.

- Estandarización. Que el tooling oficial simplifique empaquetado y extensiones reduce el número de caminos alternativos que cada empresa construye por su cuenta.

- Reutilización. Tener modelos y datasets abiertos de referencia acelera la fase de línea base y libera tiempo para lo diferencial.

- Talento. La IA abierta es, también, un canal de atracción: contribuir en repositorios visibles y trabajar con herramientas ampliamente usadas facilita la contratación y la comunidad alrededor de un producto.

Las preguntas incómodas que siguen abiertas

- Portabilidad y lock-in. CUDA Python acelera la ruta para quien está en CUDA; la comunidad seguirá mirando de cerca cómo se equilibra la compatibilidad con otros entornos y backends.

- Mantenibilidad. Un ecosistema con miles de repositorios y versionado rápido exige disciplina: breaking changes, compatibilidades de compiladores, toolchains y dependencias requieren buena gobernanza.

- Rendimiento vs. productividad. La promesa es que no haya que elegir; en práctica, cada proyecto tendrá que medir si la capa Python más amigable compite —o no— con el máximo rendimiento de un kernel a medida.

La lectura de fondo: abrir para ir más lejos

La apertura —código, modelos, datos— es un acelerador cuando se traduce en transparencia y reuso. No es casualidad que los picos de descargas y la actividad en Hugging Face se disparen cuando hay bases de calidad reutilizables. Para una industria con déficit de talento y presión por desplegar IA en producción, cada hora que se ahorra en infraestructura y cada bug que se evita por reusar bien acorta las curvas de entrega.

En ese marco, el movimiento de CUDA Python es coherente: subir a Python al centro de la historia, ofrecer puentes hacia las bibliotecas de GPU de alto rendimiento y pulir el ciclo de vida del paquete. Si la experiencia de desarrollo mejora y la comunidad empuja en la misma dirección, la consecuencia natural será más experimentos que llegan antes a producto.

Qué cabe esperar a corto plazo

- Más ejemplos y plantillas oficiales, especialmente para extensiones PyTorch y fusión de kernels.

- Rutas de despliegue más claras —contenedores, wheels— para reducir la fricción de entornos reproducibles.

- Colaboraciones con proyectos de siguiente generación que consoliden a CUDA Python como primera opción cuando el stack es Python y la GPU es el acelerador.

La Open Source AI Week funciona, así, como escaparate y como termómetro: cuánta comunidad se acopla, qué huecos persisten y dónde hay que invertir en tooling para que el “del cuaderno a producción” sea más mecánico que heroico.

Preguntas frecuentes

¿Qué es exactamente CUDA Python y qué ventaja aporta frente a escribir kernels a mano?

Es la incorporación de Python como lenguaje de primera clase en la plataforma CUDA, con tooling para fusión de kernels, extensiones y empaquetado más simple. La ventaja práctica es menos fricción y más productividad sin renunciar al rendimiento de las bibliotecas de GPU ya optimizadas.

¿Para qué sirve nvmath-python en proyectos con PyTorch?

Actúa como puente entre el código Python y núcleos matemáticos de alto rendimiento (por ejemplo, cuBLAS, cuDNN, CUTLASS). Esto reduce el “pegamento” artesanal, evita dolores de compilación y acorta el paso de prototipo a producción.

¿Qué datos ilustran el crecimiento de PyTorch y el uso del software de NVIDIA?

En el último mes, PyTorch superó los 65 millones de descargas en PyPI, con una media diaria por encima de 2 millones y un pico de 2.303.217. Cada mes se descargan cientos de millones de librerías de NVIDIA, sobre todo en entornos Python y PyTorch.

¿Cómo se traduce la “Open Source AI Week” en beneficios concretos para mi equipo?

En networking, acceso temprano a herramientas y ejemplos, y colaboración directa con mantenedores. En lo técnico, más plantillas y repositorios listos para usar, mejores rutas de despliegue y una curva de aprendizaje más corta para aprovechar la GPU desde Python.

vía: blogs.nvidia y Open Source AI Week