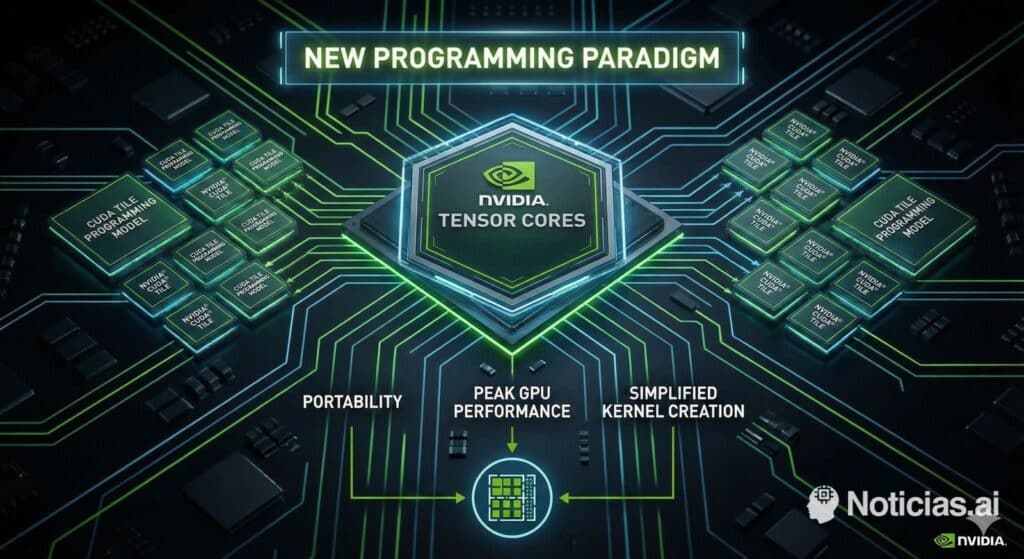

NVIDIA ha vuelto a mover ficha en el terreno donde más daño puede hacer a sus competidores: el software. Con CUDA 13.1 la compañía introduce CUDA Tile, un nuevo modelo de programación para GPU que rompe con casi dos décadas de forma “clásica” de escribir kernels. No se trata de una actualización menor, sino de un cambio de paradigma: en lugar de programar la GPU a bajo nivel, desarrollador a desarrollador, ahora se programan “tiles” o fragmentos lógicos de datos sobre los que el compilador decide cómo exprimir el hardware.

En plena carrera por liderar la inteligencia artificial, esta jugada refuerza de forma notable la posición de NVIDIA frente a China y Europa, que siguen intentando levantar ecosistemas alternativos de hardware y software sin una plataforma tan madura como CUDA.

De hilos y warps a tiles: un cambio de mentalidad

Hasta ahora, programar en CUDA significaba pensar en bloques, hilos, warps, memoria compartida e intrinsics. El desarrollador debía entender con bastante detalle cómo funcionaba la microarquitectura de la GPU para exprimir el rendimiento: cuántos hilos lanzar, cómo organizar los accesos a memoria, cuándo sincronizar, qué instrucciones especiales usar en Tensor Cores o unidades específicas.

CUDA Tile cambia las reglas del juego. En lugar de trabajar elemento a elemento, el programador define tiles, es decir, bloques coherentes de datos sobre los que se ejecutan operaciones.

La pieza clave es Tile IR, una representación intermedia que actúa como puente entre este modelo de alto nivel y el hardware real. El desarrollador describe el algoritmo a nivel de tiles; el compilador y el runtime deciden después:

- qué recursos activar (Tensor Cores, unidades de copia TMA, etc.);

- cómo distribuir los tiles entre los distintos SM;

- cómo mover los datos dentro de la jerarquía de memoria para minimizar latencias.

Es una capa de abstracción similar a lo que supusieron en su día DirectX o Vulkan para los gráficos, pero aplicada al mundo de la computación de propósito general y, especialmente, al entrenamiento e inferencia de modelos de IA.

Menos código “de fontanería”, más foco en el algoritmo

El impacto práctico para los desarrolladores es evidente. Muchos de los patrones de optimización tradicionales —gestionados a mano con bloques de hilos, registros y memoria compartida— pasan a ser responsabilidad del compilador.

Según la propia NVIDIA, la “programación basada en tiles permite especificar fragmentos de datos y las operaciones sobre ellos, sin tener que describir cómo se ejecuta el algoritmo elemento por elemento”. En la práctica, esto implica:

- Código más simple y legible, más cercano al pseudocódigo del algoritmo.

- Menos dependencia de una arquitectura concreta: el mismo kernel debería sobrevivir a varias generaciones de GPU.

- Ciclos de desarrollo más rápidos, porque se reduce el tiempo invertido en microoptimizar para cada chip.

Para facilitar la adopción, NVIDIA ofrece cuTile en Python, una implementación del modelo Tile integrada en su ecosistema. Los kernels se describen con sintaxis familiar para científicos de datos e investigadores, que podrán generar código altamente optimizado sin bajar al nivel de C++ y sin conocer al detalle la microarquitectura Blackwell.

Blackwell como primera piedra de una nueva generación

CUDA Tile llega acompañado de CUDA 13.1 y está pensado desde el inicio para las GPU Blackwell y Blackwell Ultra, la nueva familia de aceleradores de NVIDIA para centros de datos y “AI factories”. Estas arquitecturas se han diseñado con el modelo Tile en mente:

- El runtime puede decidir qué tiles se ejecutan en Tensor Cores u otras unidades especializadas.

- La gestión de la memoria interna y los caminos de datos se optimiza automáticamente en función del kernel.

- La planificación de trabajo se hace a un nivel más alto, lo que facilita que futuras generaciones refuercen la abstracción sin romper el código existente.

La compañía no esconde su objetivo: que el compilador tenga más peso que el programador en la optimización fina, igual que ocurrió en su día con los primeros frameworks de tensores. El resultado previsto es una década de kernels más portables, estables y fáciles de mantener.

Golpe estratégico para China y Europa

Más allá de lo puramente técnico, el movimiento tiene una fuerte lectura geopolítica. CUDA lleva años siendo el estándar de facto para IA y computación de alto rendimiento. Frente a él, iniciativas como ROCm (AMD), oneAPI/SYCL (Intel) o los ecosistemas que China intenta impulsar alrededor de sus propias GPU aún están lejos en madurez y adopción.

Con CUDA Tile, NVIDIA:

- Reduce la dependencia del desarrollador respecto al hardware concreto, lo que dificulta portar cargas de trabajo masivas a plataformas alternativas.

- Aumenta la productividad de los equipos que ya dominan el ecosistema CUDA, acortando tiempos de experimentación y despliegue de nuevos modelos.

- Revaloriza su base instalada de GPU, porque el software escrito hoy debería seguir funcionando y mejorando en futuras generaciones sin grandes cambios.

Para China, que ya sufre restricciones de exportación de GPUs avanzadas, supone ver cómo el líder del mercado vuelve a ampliar la distancia, no solo en hardware sino en herramientas de desarrollo. Y para Europa, que intenta construir estrategias de soberanía tecnológica y proyectos propios de hardware e IA, significa competir contra un ecosistema todavía más integrado y difícil de replicar.

¿Fin de la programación a bajo nivel?

La llegada de CUDA Tile no elimina el modelo tradicional de CUDA. Los desarrolladores que necesiten exprimir hasta el último ciclo de reloj seguirán pudiendo trabajar con hilos, bloques y memoria compartida a mano. Sin embargo, todo apunta a que:

- gran parte de las nuevas bibliotecas de alto nivel se construirán sobre Tile IR;

- el código “hand-tuned” quedará reservado a nichos muy especializados;

- la frontera entre “científico de datos” e “ingeniero de CUDA” se difuminará aún más.

En otras palabras, el futuro inmediato de la IA sobre GPU de NVIDIA se parecerá menos a escribir kernels a bajo nivel y más a describir operaciones sobre tiles de datos, dejando que el compilador haga el trabajo sucio.

Un futuro todavía más dependiente del software de NVIDIA

Con CUDA 13.1 y CUDA Tile, NVIDIA no solo presenta una mejora técnica: consolida una estrategia de largo recorrido donde el software es el verdadero foso defensivo frente a la competencia. Mientras otros fabricantes se esfuerzan por sacar chips competitivos, la compañía estadounidense refuerza la capa que más fideliza a la comunidad: el ecosistema de desarrollo.

El resultado es un escenario en el que países, empresas y centros de datos que ya han apostado por NVIDIA ven cómo su inversión se revaloriza, mientras que quienes intentan construir alternativas se enfrentan a un listón cada vez más alto.

Preguntas frecuentes

¿Qué es exactamente CUDA Tile?

CUDA Tile es un nuevo modelo de programación para GPU de NVIDIA basado en “tiles” o fragmentos de datos. El desarrollador define las operaciones sobre esos tiles y el compilador, a partir de Tile IR, se encarga de traducirlas al hardware, optimizando el uso de Tensor Cores y otras unidades especializadas.

¿En qué se diferencia CUDA Tile del CUDA “clásico”?

El CUDA tradicional obliga a pensar en hilos, bloques, warps y memoria compartida. CUDA Tile trabaja a un nivel más alto: se programan tiles de datos y el sistema decide cómo mapearlos a la GPU. Esto simplifica el código, mejora la portabilidad entre generaciones y reduce la necesidad de microoptimizar para cada arquitectura.

¿Qué impacto tiene CUDA Tile en la carrera por la inteligencia artificial?

Al facilitar el desarrollo de kernels eficientes y portables, CUDA Tile acelera el ritmo de innovación sobre GPU de NVIDIA. Esto refuerza su ventaja frente a ecosistemas alternativos menos maduros, especialmente en regiones como China o Europa que buscan independencia tecnológica pero carecen de una plataforma de software equivalente en alcance y adopción.

¿Seguirá siendo necesario programar a bajo nivel en CUDA?

Sí, seguirá siendo posible y útil en escenarios muy especializados donde cada ciclo cuenta. Sin embargo, todo apunta a que la mayoría de aplicaciones de IA y computación científica se construirán sobre CUDA Tile y sus herramientas asociadas, priorizando productividad, portabilidad y mantenimiento del código sobre la optimización manual extremo a extremo.

Fuentes:

NVIDIA Developer – CUDA Tile.

Documentación y materiales técnicos sobre CUDA 13.1 y Tile IR proporcionados por NVIDIA.