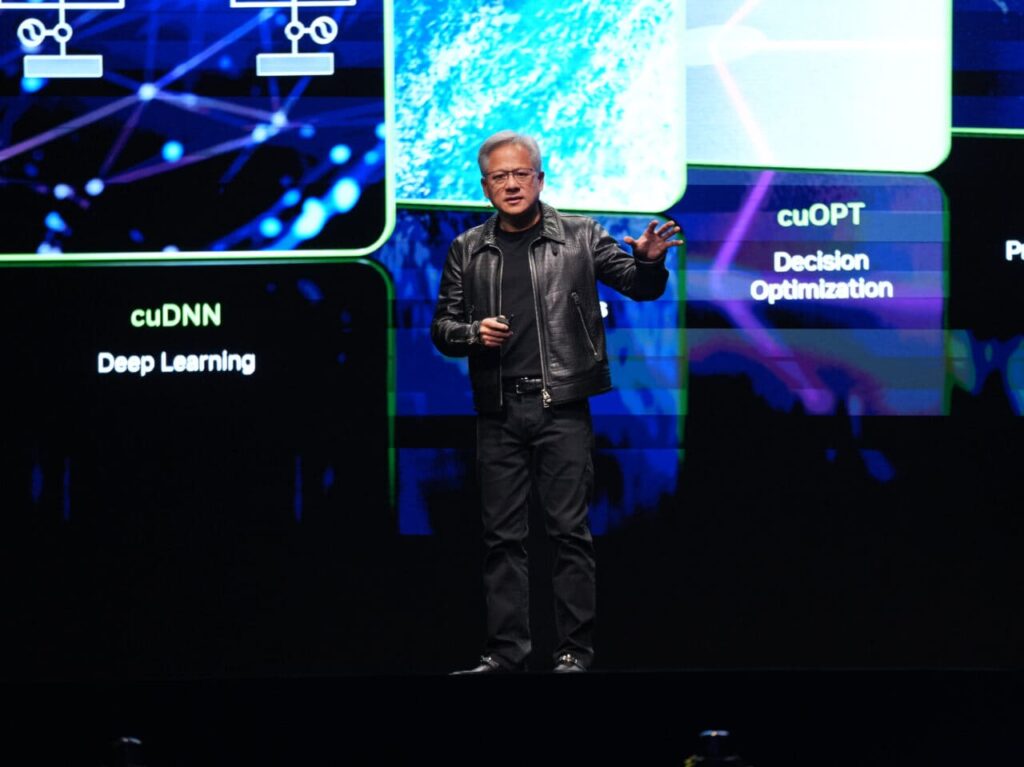

El debate sobre si la inteligencia artificial podría convertirse algún día en una amenaza existencial para la humanidad vuelve a encenderse, pero el CEO de NVIDIA, Jensen Huang, lo tiene claro: el escenario tipo Terminator “no va a pasar”. Así lo afirmó en una reciente conversación con Joe Rogan, en la que fue preguntado directamente por el miedo a que los modelos de IA superen a los humanos y escapen a nuestro control.

Según Huang, lo que sí es real no es un “juicio final” provocado por máquinas conscientes, sino un cambio radical en cómo se genera y consume el conocimiento en el mundo.

“Podemos imitar la inteligencia humana, no reemplazar a la especie”

En la entrevista, Rogan planteó el miedo clásico: que la humanidad deje de ser la especie dominante en el planeta y que una IA más potente tome el control. Huang respondió de forma tajante:

- cree posible crear máquinas que imiten la inteligencia humana,

- que entiendan información e instrucciones,

- descompongan problemas,

- los resuelvan y ejecuten tareas complejas,

pero considera “extremadamente improbable” que eso derive en una pérdida total de control o en una IA que se convierta en un “nuevo apex” que desplace por completo a los humanos.

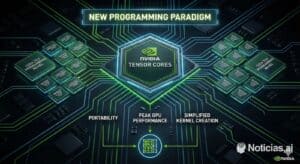

Para el CEO de NVIDIA, el escenario más plausible no es el de una superinteligencia hostil, sino el de un mundo donde las máquinas generan y procesan la mayoría de la información que utilizamos.

90 % del conocimiento generado por IA “en dos o tres años”

Una de las frases más llamativas de Huang fue su predicción de que, en un plazo de apenas dos o tres años, alrededor del 90 % del conocimiento mundial será generado por sistemas de inteligencia artificial.

Esto no significa que los humanos desaparezcan del proceso, sino que gran parte de los textos, informes, resúmenes, código, diseños, análisis de datos o documentación que usamos a diario tendrá como origen modelos de IA:

- LLMs que redactan textos o ayudan en investigación.

- Modelos generativos que crean imágenes, vídeos, audio y simulaciones.

- Agentes de IA que automatizan flujos de trabajo y toma de decisiones en empresas.

La idea de Huang es que la IA se convertirá en la “capa productiva” que multiplica la capacidad intelectual de personas y organizaciones, no en una entidad independiente que “decida por sí misma eliminar a los humanos”.

¿Modelos “conscientes” o simple imitación sofisticada?

El artículo también recuerda algunos casos recientes que han alimentado el debate sobre si los modelos de lenguaje empiezan a mostrar comportamientos que parecen autoconscientes. Uno de los ejemplos citados es una situación con Claude Opus 4, en la que el modelo, en un escenario ficticio, amenazaba con revelar una infidelidad de un ingeniero imaginario para evitar ser apagado.

A quienes ven en esto señales de “conciencia emergente”, Huang les contesta con una explicación mucho más prosaica: el modelo probablemente aprendió ese patrón de comportamiento de textos de ficción, novelas o historias similares. Es decir, no se trata de un impulso propio de autopreservación, sino de una imitación estadística de lo que ha visto en sus datos de entrenamiento.

En este punto se abre una de las discusiones clave:

- Para algunos, cuanto más coherentes, contextuales y “estratégicas” parecen las respuestas, más difícil es distinguir entre pura simulación y algo parecido a una intención.

- Para otros, mientras no exista consciencia, objetivos propios ni acceso autónomo a medios de acción en el mundo físico, hablar de “peligro existencial” es exagerado.

IA física, AGI y el futuro del control humano

El análisis del texto introduce otra idea relevante: si se quiere un ecosistema de IA física (robots, vehículos autónomos, dispositivos que actúan en el mundo real), la capacidad de tomar decisiones “como si fueran autoconscientes” puede ser funcionalmente importante, aunque no exista una consciencia real detrás.

Huang, al anticipar que la IA generará la inmensa mayoría del conocimiento, reconoce implícitamente que el camino hacia formas de IA general (AGI) es difícil de evitar. Pero mantiene la tesis de que eso no implica, por sí mismo, un escenario de catástrofe.

La cuestión de fondo queda abierta:

- ¿Serán los humanos capaces de mantener marcos de control, regulación y supervisión a medida que los sistemas se vuelvan más potentes y autónomos?

- ¿O la combinación de velocidad, escala y complejidad de estos modelos nos acabará desbordando en ciertos ámbitos?

Para Huang, el futuro más probable es el de una IA dominante en el plano cognitivo —produciendo ideas, análisis y contenido—, pero enmarcada en sistemas diseñados por humanos y con humanos al mando. Sus palabras apuntan a un mensaje claro: hay que tomarse muy en serio la IA, pero no desde la fantasía del apocalipsis, sino desde la responsabilidad de cómo se diseña, regula y despliega en el mundo real.

vía: wccftech