Ollama, la plataforma enfocada en ofrecer una experiencia simple para ejecutar modelos de lenguaje localmente, anunció que sus modelos en la nube ya están disponibles en versión preliminar. La novedad abre la puerta a correr modelos de gran tamaño —imposibles de alojar en un PC personal— con hardware de nivel datacenter, manteniendo la misma experiencia de uso que en local y, según la compañía, con la garantía de que los datos no se retienen para preservar la privacidad.

Modelos más grandes, sin límites de hardware personal

Hasta ahora, Ollama se había caracterizado por ejecutar modelos de lenguaje en máquinas locales. Pero la limitación evidente era el hardware de escritorio: GPUs limitadas en VRAM que no permiten trabajar con LLMs de cientos de miles de millones de parámetros.

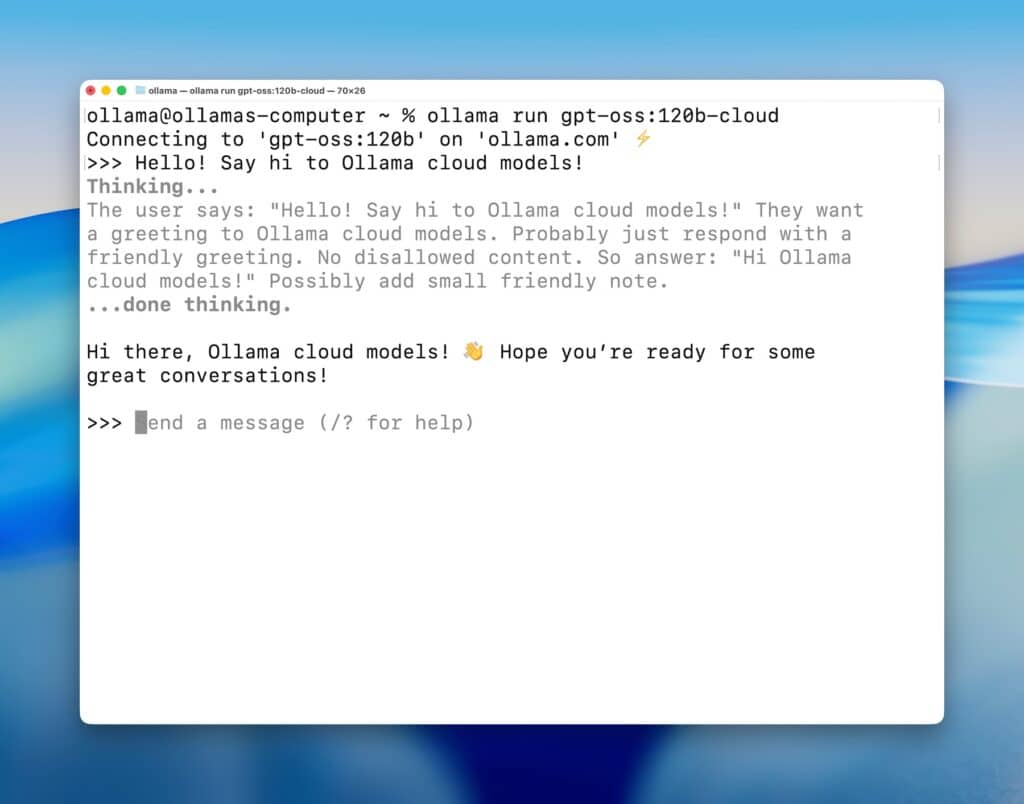

Con esta versión preliminar, los usuarios pueden desplegar modelos masivos en la nube de Ollama y seguir interactuando con ellos desde sus mismas herramientas locales. En otras palabras, se mantiene la simplicidad de Ollama CLI y su API OpenAI-compatible, pero con la potencia de clusters de GPU en datacenters.

Ejemplo de comando:

ollama run qwen3-coder:480b-cloud

Modelos disponibles en la nube

En esta primera etapa, Ollama ofrece algunos de los modelos abiertos más demandados en variantes cloud:

qwen3-coder:480b-cloudgpt-oss:120b-cloudgpt-oss:20b-clouddeepseek-v3.1:671b-cloud

La sintaxis y gestión son idénticas a los modelos locales: se pueden listar, ejecutar, descargar o copiar.

Ejemplo:

% ollama ls

NAME ID SIZE MODIFIED

gpt-oss:120b-cloud 569662207105 - 5 seconds ago

gpt-oss:20b-cloud 875e8e3a629a - 1 day ago

deepseek-v3.1:671-cloud d3749919e45f - 2 days ago

qwen3-coder:480b-cloud 11483b8f8765 - 2 days ago

Integración con la API de Ollama

Los modelos en la nube funcionan con la misma API que Ollama ya ofrece, compatible con librerías y SDKs de OpenAI.

Ejemplo en JavaScript

import ollama from "ollama";

const response = await ollama.chat({

model: "gpt-oss:120b-cloud",

messages: [{ role: "user", content: "Why is the sky blue?" }],

});

console.log(response.message.content);

Ejemplo en Python

import ollama

response = ollama.chat(model='gpt-oss:120b-cloud', messages=[

{

'role': 'user',

'content': 'Why is the sky blue?',

},

])

print(response['message']['content'])

Ejemplo en cURL

curl http://localhost:11434/api/chat -d '{

"model": "gpt-oss:120b-cloud",

"messages": [{

"role": "user",

"content": "Why is the sky blue?"

}],

"stream": false

}'

Privacidad y autenticación

Una de las claves del anuncio es que Ollama Cloud no almacena datos de los usuarios, alineándose con la filosofía de privacidad que diferencia a la plataforma frente a otros proveedores.

El acceso requiere autenticación:

ollama signin

Y para cerrar sesión:

ollama signout

Además, los modelos cloud pueden consumirse directamente vía API en ollama.com para integraciones en servidores o aplicaciones.

Qué significa este movimiento

Con esta jugada, Ollama se posiciona como un punto intermedio entre la experiencia ligera y controlada del despliegue local, y la potencia de modelos gigantes en la nube. Algunos análisis clave:

- Para desarrolladores: se elimina la limitación de VRAM de PCs personales sin necesidad de aprender a configurar entornos cloud complejos en AWS o GCP.

- Para empresas: permite experimentar con modelos open source de última generación en un entorno más escalable, pero sin sacrificar la privacidad de los datos.

- Para el ecosistema: compite directamente con soluciones híbridas como LM Studio + Hugging Face Inference, y se aproxima a la estrategia de OpenAI con GPTs en Azure, pero manteniendo su sello de simplicidad.

Conclusión

La llegada de los modelos en la nube de Ollama marca un paso natural en la evolución de la plataforma: mantener la experiencia local sencilla pero escalar sin límites de hardware.

Con soporte para modelos de cientos de miles de millones de parámetros y garantía de no retención de datos, Ollama busca atraer tanto a desarrolladores independientes como a empresas que quieren probar IA de frontera sin sacrificar la privacidad ni enfrentar la complejidad de los grandes proveedores cloud.

Preguntas frecuentes (FAQ)

¿Qué diferencia hay entre un modelo local y uno cloud en Ollama?

Los locales se ejecutan en tu propio hardware; los cloud usan GPUs de datacenter. La experiencia de comandos y API es idéntica.

¿Qué modelos cloud están disponibles actualmente?

Entre ellos: qwen3-coder:480b-cloud, gpt-oss:120b-cloud, gpt-oss:20b-cloud y deepseek-v3.1:671b-cloud.

¿Ollama guarda las conversaciones si uso la nube?

No. La compañía enfatiza que su infraestructura no retiene datos, reforzando la privacidad.

¿Puedo integrar los modelos cloud de Ollama en mis apps?

Sí. Se accede vía la API compatible con OpenAI, con SDKs en JavaScript, Python o directamente por cURL.

vía: ollama