OpenAI ha anunciado GPT-5.3-Codex-Spark, una versión preliminar de investigación pensada para un objetivo muy concreto: que la programación asistida por modelos sea realmente interactiva, con respuestas casi instantáneas y un flujo de trabajo que se parezca más a “editar en vivo” que a esperar a que termine una respuesta larga.

La novedad no es solo el modelo. El anuncio subraya un cambio de enfoque que muchos equipos de desarrollo llevan tiempo reclamando: en tareas de programación, la latencia importa tanto como la capacidad. No basta con “ser bueno”; hay que ser rápido en el primer token, estable en el streaming y predecible cuando el usuario interrumpe, corrige o pide un ajuste puntual.

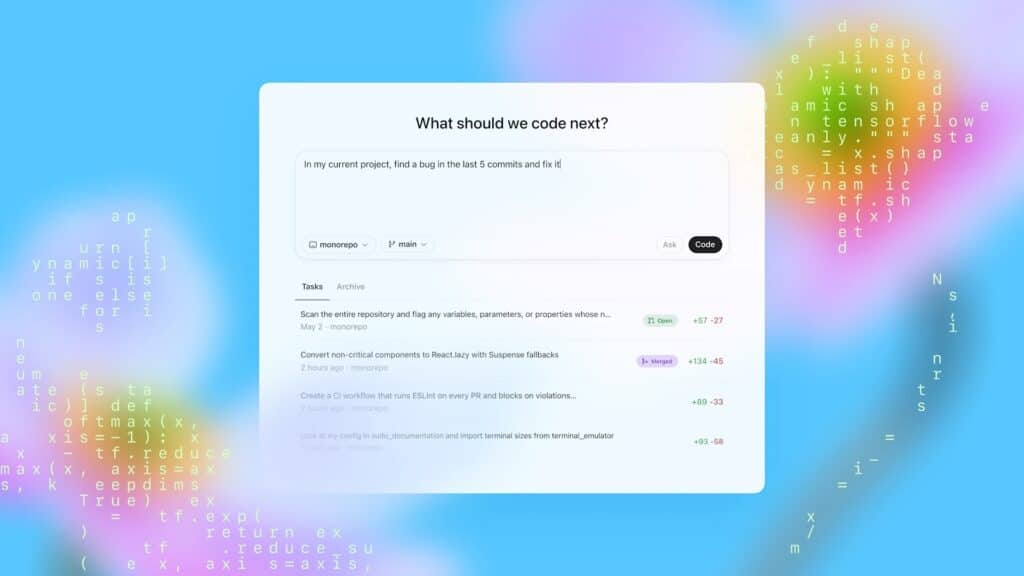

Un modelo ligero para “hacer cosas en el momento”

Según OpenAI, Codex-Spark es una variante más ligera de GPT-5.3-Codex y su primer modelo diseñado específicamente para programación en tiempo real. La idea es que funcione bien en iteraciones rápidas: ediciones mínimas, cambios quirúrgicos de lógica, retoques de interfaces o refactors parciales que se revisan al vuelo.

En esta fase, el modelo es solo texto y se lanzará con una ventana de contexto de 128.000 tokens, un tamaño pensado para trabajar con repositorios medianos, módulos completos o conversaciones largas de debugging sin perder el hilo. También se indica que, por defecto, no ejecuta pruebas automáticamente salvo que el usuario se lo pida, priorizando la reactividad sobre la “autonomía total” en cada acción.

Lo decisivo: mejoras de latencia de extremo a extremo

OpenAI afirma que, durante el entrenamiento y la puesta a punto de Codex-Spark, descubrieron que la velocidad del modelo era solo una parte del problema: también había que recortar la latencia de infraestructura que rodea a cada petición.

En su entorno de pruebas, la compañía detalla tres recortes concretos:

- 80% menos sobrecarga por viaje cliente/servidor

- 30% menos sobrecarga por token

- 50% menos tiempo hasta el primer token (time-to-first-token)

Para ello, mencionan optimizaciones en el flujo de respuestas entre cliente y servidor, cambios en partes clave de la infraestructura de inferencia y ajustes en la inicialización de sesiones. Además, destacan el uso de una conexión WebSocket persistente y optimizaciones en la API de Responses, con la intención de que esta ruta acabe siendo la opción estándar para más modelos.

Dicho de forma simple: Codex-Spark no solo “contesta rápido”; intenta que la experiencia completa —desde que se pulsa Enter hasta que el primer token aparece— sea más parecida a un IDE reaccionando que a una petición web tradicional.

Impulsado por Cerebras (sin abandonar las GPU)

El otro gran titular es la infraestructura: OpenAI explica que Codex-Spark se ejecuta en el Wafer-Scale Engine 3 (WSE-3) de Cerebras, orientado a inferencia de alta velocidad y baja latencia. El mensaje oficial es claro: las GPU siguen siendo fundamentales por coste/eficiencia a gran escala, pero Cerebras actúa como un complemento especialmente fuerte cuando el cuello de botella es la latencia.

La compañía enmarca este movimiento como “el primer gran momento” de su asociación con Cerebras, anunciada previamente, y lo presenta como una forma de añadir un “camino de baja latencia” dentro de la misma infraestructura de producción de Codex.

En paralelo, Cerebras lleva tiempo defendiendo su apuesta por un único chip a escala de oblea. En documentación del propio fabricante, el WSE-3 se describe con cifras muy llamativas para memoria y ancho de banda: 4 billones (trillion) de transistores, 900.000 núcleos, 44 GB de memoria on-chip y 21 PB/s de ancho de banda de memoria, entre otros datos técnicos. En la práctica, ese tipo de diseño busca reducir movimientos de datos y penalizaciones típicas de arquitecturas distribuidas cuando lo que se persigue es una respuesta inmediata.

Disponibilidad: primero para ChatGPT Pro y herramientas de Codex

Codex-Spark se lanza como vista previa de investigación para usuarios de ChatGPT Pro, integrado en las versiones recientes de la app de Codex, la CLI y la extensión de VS Code. OpenAI también indica que lo habilita vía API para un grupo reducido de socios, con la idea de observar integraciones reales y ampliar el acceso en las semanas siguientes.

Durante la vista previa, su uso tiene límites de uso y rate limit propios (separados de los límites estándar), y en picos de demanda puede haber colas o acceso limitado para mantener estabilidad.

Qué significa esto para equipos de desarrollo

Más allá del lanzamiento, Codex-Spark apunta a una tendencia: la programación asistida por Inteligencia Artificial se está dividiendo en dos modos complementarios.

- Modo “largo”: tareas complejas, agentes que trabajan durante horas, exploración amplia, refactors grandes.

- Modo “en tiempo real”: edición, revisión, micro-cambios y ciclo rápido de prueba-error.

La propuesta de OpenAI es que ambos modos converjan con el tiempo: mantener una experiencia interactiva cerrada mientras se delegan tareas largas en subagentes, o incluso repartir trabajo entre varios modelos en paralelo. Si esto se consolida, el impacto no será solo “un modelo más rápido”, sino una redefinición del ritmo al que se programa con asistencia: menos fricción, menos esperas y más sensación de “pair programming” continuo.

Preguntas frecuentes

¿Qué es exactamente GPT-5.3-Codex-Spark?

Una variante más ligera de GPT-5.3-Codex, publicada como versión preliminar de investigación y optimizada para programación en tiempo real con latencia muy baja.

¿Qué ventajas tiene frente a un modelo de codificación “normal”?

Prioriza la reactividad: respuestas casi instantáneas, cambios mínimos y precisos, y un flujo de trabajo pensado para iterar rápido (incluido un mejor tiempo hasta el primer token).

¿Qué límites o restricciones tiene en esta fase?

En la vista previa, funciona solo con texto, cuenta con 128.000 tokens de contexto y está sujeto a límites de uso/rate limit independientes; en momentos de alta demanda puede haber colas o acceso limitado.

¿Por qué Cerebras y no solo GPU?

OpenAI explica que las GPU siguen siendo clave por coste/eficiencia general, pero Cerebras aporta un camino de inferencia de latencia ultrabaja para escenarios donde la velocidad de interacción es el cuello de botella.

vía: openai