La semana en torno a Sora, el generador de vídeo por IA de OpenAI, ha sido un torbellino de críticas, preguntas legales y respuestas a contrarreloj. Tras varios días de polémica por la proliferación de deepfakes hiperrealistas que “resucitan” a celebridades fallecidas —con casos especialmente sensibles denunciados por familiares—, la compañía ha dado marcha atrás en parte de su planteamiento inicial: permitirá que representantes de figuras públicas “recientemente fallecidas” soliciten el bloqueo de su imagen en los vídeos generados con Sora. Es un giro relevante en una política que, desde el lanzamiento del modelo, eximía a las figuras públicas de las restricciones de consentimiento que sí rigen para personas privadas, bajo el argumento del “fuerte interés por la libertad de expresión” al representar personajes históricos.

La rectificación, adelantada por The Washington Post —con la frase atribuida a una portavoz de OpenAI: “Creemos que las figuras públicas y sus familias deben tener, en última instancia, el control sobre cómo se utiliza su imagen”— llega acompañada de dos anuncios estratégicos del propio Sam Altman, cofundador y CEO de OpenAI, en su blog personal: más control granular para titulares de derechos sobre la generación de personajes (licencias, límites de uso o veto total) y el inicio de un modelo de reparto de ingresos con quienes autoricen el uso de sus personajes por parte de usuarios de Sora. La compañía reconoce que el modelo de negocio de vídeo tendrá que cobrar y que muchos usuarios “generan mucho más de lo esperado”, lo que obliga a sostener la infraestructura y, si procede, compartir parte de esa recaudación con los rightsholders que opten por participar.

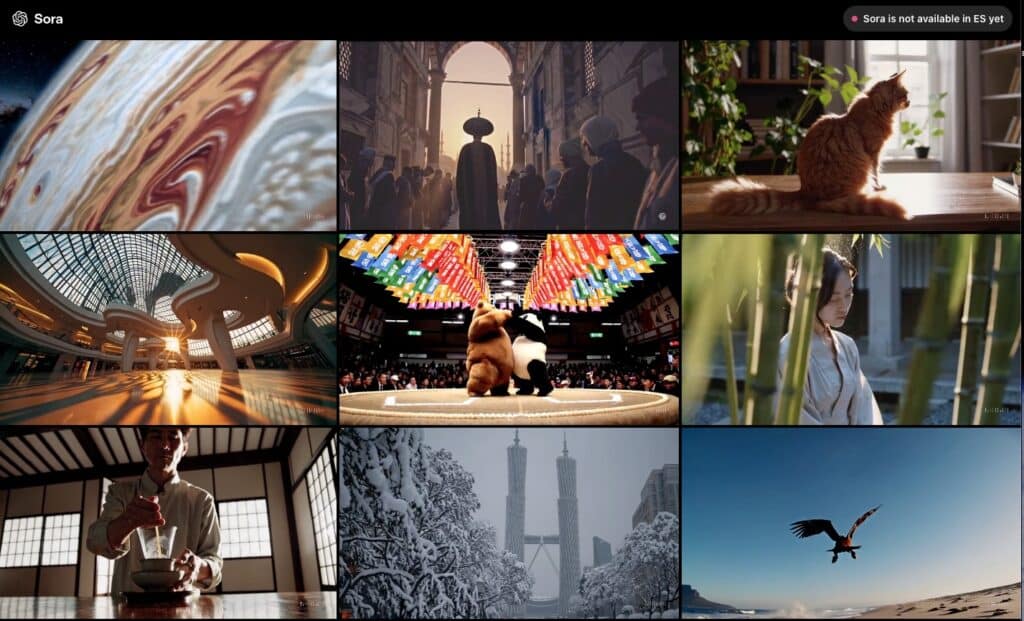

El contexto: Sora, entre el asombro tecnológico y la alarma ética

Desde su anuncio, Sora se ha convertido en símbolo del salto de la IA generativa al vídeo fotorealista accesible. Esa potencia técnica —poder crear, en segundos, escenas verosímiles con personas reales— ha sido también su talón de Aquiles reputacional. En redes circularon piezas que recreaban con precisión a Michael Jackson, Elvis Presley o Amy Winehouse, entre otros, y, sobre todo, vídeos ofensivos o degradantes atribuidos a figuras históricas. El caso que sacudió a la opinión pública fue el de Zelda Williams, hija del actor Robin Williams, quien denunció la aparición de múltiples vídeos generados por Sora con el rostro de su padre. En paralelo, Ilyasah Shabazz, hija de Malcolm X, criticó la circulación de clips en los que una versión sintética de su padre hacía “bromas groseras”, peleaba con Martin Luther King Jr. o profería escenas escatológicas. Son ejemplos que no solo reabren el debate sobre el legado póstumo y la dignidad de personas fallecidas, sino sobre el consentimiento y quién puede concederlo tras la muerte.

OpenAI había sostenido hasta ahora que no representaría a personas reales sin su consentimiento, pero incluyó una excepción para figuras públicas, apelando a la libertad de expresión y al interés legítimo en representar a “personajes históricos”. En la práctica, eso abrió un agujero: cualquiera podía crear vídeos virales que “devolvían a la vida” a celebridades o líderes, con riesgo de desinformación y daño emocional a familias y comunidades. La presión pública y la reacción de allegados obligaron a mover ficha.

Qué cambia (y qué queda por definir)

La novedad principal es la posibilidad de que representantes de figuras públicas “recientemente fallecidas” soliciten el bloqueo de su imagen en Sora. El matiz recientemente es crítico y, de momento, no está definido por OpenAI (ni en plazos ni en criterios objetivos), lo que abre interrogantes sobre a quién y hasta cuándo se aplicará el mecanismo. ¿Meses? ¿Años? ¿Dependerá del carácter de la persona o de su impacto cultural? La portavoz citada por The Washington Post evitó concretarlo.

En paralelo, Altman adelantó dos movimientos:

- Controles más granulares para titulares de derechos. OpenAI ofrecerá a rightsholders una paleta de opciones para autorizar, limitar o vetar la generación de personajes (que en el contexto del post puede abarcar propiedades intelectuales —p. ej., personajes de ficción— y personas cuya imagen es gestionada por herederos o gestores de legado). Altman lo compara con el modelo de opt-in de “likeness” ya existente, pero con controles adicionales. La compañía asume que habrá casos límite que se cuelen y admite que afinar la tubería (“stack”) llevará iteración.

- Reparto de ingresos con rightsholders que autoricen el uso. Dado que “la gente está generando mucho más de lo esperado por usuario” y que “muchos vídeos se crean para audiencias muy pequeñas”, OpenAI cobrará por la generación de vídeo y probará un revenue share con titulares que quieran que sus personajes sean generados por usuarios. Sin detallar porcentajes, la compañía anticipa prueba-error para encontrar el modelo y promete comenzar “muy pronto”.

Altman, además, dedica un guiño explícito a Japón y su industria cultural: reconoce “la notable producción creativa” del país y “lo profunda que es la conexión entre usuarios y contenido japonés”, un indicio de que la compañía escucha —y busca apoyo— donde el fandom y las IP tienen un peso social y económico extraordinario.

Un equilibrio inestable: libertad de creación, derechos de imagen y daño moral

El nudo del debate con Sora no es estrictamente técnico, sino normativo y ético:

- Libertad de expresión vs. derecho a la propia imagen. En la mayoría de jurisdicciones, las figuras públicas gozan de una menor expectativa de privacidad, pero siguen teniendo derechos sobre su imagen y su explotación comercial. La muerte no los borra: los herederos y gestores de legado suelen administrar licencias y usos.

- Desinformación y contexto. Los vídeos hiperrealistas pueden engañar a audiencias —sobre todo si circulan descontextualizados—, erosionando confianza y memoria histórica.

- Daño emocional. Las familias de personas fallecidas pueden sufrir revictimización al ver a sus seres queridos “protagonizando” escenas degradantes o contrarias a sus valores.

- Economía del fandom. No todo es veto: Altman afirma que “muchos titulares de derechos están entusiasmados con esta nueva ‘fan fiction interactiva’” y quieren definir cómo se usa su IP. Es un área donde la monetización (via revenue share) y la fidelización pueden alinear incentivos.

La decisión de permitir vetos para “recientemente fallecidos” es un parche relevante, pero parcial: deja fuera a figuras de fallecimiento remoto y mantiene la exención general para vivos (que, en teoría, requieren consentimiento) y para públicos no “recientes”. El riesgo de zonas grises —y de arbitraje por parte de OpenAI— persiste.

Altman pide “paciencia”: iteración rápida, errores y correcciones

El cofundador de OpenAI pide expectativas realistas: “Esperen un ritmo de cambio muy alto, me recuerda a los primeros días de ChatGPT. Tomaremos buenas decisiones y meteduras de pata, pero escucharemos y arreglaremos rápido”. El plan es probar enfoques en Sora y, cuando funcionen, extenderlos “de forma consistente” al resto de productos.

Ese enfoque experimental tiene una cara positiva —apertura a corregir— y otra delicada: políticas que afectan a derechos de personas y familias requieren claridad y previsibilidad. “Recientemente fallecido” y la operativa de los vetos (quién, cómo, en qué plazos, con qué prueba de legitimación, qué recursos) son temas que OpenAI tendrá que documentar con precisión para evitar arbitrariedades y abusos.

El negocio: cobrar por vídeo y compartir ingresos (si hay autorización)

Más allá de la polémica, OpenAI afronta un reto obvio: el vídeo cuesta. La demanda “muy superior a lo esperado por usuario” obliga a monetizar. La compañía explorará tarifas (pago por uso, paquetes, suscripciones) y reparto de ingresos “para quienes quieran” autorizar sus personajes. El equilibrio que busca Altman es que la nueva forma de interacción (esa fan fiction “interactiva”) sea tan valiosa para los rightsholders que el revenue share sea atractivo, sin convertir Sora en un catálogo prohibitivo para usuarios.

Quedan preguntas prácticas: cómo se mide el uso de un personaje, cómo se evitan usos “parásitos” que rozan el plagio, qué porcentaje se comparte, cómo se reparten ingresos si el vídeo no tiene audiencia… Altman asume ensayo y error.

¿Qué pueden esperar las familias y titulares de derechos?

- Un canal para solicitar bloqueo de la imagen de figuras públicas “recientemente fallecidas” en Sora (pendiente de ver criterios y procedimiento).

- Herramientas de control más granulares: opt-in/opt-out de personajes, límites de uso, permisos por escenarios.

- Posible monetización vía revenue share si deciden autorizar usos concretos.

La eficacia dependerá de la implementación: detección y moderación automáticas (y humanas), velocidad en retirar contenidos que incumplan vetos, resolución de disputas y coordinación con plataformas donde los vídeos circulan (para avisos y bajadas).

Un apunte sobre Japón (y otros mercados culturales)

El gesto de reconocer la “producción creativa notable” de Japón no es casual: el manga, el anime y sus IP son ecosistemas de derechos complejos y fandom intensísimo, donde el uso derivado (parodia, doujinshi, fan art) convive con protecciones estrictas. Para Sora, encajar con esa cultura significa evitar conflictos con comités y editoriales, a la vez que capitaliza el entusiasmo de fans. Lo mismo vale para K-content, Hollywood o música: habrá acuerdos sectoriales, listas blancas y vetos cruzados.

Conclusión: una marcha atrás parcial que reconoce el daño y abre un camino

OpenAI ha escuchado y recula en un punto sensible: la posibilidad de que familias de figuras públicas recientes veten su uso en Sora. Acompaña el gesto con dos mensajes de realpolitik: más controles para rightsholders y un reparto de ingresos que intente alinear incentivos. Es un paso en la dirección correcta, pero insuficiente si no se traduce en políticas claras, procesos eficaces y moderación que funcione. El desafío de equilibrar creación, memoria, derechos y negocio apenas ha empezado.

Mientras tanto, conviene no perder de vista lo esencial: las personas detrás de los rostros. La tecnología puede hacer magia visual, pero la legitimidad de esa magia se juega en el consentimiento y en el respeto.

Preguntas frecuentes (FAQ)

¿Qué cambia exactamente en Sora con respecto a figuras públicas fallecidas?

OpenAI afirma que permitirá a representantes de figuras públicas “recientemente fallecidas” solicitar que se bloquee su imagen en vídeos generados por Sora. La empresa no ha definido aún qué significa “recientemente” ni el procedimiento (pruebas, plazos, recursos).

¿Puedo bloquear usos de un personaje o de una IP que gestiono aunque no haya fallecido nadie?

Según el blog de Sam Altman, OpenAI dará a los titulares de derechos controles más granulares para la generación de personajes: opt-in/opt-out, limitaciones y veto total. Los detalles (paneles, APIs, alcance) se concretarán en las próximas iteraciones.

¿Habrá que pagar por generar vídeo con Sora? ¿Cómo funcionará el reparto de ingresos?

OpenAI admite que “tendrá que ganar dinero” con la generación de vídeo. Explora modelos de cobro y revenue share con rightsholders que autoricen sus personajes. El modelo exacto (porcentajes, atribución, umbrales) se ajustará con prueba-error.

¿Sigue siendo legal crear vídeos de “personajes históricos” sin permiso en Sora?

OpenAI había amparado esa opción en un “fuerte interés por la libertad de expresión”. Con los nuevos controles y el veto para recientemente fallecidos, el margen se estrecha. En cualquier caso, lo legal varía por jurisdicción: el derecho de imagen y la explotación comercial de una persona pueden estar protegidos incluso tras su muerte, y el uso de su imagen sin autorización puede generar reclamaciones.

vía: blog.samaltman