En un momento en que las aplicaciones basadas en grandes modelos de lenguaje (LLM) son clave para empresas y proyectos de IA, Comet ha lanzado Opik, una plataforma de código abierto diseñada para evaluar, depurar y monitorizar sistemas LLM de forma eficiente y escalable.

Desde simples chatbots RAG hasta complejas arquitecturas agenticas, Opik permite a los desarrolladores y organizaciones construir aplicaciones LLM más rápidas, robustas y optimizadas para producción.

¿Qué es Opik?

Opik es una plataforma integral de trazabilidad, evaluación y monitorización de aplicaciones basadas en LLM que ofrece:

- Herramientas de desarrollo

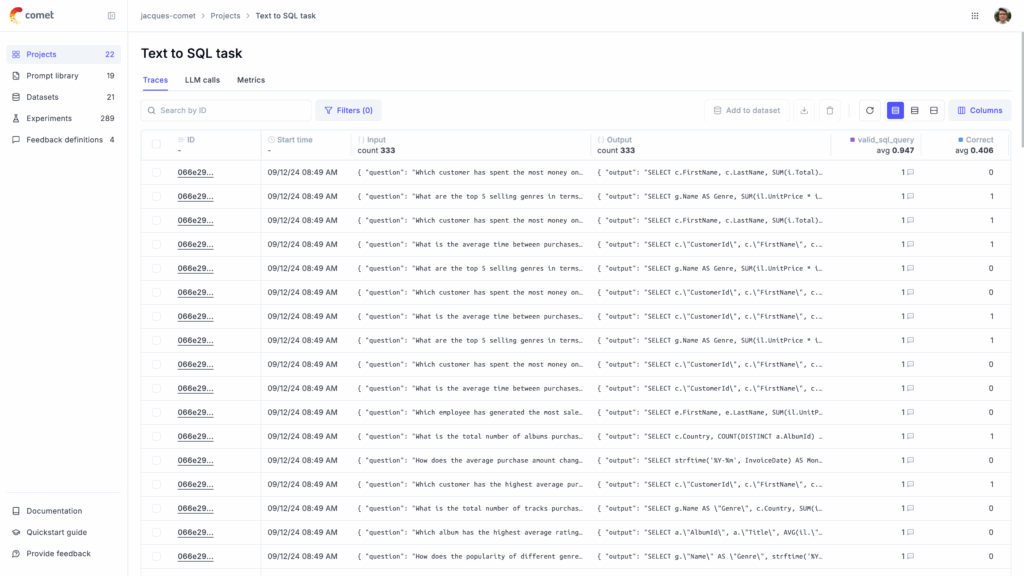

- Trazabilidad: Registro de todas las llamadas LLM y flujos de ejecución en entornos de desarrollo y producción.

- Anotaciones: Captura de evaluaciones manuales y puntuaciones de retroalimentación mediante el SDK de Python o la interfaz web.

- Playground: Espacio interactivo para experimentar con prompts y modelos.

- Framework de evaluación

- Evaluaciones automatizadas: Realización de pruebas con datasets y experimentos controlados.

- LLM como evaluador: Utilización de modelos para detectar alucinaciones, evaluar precisión en RAG y moderación de contenido.

- Integración CI/CD: Ejecución de evaluaciones como parte del pipeline de integración continua mediante PyTest.

- Monitorización en producción

- Alta escalabilidad: Soporta volúmenes de hasta 40 millones de trazas diarias.

- Dashboards: Análisis visual de trazas, consumo de tokens y feedback de usuarios.

- Evaluaciones en línea: Análisis automático de la calidad de las respuestas en producción.

Opciones de instalación

Opik puede desplegarse de diferentes maneras:

| Método | Instrucciones |

|---|---|

| Nube (recomendado) | Crear una cuenta gratuita en Comet.com |

| Instalación local (Docker Compose) |

git clone https://github.com/comet-ml/opik.git

cd opik

./opik.sh

Acceso local en localhost:5173 | | Despliegue en Kubernetes | Guía de despliegue específica disponible en la documentación |

Posteriormente, basta instalar el SDK de Python y configurarlo:

pip install opik

opik configure --use_local

Integraciones disponibles

Opik ofrece integraciones nativas con los principales frameworks y proveedores, entre ellos:

- OpenAI

- LangChain

- Haystack

- Anthropic

- Gemini

- Groq

- DeepSeek

- Bedrock

- LlamaIndex

- LangGraph

- Predibase

- Ragas

- CrewAI

- Entre otros

También es posible registrar trazas manualmente con el decorador @track:

import opik

@opik.track

def mi_funcion_llm(pregunta_usuario: str) -> str:

return "Respuesta generada"

Métricas de evaluación integradas

Opik proporciona herramientas avanzadas para medir la calidad de las respuestas:

- Métricas LLM-as-a-Judge:

Evaluación automática de respuestas para detectar errores, incoherencias o desviaciones del contexto. - Métricas heurísticas:

Evaluaciones rápidas sin necesidad de modelos externos.

Ejemplo de uso:

from opik.evaluation.metrics import Hallucination

metric = Hallucination()

score = metric.score(

input="¿Cuál es la capital de Francia?",

output="París",

context=["Francia es un país en Europa."]

)

print(score)

Beneficios principales de Opik

- Preparado para producción: Manejo de grandes volúmenes de datos en entornos reales.

- Flexible y extensible: Personalización de métricas e integraciones.

- Amigable con CI/CD: Fácil incorporación en pipelines de calidad y validación continua.

- Open Source: Libertad total para modificar y adaptar a necesidades específicas.

Conclusión

A medida que las aplicaciones de IA evolucionan de prototipos a soluciones críticas en producción, Opik se convierte en una herramienta esencial para asegurar su calidad, rendimiento y fiabilidad.

Ya sea para construir asistentes conversacionales, motores de búsqueda basados en RAG o arquitecturas agenticas complejas, Opik ofrece la infraestructura necesaria para optimizar, evaluar y monitorizar aplicaciones basadas en LLM con total confianza.

Para más información, acceso a la documentación completa y guías de despliegue:

https://github.com/comet-ml/opik