Salesforce y Amazon Web Services (AWS) han unido fuerzas para optimizar la implementación de modelos de inteligencia artificial, enfocándose en los modelos de lenguaje de gran tamaño (LLMs). El equipo de Model Serving de Salesforce está desarrollando servicios robustos para facilitar la integración de algoritmos de aprendizaje automático en aplicaciones críticas.

El despliegue eficiente de estos modelos es un desafío, ya que deben garantizar un rendimiento óptimo y una gestión de costos eficaz. Los modelos varían en tamaño, desde unos pocos gigabytes hasta 30 GB, lo que complica aún más su implementación. Los modelos grandes suelen subutilizar los recursos de las GPUs, mientras que los de tamaño intermedio requieren procesamiento rápido, aumentando así los costos por la sobreasignación de recursos.

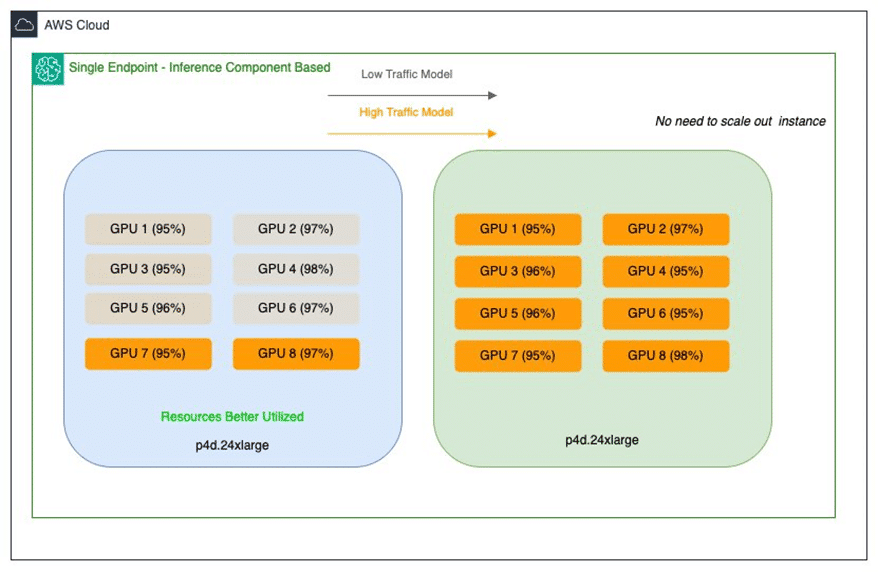

Salesforce ha comenzado a utilizar componentes de inferencia de Amazon SageMaker para enfrentar estos desafíos. Esto permite implementar múltiples modelos en un único punto final de SageMaker, otorgando control específico sobre los recursos asignados a cada modelo. Así, se mejora la eficiencia de los recursos y se reducen los costos de implementación.

La implementación de estos componentes de inferencia trae numerosos beneficios, como la optimización del uso de GPUs y la posibilidad de escalar los modelos individualmente según las necesidades. Este enfoque no solo resuelve problemas actuales, sino que establece una base flexible para las iniciativas de inteligencia artificial de Salesforce.

Los costos de infraestructura pueden reducirse significativamente, logrando ahorros de hasta un 80% en despliegues. Además, los modelos más pequeños también se benefician de GPUs de alto rendimiento, ofreciendo alto rendimiento y baja latencia sin incurrir en altos costos.

De cara al futuro, Salesforce planea utilizar las actualizaciones continuas de los componentes de inferencia para mantener sus modelos actualizados de manera eficiente. Esto minimiza la carga operativa y permite la integración de futuras innovaciones, posicionando a la compañía para crecer y expandir sus ofertas de inteligencia artificial, manteniendo altos estándares de eficiencia y costo.