En el contexto actual, donde empresas y desarrolladores buscan optimizar sus modelos de lenguaje para tareas específicas, la elección entre la personalización del modelo y la Generación Aumentada por Recuperación (RAG) se torna crucial. Este artículo pretende satisfacer esta creciente necesidad, ofreciendo directrices claras y prácticas sobre cuándo utilizar cada enfoque, facilitando decisiones informadas que se alineen con requisitos y objetivos particulares.

La introducción de los modelos Amazon Nova marca un avance significativo en el campo de la inteligencia artificial, proporcionando nuevas oportunidades para la optimización de modelos de lenguaje de gran tamaño. Un estudio comparativo exhaustivo entre la personalización de modelos y RAG utilizando los últimos modelos de Amazon Nova pone en evidencia valiosos insights.

La RAG es una técnica que mejora la capacidad de modelos preentrenados al permitirles acceder a fuentes de datos externas específicas de un dominio. Este método combina la recuperación de conocimientos externos con la generación de respuestas, lo que permite a los modelos de lenguaje preentrenados incorporar dinámicamente información durante el proceso de generación. A diferencia de la personalización, que ajusta los parámetros del modelo para alinearlo con tareas específicas, la RAG utiliza información específica del dominio de manera explícita a través de la recuperación externa.

La RAG es óptima para casos de uso que requieren datos dinámicos o frecuentemente actualizados, como preguntas frecuentes en soporte al cliente, información de catálogos de comercio electrónico y sistemas regulatorios. En contraste, la personalización es ideal para escenarios que demandan una precisión personalizada, como chatbots y tareas específicas en las que la alta precisión es crucial.

Amazon Nova se presenta como una nueva generación de modelos fundamentales, que ofrecen inteligencia de frontera y desempeño costo-efectivo. Los modelos Amazon Nova Pro y Lite, multimodales, destacan en precisión y velocidad, con el Nova Lite optimizado para procesamiento rápido y bajo costo. Estos modelos permiten la integración de flujos de trabajo autónomos con fuentes de conocimiento, así como la personalización para datos textuales y multimodales.

Un marco de evaluación comprensivo se diseñó para evaluar la efectividad de RAG frente a la personalización del modelo. La evaluación se estructura en configuraciones como modelo base, modelo base con RAG, personalización del modelo y una combinación de ambos enfoques.

Para aquellos interesados en implementar RAG con el modelo base de Amazon Nova, se describen pasos necesarios para crear una base de conocimientos dentro de Amazon Bedrock. También se ofrecen instrucciones detalladas sobre cómo afinar un modelo de Amazon Nova utilizando la API de Amazon Bedrock. Este proceso simplificado incluye la creación de trabajos de afinación y la configuración de hiperparámetros, permitiendo a los usuarios obtener un modelo personalizado que se adapte mejor a sus necesidades.

La evaluación también abarca un marco de múltiples juicios de LLM para mitigar sesgos individuales, utilizando modelos como Claude Sonnet de Anthropic y Llama de Meta. Los resultados indican que tanto la personalización como RAG mejoraron significativamente la calidad de las respuestas generadas en comparación con el modelo base. La combinación de ambos enfoques resultó en mejoras aún mayores en la calidad de respuesta, especialmente en tareas específicas.

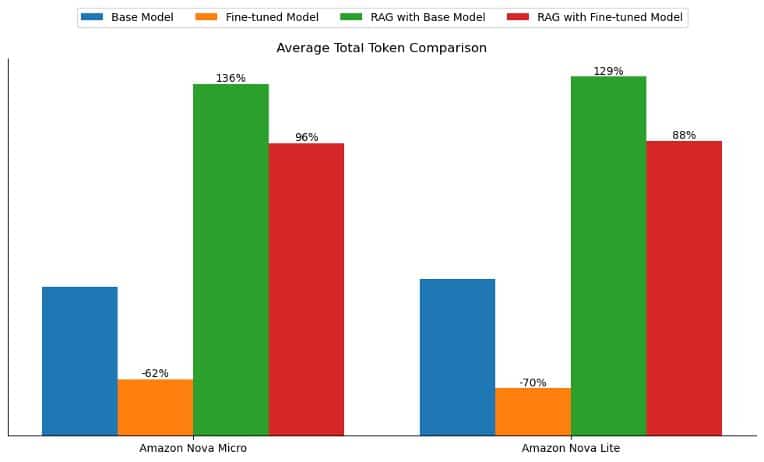

Adicionalmente, se evaluaron las implicaciones de latencia y el uso de tokens, revelando que la personalización no solo reduce la latencia significativamente, sino que también mejora la alineación del tono y estilo de las respuestas generadas con los datos de entrenamiento. Estos hallazgos sugieren que la personalización del modelo puede ofrecer mayor valor en contextos que requieren respuestas ajustadas a un estilo o tono particular.

En conclusión, se recomienda considerar una combinación de personalización y RAG para maximizar el rendimiento en tareas de preguntas y respuestas, aprovechando los beneficios de ambas estrategias.