En la última entrega de la serie sobre personalización de modelos DeepSeek, se ha presentado un enfoque innovador para ajustar el modelo DeepSeek-R1, que cuenta con 671 mil millones de parámetros, mediante el uso de las recetas de Amazon SageMaker HyperPod. Después del éxito de la primera parte, que se centró en la optimización de modelos destilados, este artículo detalla las técnicas necesarias para ajustar el modelo original, poniendo especial énfasis en las ventajas de la arquitectura Mixture of Experts (MoE).

El modelo DeepSeek-R1, desarrollado por DeepSeek AI, ha demostrado ser prometedor en diversas evaluaciones desde su lanzamiento. Entrenado con 14.8 billones de tokens, el modelo tiene la capacidad de realizar tareas con pocas muestras o incluso ninguna, adaptándose eficazmente a nuevos escenarios no contemplados en su entrenamiento inicial. Su capacidad de personalización es especialmente valiosa para sectores como el financiero y el médico, ya que permite ajustar el modelo con datos específicos para mejorar su eficacia.

No obstante, personalizar estos modelos de gran tamaño requiere una optimización meticulosa que equilibre costos, implementación y efectividad del rendimiento. En este contexto, las recetas de SageMaker HyperPod ofrecen un enfoque completo que combina técnicas de entrenamiento distribuido, optimizaciones y configuraciones para modelos avanzados, facilitando la integración con los procesos de entrenamiento y ajuste de SageMaker.

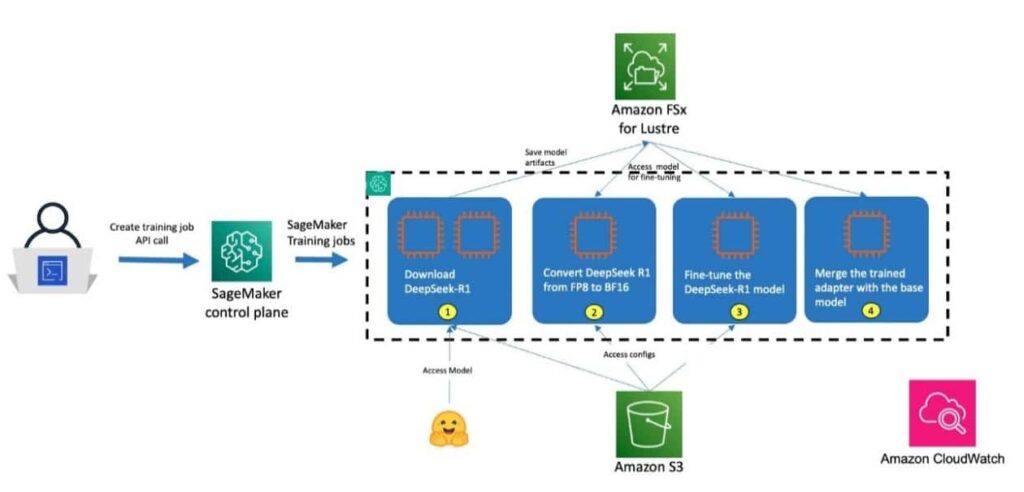

La arquitectura de solución fue explicada en detalle, incluyendo cómo iniciar el proceso de ajuste desde el nodo de inicio del clúster Slurm hasta la ejecución del modelo, utilizando el sistema de archivos Amazon FSx para Lustre para almacenar los puntos de control del modelo. El artículo describe un proceso por etapas que incluye la descarga del modelo, la conversión de pesos y la ejecución del ajuste fino utilizando la técnica de Quantized Low-Rank Adaptation (QLoRA).

Además, se ofrecen instrucciones sobre los requisitos previos y la configuración del entorno, asegurando que los profesionales puedan seguir los pasos necesarios para implementar este proceso en sus instalaciones de SageMaker con éxito.

En resumen, esta entrega destaca la flexibilidad del modelo DeepSeek-R1 y proporciona a los usuarios un marco claro para maximizar su eficiencia a través de personalizaciones adaptadas a sus necesidades específicas. La guía concluye sugiriendo a los interesados que exploren el repositorio de recetas de SageMaker HyperPod en GitHub, donde podrán acceder a documentación completa y ejemplos prácticos, reafirmando el compromiso de AWS de facilitar la formación efectiva de modelos de IA.