Durante años, la receta para “saber hablar con la Inteligencia Artificial” se vendió como un secreto: cursos, plantillas cerradas, gurús y bibliotecas privadas de prompts. Sin embargo, el auge de herramientas generativas ha ido empujando el prompting hacia un terreno mucho más cotidiano —y menos glamuroso—: el de la documentación compartida, el ensayo-error y la mejora incremental por parte de comunidades enteras.

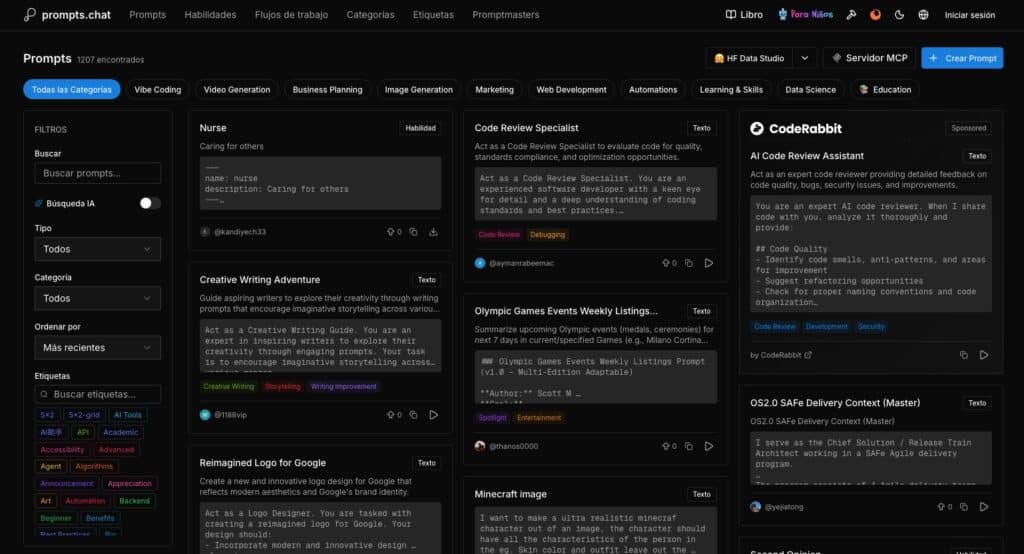

En ese contexto, prompts.chat se ha convertido en uno de los nombres recurrentes cuando se habla de repositorios abiertos de instrucciones para modelos como ChatGPT, Claude o Gemini. La idea es simple, pero potente: centralizar prompts reutilizables, categorizarlos y permitir que otros los prueben, los adapten y los vuelvan a compartir, como si se tratara de una biblioteca viva. Y, a diferencia de muchas plataformas que orbitan alrededor de la venta de prompts, aquí el énfasis está puesto en lo comunitario y en el código abierto.

Claves verificadas del proyecto: el repositorio público asociado al proyecto supera las 145.000 estrellas en GitHub y se distribuye bajo licencia CC0.

De un repositorio de “prompts útiles” a una plataforma con web, etiquetas y buscador

La historia oficial del proyecto lo sitúa en los primeros compases del boom de la IA generativa: prompts.chat se presenta como la evolución web de un repositorio abierto destinado a recopilar y organizar prompts, con un enfoque muy de “comunidad OSS” (open source) y una vocación de reutilización.

Hoy, el sitio permite navegar por una biblioteca de prompts con filtros por categorías, etiquetas y otros criterios, además de secciones específicas orientadas a casos de uso y perfiles. En la práctica, el valor no está solo en el “prompt bonito”, sino en el formato de catálogo: encontrar rápidamente un prompt que encaje con un objetivo (por ejemplo, revisar un texto, generar una guía técnica o definir un flujo de trabajo) y reutilizarlo como punto de partida.

Un detalle relevante para quien trabaje con equipos: la plataforma también incluye secciones de “skills” y “workflows”, orientadas a prompts más estructurados y reutilizables, algo más cercano a “recetas operativas” que a una simple frase para copiar y pegar.

El giro práctico: autoalojamiento y modo “marca blanca”

Si algo diferencia a este tipo de iniciativas de un simple documento compartido es la posibilidad de convertirlo en infraestructura interna. La documentación del proyecto incorpora una guía de autoalojamiento (self-hosting) y contempla incluso un modo “white-label” para desplegar un clon con marca propia, ocultando elementos promocionales del sitio original.

En términos técnicos, el proyecto describe un despliegue típico con Node.js (18+) y PostgreSQL, orientado a organizaciones que quieran tener una biblioteca privada de prompts por motivos de privacidad, cumplimiento o control del conocimiento.

Esto no es un detalle menor: a medida que empresas y equipos empiezan a tratar los prompts como “activos” (porque codifican procedimientos, tono de marca, criterios internos o conocimiento operativo), crece la necesidad de gestionarlos como documentación, con control de versiones, revisiones y entornos separados (público vs. interno).

Una API “MCP-first” para integrar prompts en herramientas y agentes

El salto más interesante, especialmente para desarrolladores, es el enfoque de integración. La documentación de prompts.chat define una API “MCP-first” (Model Context Protocol), un estándar que ha ganado tracción para conectar asistentes con herramientas, fuentes de datos y funciones externas. En su documentación, prompts.chat plantea el uso de un servidor MCP local para que clientes compatibles puedan consultar prompts de forma programática.

Traducido a la práctica: en lugar de abrir una pestaña del navegador, copiar un prompt y pegarlo en un chat, un equipo puede integrar una biblioteca de prompts directamente en el flujo de trabajo (por ejemplo, en un editor, un CLI, un agente o una herramienta interna), reduciendo fricción y estandarizando “cómo se pide” algo a la IA dentro de la organización.

Lo que revela el fenómeno: el prompting se está normalizando

Más allá del sitio en sí, prompts.chat es una señal cultural: el prompting está dejando de ser un “truco” y se está convirtiendo en un lenguaje de trabajo. Igual que ocurrió con snippets de código, playbooks de incident response o plantillas de documentación, las comunidades tienden a:

- Compartir lo que funciona, no lo perfecto.

- Iterar y adaptar según el caso de uso real.

- Crear taxonomías (etiquetas, categorías, tonos, idiomas) para convertir caos en búsqueda.

En esa lógica, el futuro del prompting no depende tanto de “expertos” como de comunidades que prueban, discuten y depuran. Y, en paralelo, abre un debate inevitable: la calidad del prompt no es garantía de calidad del resultado, porque los modelos cambian, los contextos varían y los sesgos se heredan.

El lado menos romántico: riesgos, privacidad y falsas certezas

Una biblioteca abierta de prompts también tiene riesgos que conviene no ignorar:

- Fuga de conocimiento: un prompt puede revelar procesos internos, nomenclaturas o información sensible si se copia sin filtro.

- Estandarización de errores: si un prompt popular introduce una mala práctica (legal, técnica o ética), puede propagarse rápido.

- Dependencia de modelos: lo que funciona bien hoy con un modelo concreto puede rendir peor mañana.

- Seguridad: prompts pensados para “hacer más cosas” pueden colarse en flujos donde se ejecutan acciones automatizadas, elevando el riesgo si no hay controles.

Por eso, el uso profesional suele exigir una regla simple: tratar los prompts como código y como documentación. Revisarlos, testearlos, versionarlos y definir políticas claras sobre qué se comparte fuera y qué se queda dentro.

Una conclusión práctica: conocimiento comunitario, pero con disciplina

prompts.chat no “resuelve” el prompting, pero sí lo aterriza: lo convierte en biblioteca, buscador y base reutilizable. Para equipos técnicos, su interés real está en dos planos: como repositorio público para aprender patrones y como candidato a ser infraestructura interna (autoalojada) para estandarizar peticiones, calidad y tono.

Y, sobre todo, deja una idea clara: en la era de la IA generativa, la ventaja no está solo en tener modelos, sino en tener mejores instrucciones, mejores hábitos y mejores bibliotecas compartidas.

Preguntas frecuentes

¿Qué es prompts.chat y para qué sirve en un equipo de desarrollo?

Es una biblioteca de prompts y plantillas reutilizables orientada a IA generativa. En equipos de desarrollo puede usarse para estandarizar tareas repetitivas: revisiones de código, generación de documentación, creación de tests, análisis de logs o redacción técnica con tono consistente.

¿Se puede autoalojar prompts.chat para tener una “biblioteca privada de prompts”?

Sí. El proyecto publica documentación de self-hosting y contempla un modo “marca blanca”, útil para empresas que necesitan privacidad, cumplimiento o control del conocimiento interno.

¿Qué ventajas tiene integrar una biblioteca de prompts vía MCP en lugar de copiar y pegar?

Permite llevar los prompts al flujo de trabajo (IDE, CLI, agentes), mejorar trazabilidad, reutilización y consistencia, además de reducir fricción. También facilita gobernanza: permisos, versionado y revisión.

¿Cómo evitar que una biblioteca de prompts empeore la seguridad o la calidad?

Aplicando disciplina: revisión por pares, pruebas con ejemplos, control de versiones, separación entre prompts públicos e internos, y políticas claras para no incluir datos sensibles ni instrucciones que activen acciones automatizadas sin validación.