La implementación de asistentes impulsados por inteligencia artificial generativa se está convirtiendo en una práctica frecuente entre las empresas que buscan optimizar sus operaciones. Estos asistentes prometen una mejora significativa en la eficiencia y productividad, ofreciendo capacidades avanzadas de interacción y análisis. Sin embargo, antes de poder desplegar estas avanzadas aplicaciones, las organizaciones deben llevar a cabo una evaluación exhaustiva de su preparación para la producción. Dentro de esta evaluación, la seguridad se perfila como una de las preocupaciones más críticas, ya que la falta de identificación y mitigación de riesgos de seguridad puede retrasar significativamente su implementación.

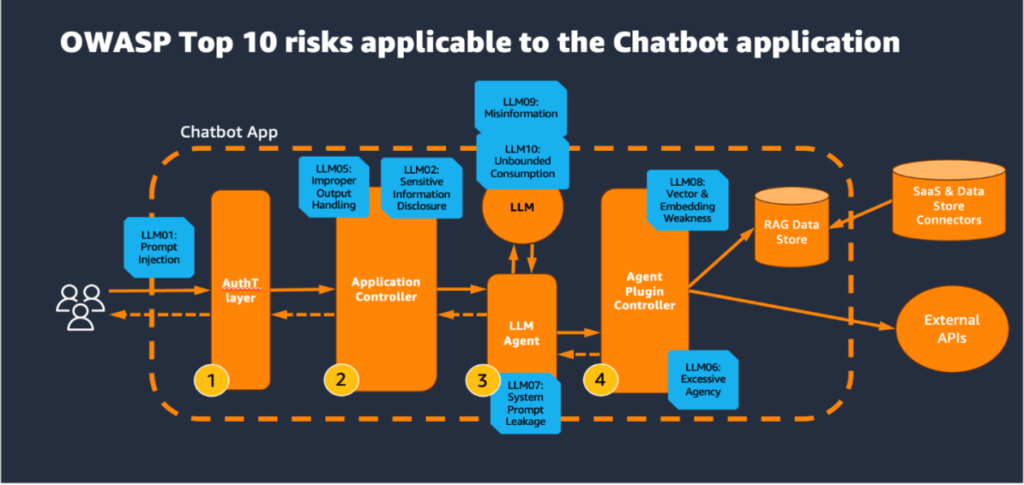

En respuesta a estas preocupaciones, surge la creciente relevancia del marco de evaluación de seguridad proporcionado por OWASP, que ha actualizado recientemente su ya reconocido Top 10 para Aplicaciones de Modelos de Lenguaje Grande (LLM). Este marco tiene como objetivo principal ayudar a las organizaciones a identificar, entender y mitigar las amenazas emergentes en aplicaciones de inteligencia artificial generativa. Sus pautas ofrecen un conjunto de mejores prácticas de seguridad que son esenciales para proteger estas aplicaciones innovadoras de posibles vulnerabilidades.

Un componente clave en estas evaluaciones es el diseño de arquitecturas lógicas robustas para las aplicaciones de asistencia de inteligencia artificial generativa. Estas arquitecturas deben estar equipadas con capas de seguridad efectivas que abarcan desde la autenticación de usuarios hasta la gestión de la salida de datos generados por modelos LLM. Herramientas avanzadas como AWS Cognito y AWS WAF se destacan como esenciales para comprobar la validez de los usuarios que se conectan a la aplicación y para defender la misma de ataques comúnmente conocidos como denegaciones de servicio.

Es imprescindible implementar medidas de seguridad adaptativas, tales como la autenticación multifactor, límites de tasa y gestión de sesiones seguras, para evitar accesos no autorizados. Además, es fundamental que la capa de control de la aplicación, más vulnerable a ataques como la inyección de comandos, esté diseñada con controles de seguridad robustos, incluyendo la validación exhaustiva de entradas.

A medida que las aplicaciones de inteligencia artificial generativa continúan avanzando y expandiéndose, la evaluación y mitigación de riesgos se convierten en elementos fundamentales para asegurar que estas soluciones sean no solo seguras, sino también efectivas en un entorno de producción. Adoptar un enfoque proactivo hacia la seguridad no solo protegerá las aplicaciones, sino que también potenciará la confianza tanto de usuarios como de clientes en el uso de estas tecnologías emergentes.