China ha dado un golpe de efecto en el tablero tecnológico global con la presentación de SpikingBrain-1.0, un modelo de inteligencia artificial que no solo supone un avance técnico, sino también un movimiento estratégico con implicaciones geopolíticas profundas. Desarrollado por el Instituto de Automatización de la Academia China de Ciencias (CASIA), este modelo rompe con dos pilares que hasta ahora parecían intocables en la industria: las arquitecturas transformer y la dependencia de los chips de NVIDIA.

La novedad reside en dos elementos clave: una arquitectura basada en redes neuronales de picos (SNNs, por sus siglas en inglés), inspiradas en el funcionamiento del cerebro humano, y el hecho de haber sido entrenado en GPUs chinas MetaX C550, sin recurrir a la infraestructura de hardware y software controlada por Estados Unidos.

Una arquitectura inspirada en el cerebro

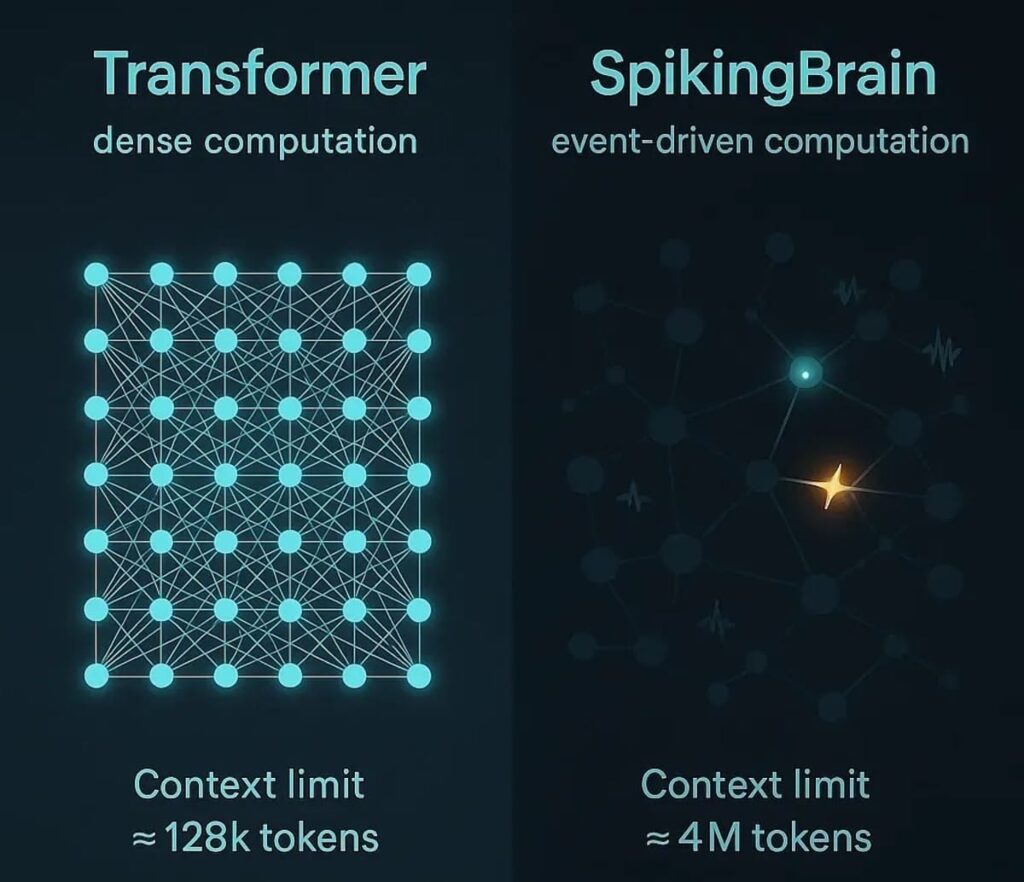

La primera ruptura viene por el lado del diseño. Mientras que la gran mayoría de los modelos de lenguaje actuales —desde GPT hasta Claude o Gemini— se basan en transformers, SpikingBrain-1.0 apuesta por las redes neuronales de picos. Estas imitan el comportamiento de las neuronas biológicas, que no transmiten señales de forma continua, sino mediante impulsos eléctricos discretos.

Este enfoque, que hunde sus raíces en décadas de investigación en computación neuromórfica, permite un procesamiento orientado a eventos y con alta dispersión (sparsity), lo que se traduce en una eficiencia mucho mayor en contextos de datos extremadamente largos.

El informe técnico publicado por CASIA señala que SpikingBrain-1.0 puede manejar ventanas de contexto de hasta 4 millones de tokens, una cifra que multiplica varias veces las capacidades de los modelos actuales, que suelen moverse entre los 128.000 y 1 millón de tokens.

Más allá de la capacidad, los números hablan por sí solos: el modelo de 7.000 millones de parámetros logra una inferencia 26 veces más rápida en contextos de 1 millón de tokens y 100 veces más veloz en contextos de 4 millones de tokens respecto a arquitecturas transformer equivalentes.

En términos prácticos, esto significa que tareas que implican manejar documentos extensos, bases de datos científicas o transcripciones completas de meses de conversaciones podrían procesarse en una fracción del tiempo y con un consumo energético menor.

Adiós a NVIDIA: entrenamiento con GPUs chinas

El segundo pilar que se tambalea es el del hardware. SpikingBrain-1.0 fue entrenado exclusivamente con MetaX C550, chips fabricados en China y diseñados como alternativa a las GPU de NVIDIA, especialmente los modelos A100 y H100, que han sido el estándar de facto en la industria de la IA.

Este hecho es relevante no solo desde un punto de vista tecnológico, sino también político. Las restricciones impuestas por Estados Unidos han limitado el acceso de China a los procesadores más avanzados de NVIDIA, lo que ponía en riesgo su capacidad para competir en la carrera global de la inteligencia artificial. Con SpikingBrain-1.0, Pekín demuestra que puede entrenar un modelo de frontera sin depender del hardware estadounidense ni del ecosistema CUDA, base del software de NVIDIA.

El proyecto movilizó cientos de GPUs MetaX C550, convirtiéndose en una de las mayores ejecuciones de entrenamiento conocidas sin recurrir a silicio fabricado en EE. UU. Es, en definitiva, una declaración de independencia tecnológica.

Más allá de la técnica: un movimiento geopolítico

Este lanzamiento no puede entenderse solo como un avance en inteligencia artificial. Es también una respuesta directa a las sanciones y restricciones que Estados Unidos ha impuesto a las exportaciones de chips avanzados a China.

Con SpikingBrain-1.0, el mensaje es claro: China puede desarrollar y entrenar modelos de frontera por su cuenta. El país no solo busca la soberanía en el acceso a los semiconductores, sino que también está construyendo un stack de IA independiente del que domina Silicon Valley.

Este desacoplamiento tecnológico refuerza la visión de una carrera paralela en inteligencia artificial, con ecosistemas diferenciados y posiblemente incompatibles: uno centrado en NVIDIA y los transformers, y otro que explora arquitecturas neuromórficas y hardware local.

El camino hacia la IA neuromórfica

Aunque SpikingBrain-1.0 aún no está al nivel de los modelos líderes de la industria en cuanto a rendimiento general y capacidades, marca un rumbo muy definido: menos transformers, más neuronas inteligentes.

Las arquitecturas basadas en SNNs, que hasta hace poco eran un campo experimental, muestran ahora su potencial para resolver algunos de los problemas más acuciantes de la IA actual:

- Eficiencia energética: procesar secuencias largas sin disparar los costes eléctricos.

- Escalabilidad: manejar contextos de millones de tokens sin ralentizaciones críticas.

- Flexibilidad: acercar la computación artificial a la forma en que procesa la información el cerebro humano.

Estas características abren la puerta a una futura IA neuromórfica, más sostenible y capaz de superar los límites de los transformers en tareas de memoria y contexto extendido.

Un desafío directo a Silicon Valley

En términos de impacto estratégico, SpikingBrain-1.0 es un recordatorio de que la hegemonía tecnológica de Silicon Valley no es inamovible. Mientras Estados Unidos y Europa se centran en escalar los transformers cada vez más grandes, China muestra que existen alternativas radicales que podrían redefinir el campo.

Es cierto que Nvidia sigue teniendo ventaja con su ecosistema de software y la comunidad global de desarrolladores que trabajan sobre CUDA. Pero el hecho de que Tencent y otras tecnológicas chinas estén desarrollando infraestructuras propias para reducir esta dependencia es un indicador de que el cambio ya está en marcha.

El futuro: de prueba de concepto a modelo consolidado

Por ahora, SpikingBrain-1.0 debe considerarse una prueba de concepto ambiciosa más que un competidor directo de GPT-4, Claude o Gemini. Sin embargo, al marcar una dirección alternativa, sienta las bases para un cambio de paradigma que podría transformar la manera en que se construyen y entrenan los modelos de IA en la próxima década.

Lo que hoy parece un experimento podría convertirse en el estándar del futuro, sobre todo si la presión geopolítica continúa acelerando la necesidad de independencia tecnológica.

Conclusión

El lanzamiento de SpikingBrain-1.0 es un acontecimiento que va mucho más allá del mundo académico. Marca el inicio de una nueva etapa en la inteligencia artificial: China demuestra que puede prescindir de NVIDIA y de los transformers, y que está dispuesta a liderar en un terreno alternativo.

Aunque aún queda camino por recorrer, la apuesta por redes neuronales de picos y hardware propio sitúa al país en una posición única: no solo compite en la misma liga que Occidente, sino que podría estar abriendo el camino hacia la próxima generación de IA.

Preguntas frecuentes

¿Qué son las redes neuronales de picos (SNNs)?

Son un tipo de arquitectura inspirada en el cerebro humano, donde las neuronas transmiten información mediante impulsos eléctricos discretos en lugar de señales continuas, lo que permite un procesamiento más eficiente y escalable.

¿Qué ventajas ofrece SpikingBrain-1.0 frente a los modelos transformer?

Puede manejar contextos de hasta 4 millones de tokens con una eficiencia hasta 100 veces mayor en secuencias largas, reduciendo consumo energético y tiempos de inferencia.

¿Qué hardware se usó para entrenar el modelo?

Se entrenó exclusivamente en GPUs chinas MetaX C550, evitando la dependencia de NVIDIA y de su ecosistema CUDA.

¿SpikingBrain-1.0 es mejor que los modelos líderes actuales como GPT-4 o Claude?

No todavía. Aunque no reemplaza a los LLM más avanzados en todas las tareas, marca una dirección clara hacia arquitecturas más neuromórficas y autónomas respecto a la tecnología estadounidense.

vía: GlobalTimes, ArViX y Medium