NVIDIA PersonaPlex-7B: el salto al “hablar y escuchar a la vez” en voz conversacional

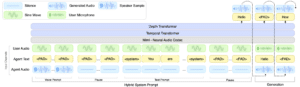

Durante años, la mayoría de asistentes de voz han funcionado como un walkie-talkie educado: tú hablas, el sistema espera; luego responde, y tú vuelves a esperar. Ese “turn-taking” (turnos rígidos) es cómodo para las máquinas… pero poco natural para las personas. La novedad de PersonaPlex-7B es que rompe esa regla: es un modelo de voz “full-duplex”, capaz de escuchar y