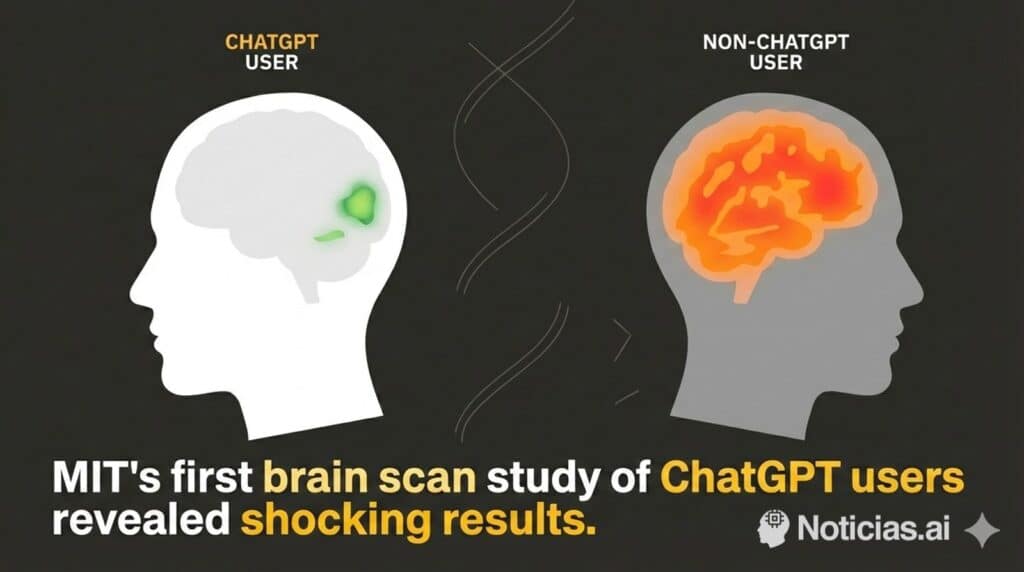

El debate sobre cómo la inteligencia artificial está cambiando la forma en que trabajamos y pensamos acaba de dar un giro inquietante. Un estudio reciente del MIT, basado en escáneres cerebrales y varios meses de seguimiento cognitivo, apunta a una conclusión incómoda: usar ChatGPT de forma pasiva y continuada puede reducir de forma significativa la actividad y el compromiso del cerebro humano durante las tareas de escritura y razonamiento.

La investigación no viene de cualquier sitio. El MIT es una de las instituciones científicas más prestigiosas del mundo y lleva años analizando el impacto de la IA en productividad, aprendizaje y toma de decisiones. Esta vez, ha puesto el foco directamente en el cerebro de los usuarios mientras escriben con y sin ayuda de ChatGPT.

Un experimento sencillo, pero revelador

En el estudio, los participantes realizaban tareas de redacción en dos condiciones:

– escribiendo por su cuenta, sin ayuda de IA,

– y apoyándose en ChatGPT como asistente principal.

Mientras tanto, se monitorizaba su actividad cerebral y su capacidad de recordar lo que acababan de escribir.

Los resultados que se han hecho públicos llaman la atención:

- Un 83,3 % de los usuarios que escribieron con ChatGPT no fueron capaces de recordar una sola frase de lo que habían redactado minutos antes.

- En cambio, aquellos que escribieron sin IA no tuvieron problemas para recordar fragmentos clave de sus textos.

A nivel neurofisiológico, los investigadores midieron un índice de conectividad o “compromiso” cerebral que cayó de 79 a 42 puntos cuando los participantes se apoyaban de manera intensiva en la IA. Es decir, una reducción cercana al 47 % en la participación activa del cerebro mientras realizaban la tarea.

Según los datos disponibles, este grupo mostró el peor rendimiento cognitivo entre todos los perfiles analizados.

El efecto rebote: el cerebro sigue “apagado” incluso después

Uno de los aspectos más preocupantes del estudio es que el efecto no parece limitarse al momento de uso de ChatGPT. En sesiones posteriores, cuando estos mismos usuarios volvieron a escribir sin asistencia de la IA, su nivel de implicación cerebral siguió siendo más bajo que el de quienes nunca habían utilizado ChatGPT durante el experimento.

Es decir, no solo se observa una dependencia puntual, sino un cierto “arrastre” cognitivo: el cerebro se acostumbra a delegar esfuerzo y tarda en volver a implicarse al mismo nivel.

Los educadores que evaluaron los textos añadieron otro matiz cualitativo: los ensayos generados con ayuda intensiva de IA eran técnicamente correctos, pero a menudo se describían como “robóticos”, “sin alma” o “con poca profundidad”. Una crítica que muchos docentes y editores ya llevan tiempo señalando en trabajos escritos con fuerte dependencia de modelos generativos.

La gran paradoja: más rápidos, pero menos presentes

Los datos del MIT dibujan una paradoja clara:

- ChatGPT hace a los usuarios hasta un 60 % más rápidos completando las tareas.

- Pero al mismo tiempo reduce en torno a un 32 % el esfuerzo mental dedicado al aprendizaje.

Desde el punto de vista de la productividad, la tentación es obvia: más tareas terminadas en menos tiempo. Pero desde la perspectiva del aprendizaje, la creatividad y el pensamiento crítico, el panorama cambia: se produce una externalización del esfuerzo cognitivo. El modelo piensa, el usuario supervisa… a medias.

El propio estudio señala qué grupo salió mejor parado:

quienes empezaron trabajando sin IA y la incorporaron después como apoyo, no como sustituto.

Este perfil conservó mejor la memoria de lo escrito, mantuvo niveles más altos de actividad cerebral y obtuvo mejores puntuaciones globales. En otras palabras: primero aprender a pensar, luego usar la IA como amplificador, no como muleta.

La IA, ¿palanca para pensar mejor o anestesia cognitiva?

Esta investigación encaja con una preocupación que se empieza a normalizar en empresas, universidades y administraciones: la IA puede ayudar a pensar mejor… o puede hacer que las personas dejen de pensar.

Cuando ChatGPT se usa como generador automático de textos que se copian casi sin revisión, el usuario ocupa el papel de “operador de prompts”, no de autor. La mente deja de recorrer todo el camino del razonamiento y se limita a validar, corregir detalles o, en el peor de los casos, ni siquiera eso.

El estudio del MIT sugiere que:

- La velocidad no es gratis: se gana tiempo, pero se pierde implicación.

- La memoria se debilita: si el cerebro no “lucha” por construir ideas, recuerda menos.

- La actividad neuronal se empobrece: el esfuerzo cognitivo se desplaza fuera del cráneo, hacia el modelo.

En el contexto educativo, esto plantea dudas sobre tareas, exámenes y formas de enseñar. En el mundo corporativo, abre un melón sobre cómo medir realmente la productividad: ¿solo por outputs entregados o también por el aprendizaje y la capacidad de pensar de quienes los producen?

Un mal uso, no una condena a la IA

Que un estudio detecte este tipo de efectos no significa que la IA sea “mala” en sí misma, sino que el patrón de uso lo es.

El propio MIT apunta a una lectura más matizada:

- Los peores resultados aparecen cuando los usuarios delegan casi toda la escritura y la reflexión en ChatGPT.

- Las mejores métricas llegan cuando la IA se incorpora tras una fase de trabajo autónomo, como herramienta de revisión, mejora de estilo, generación de ejemplos o exploración de alternativas.

En el ecosistema de la IA aplicada, esto refuerza la idea de “human-in-the-loop”: los modelos deberían diseñarse para acompañar y potenciar el pensamiento humano, no para sustituirlo por completo.

Algunas prácticas que se alinean con este enfoque:

- Escribir primero un borrador propio y usar la IA para pulir, resumir o ampliar.

- Pedir a la IA que desafíe argumentos, en lugar de que los construya desde cero.

- Utilizar el modelo para generar preguntas que el usuario deba responder, y no respuestas cerradas listas para copiar y pegar.

- Emplear ChatGPT como herramienta de simulación de escenarios o como “sparring” intelectual, en vez de como autor invisible.

Lo que está en juego: diseñar hábitos mentales en la era de la IA

El estudio del MIT es solo una primera pieza de evidencia, pero marca un punto de inflexión en el debate sobre los modelos de lenguaje. Hasta ahora, gran parte de la conversación se centraba en precisión, sesgos, privacidad o impacto laboral. Ahora entra en escena algo más íntimo: cómo remodelan nuestros hábitos mentales.

La conclusión de los investigadores es clara:

la forma en que se usa ChatGPT importa tanto o más que la propia herramienta.

Usado de forma consciente, puede ampliar capacidades, ayudar a estructurar ideas, acelerar el aprendizaje y servir como aliado creativo. Usado como atajo constante, puede generar textos impecables… mientras el cerebro se acomoda en una especie de piloto automático cognitivo.

Para un ecosistema de IA que quiere ser “responsable”, este tipo de estudios plantean una pregunta incómoda pero necesaria:

¿cómo diseñar interfaces, flujos de trabajo y recomendaciones que fomenten la participación activa del usuario en lugar de premiar solo la rapidez y el volumen de salida?

En el fondo, la advertencia del MIT es menos apocalíptica de lo que parece y más pragmática:

la IA no viene a sustituir el pensamiento humano, pero puede atrofiarlo si la usamos como excusa para dejar de pensar.

vía: Mentes Curiosas