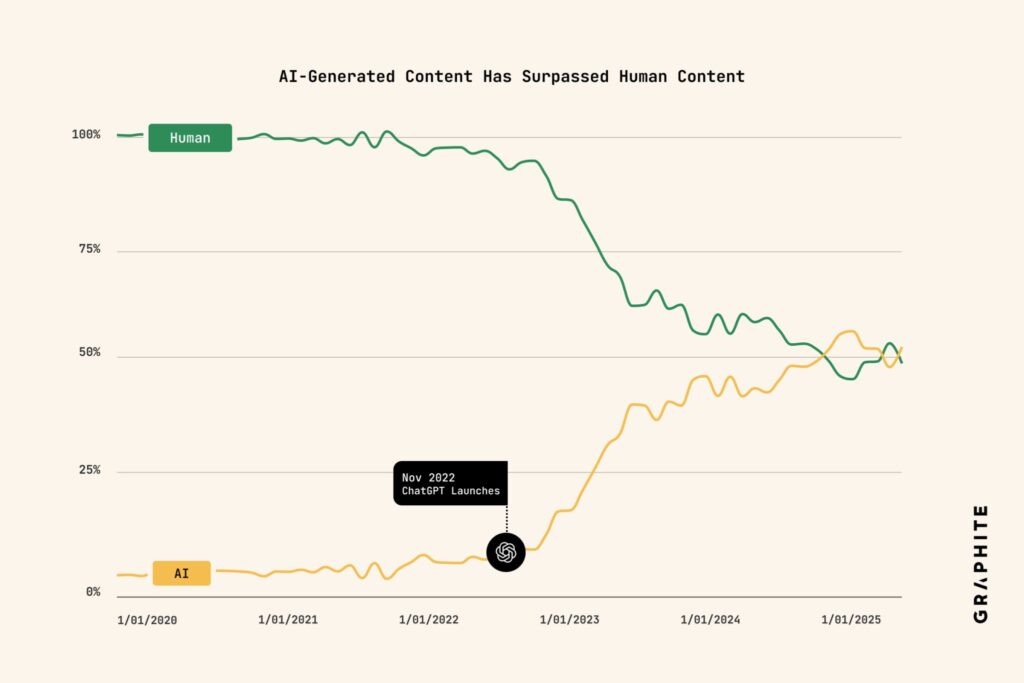

Un análisis reciente de Graphite asegura que más de la mitad de los artículos que se publican en Internet ya están generados por IA. La conclusión llega con advertencias metodológicas —muestra en inglés, páginas con marcado de artículo, dependencia de un detector comercial—, pero refleja una tendencia que el sector percibe desde hace meses: la producción automática escala más rápido que cualquier redacción humana y está empezando a cambiar cómo descubrimos, consumimos y monetizamos la información.

A continuación, lo esencial del estudio, dónde están sus límites, y qué implica para buscadores, marcas, medios, equipos de IA y reguladores.

El dato, sin ruido: 65.000 artículos, troceados y clasificados

- Muestra: 65.000 URLs en inglés extraídas de Common Crawl con marcado de “artículo” o “listicle”, publicadas entre 2020 y mayo de 2025 y con >100 palabras.

- Clasificación: cada artículo se dividió en bloques de 500 palabras y se pasó por el detector de IA de Surfer. Si >50 % del contenido salía “IA”, el artículo se etiquetaba como IA.

- Calibración de errores:

- Falsos positivos (humanos clasificados como IA): al aplicar el detector a artículos pre-ChatGPT (enero 2020–noviembre 2022), 4,2 % salieron “IA”.

- Falsos negativos (IA que pasa por humana): sobre 6.009 textos generados con GPT-4o, el detector acertó el 99,4 % (0,6 % de falso negativo en esa prueba).

Resultado: con esa configuración, la mayoría de los 65k artículos analizados serían IA-generados.

Lo que este estudio sí aporta

- Magnitud: no es una encuesta; es una muestra amplia y pública de la web anglófona con marcado de artículo. El “IA ≥ humano” no suena descabellado en verticales de comercio, reseñas, guías y comparativas.

- Transparencia mínima: el informe estima tasas de error del detector antes de aplicarlo masivamente, un paso que faltaba en otros análisis.

- Punto de partida reproducible: cualquiera puede replicar el pipeline con Common Crawl, troceo y detección (o refutarlo con otros detectores/umbrales).

…y dónde cojea (lo que conviene no extrapolar)

- Detector-dependiente: cambie usted de modelo de detección o el umbral y cambian los porcentajes. Detectar IA en textos híbridos (IA + edición humana), traducidos o parafraseados baja la precisión.

- Supuesto “pre-IA”: asumir que 2020–2022 es 100 % “humano” ignora automatizaciones previas y “spinners”. Ese 4,2 % quizá no sea sólo falso positivo.

- Cobertura limitada: solo inglés, con schema y páginas tipo artículo. Quedan fuera foros, redes, páginas sin marcado, PDFs y otros idiomas.

- Sin URLs: no publicar los dominios evita “listas de la vergüenza”, pero impide auditorías externas por sector/tipo de sitio.

Lectura correcta: no es un censo, pero la tendencia es clara: el contenido sintético crece exponencialmente y compite por el mismo escaparate (SERPs y respuestas de asistentes) que el contenido humano.

Implicaciones para el ecosistema de IA (y de contenidos)

1) Buscadores y asistentes: del “detectar” al “verificar”

Los detectores son útiles, pero frágiles ante textos editados. La salida es impulsar procedencia y trazabilidad (p. ej., C2PA), metadatos de autoría y revisión, y re-ranking por utilidad, evidencia y actualidad. Veremos más señales de origen, citación visible en respuestas y penalizaciones a granjas de contenido redundante.

2) Modelos y MLOps: riesgo de “colapso sintético”

Si los datasets de entrenamiento y RAG se llenan de texto generado por IA, aparecen riesgos de deriva y contaminación (errores que se reciclan, pérdida de diversidad estilística y factual). Para equipos de plataforma:

- Curación de fuentes con provenance;

- Canales de first-party data (propios);

- Filtros anti-sintético y deduplicación;

- Evaluaciones humanas continuas (red-teaming, fact-checking).

3) Marcas y SEO: el volumen deja de ser ventaja

La estrategia de “publicar más que nadie” se commoditiza. Ganan páginas pilar vivas, datos propios, herramientas (calculadoras, comparadores), casos reales y pruebas. El E-E-A-T se mide con evidencias, no con palabras clave.

4) Medios: volver al “moat” del reporting

Si la IA puede escribir una guía “qué es X”, la ventaja es aquello que no puede: investigar, llamar, contrastar, acceder a fuentes y publicar datasets. Transparencia sobre el uso de IA (y revisión humana) suma confianza.

5) Regulación y compras de medios: métricas y brand safety 2.0

Anunciantes y administraciones van a exigir origen demostrable, sistemas anti-fraude adaptados a IA, inclusión de inventario con procedencia y controles de alucinaciones y copyright en campañas generativas.

Hacia dónde vamos si no cambiamos los incentivos

- Inflación de palabras, deflación de valor: si el CPM y el SEO premian volumen, la IA inundará de textos “correctos pero intercambiables”.

- Web de resúmenes: capas de IA que resumen otras capas de IA → ecos de errores y fuentes cada vez menos visibles.

- Desconfianza por defecto: el usuario exigirá pruebas, fechas, firmas y datos; será menos tolerante con errores en contenidos no verificados.

El problema no es la IA per se; es el modelo de incentivos. Si medimos éxito por cantidad y clics, la IA optimiza eso hasta el absurdo. Cambiar la pendiente exige premiar procedencia y utilidad.

Qué pueden hacer hoy los equipos de IA y contenido

Equipos de plataforma/IA

- Implantar provenance (C2PA/metadatos) en generación y RAG.

- Curar corpus con filtros anti-sintético; priorizar first-party data.

- Añadir gates humanos en flujos críticos (human-in-the-loop, evaluación continua).

Medios y marcas

- Consolidar “páginas pilar” con datos propios y actualizaciones trazables.

- Publicar métodos y datasets descargables; facilitar citación.

- Etiquetar el uso de IA y documentar la revisión editorial.

SEO/Distribución

- Pasar de “cantidad” a resolución de tareas (herramientas, checklists, comparadores).

- Enlazar fuentes primarias y evidencias; reforzar autoría y revisión.

Compras/Ads

- Incluir criterios de procedencia y verificación en la planificación.

- Exigir métricas de engagement genuino y controles anti-fraude adaptados a IA.

Conclusión: más señal, menos eco

El estudio de Graphite no es el veredicto final, pero clava la dirección: la web se está llenando de texto generado por máquinas. La respuesta no es prohibir la IA, sino gobernarla: elevar el listón con procedencia verificable, utilidad medible y evidencia. En un mar de contenido sintético, lo escaso vuelve a ser lo valioso: hechos, datos, criterio y diseño de producto al servicio del usuario.

Preguntas frecuentes

¿Puedo fiarme de un detector para decidir si un artículo es de IA?

Úsalo como señal, no como sentencia. Los detectores fallan con textos híbridos o editados. Complementa con procedencia (C2PA), metadatos y revisión humana.

¿Cómo evito que mi RAG/entrenamiento se contamine con contenido sintético?

Prioriza first-party data, añade filtros anti-sintético, deduplicación, auditorías periódicas y evals humanos. Documenta origen y licencias.

¿Qué cambia en SEO cuando la IA puede publicar a escala?

El volumen deja de dar ventaja. Posicionan páginas útiles con evidencias, datos propios, herramientas y autoría clara. Optimiza para tareas y confianza, no sólo para keywords.

¿Cómo ser transparente si uso IA para producir contenido?

Declara los casos de uso, mantén registro de cambios, añade firmas/fechas de revisión y etiquetas visibles cuando corresponda. En sectores sensibles, aplica doble validación y cita fuentes.

vía: seocretos y graphite.io